回到 AlphaGo 打敗棋王的那一天,看 AI 如何顛覆世界——《AI 製造商沒說的祕密》

谷歌收購深度心智(DeepMind)幾週後,深度心智創辦人德米斯.哈薩比斯(Demis Hassabis)與其他幾位深度心智研究人員搭機來到北加州,與他們母公司的領袖舉行會議,並向他們展示深度學習如何破解「打磚塊」。

幕後推手——德米斯.哈薩比斯 會議結束後,哈薩比斯和谷歌創辦人賽吉.布林(Sergey Brin)聊了起來。他們聊著聊著發現有一共同的興趣:圍棋 。布林表示當初他和賴利.佩吉(Larry Page)建立谷歌時,他沉迷在圍棋中,害得佩吉擔心他們根本無法成立公司。

哈薩比斯表示,如果他和他的團隊想要的話,他們能夠建造一套系統來打敗世界冠軍。「我覺得這是不可能的。」布林說道。就在這一刻,哈薩比斯下定決心要做到。

深度心智創辦人、英國人工智慧研究者——德米斯.哈薩比斯(Demis Hassabis)。圖/維基百科 「深度學習運動之父」傑弗瑞.辛頓(Geoffrey Hinton)將哈薩比斯比作羅伯.奧本海默(Robert Oppenheimer),二戰期間做出第一顆原子彈的曼哈頓計畫主持人。奧本海默是世界級的物理學家:他懂得眼前重大任務的科學原理,不過他更深諳激勵之道,他結合手下不斷擴大的科學家,將他們的力量合而為一,並且接納他們的弱點,一起為計畫目標努力。

他知道如何感動男人(以及女人,包括辛頓的堂姊瓊安.辛頓),辛頓在哈薩比斯身上看到同樣的特質。「他主持 AlphaGo 就像奧本海默主持曼哈頓計畫,如果是別人來主持,他們可能就不會這麼快成功。」辛頓說。

揭開比賽序幕 深度心智的研究員們在 2014 年中曾發表一篇關於他們初期研究的論文,之後他們的研究規模大為擴大,並在第二年擊敗歐洲圍棋冠軍樊麾。此一結果震驚了全球圍棋界與人工智慧研究圈,但是 AlphaGo 對戰李世乭所造成的聲勢更是轟動。

IBM 的深藍超級電腦 1997 年在曼哈頓西城的一棟高樓裡擊敗世界頂尖的西洋棋高手,為電腦科學建立了一座里程碑,受到全球新聞界的廣為報導。但是若是與首爾的這場人機大戰相比,卻是小巫見大巫。在韓國——更別提日本與中國——圍棋是民族性的消遣活動。有超過二億人會觀看 AlphaGo 與李世乭的對弈,觀眾比超級盃多上一倍。

圍棋在中、日、韓具民族性,AlphaGo 與李世乭的對弈備受矚目。圖/維基百科 在總共五局對戰前夕的記者會上,李世乭誇口他能輕鬆獲勝:四比一或五比零。大部分的圍棋棋手也都有同感,雖然 AlphaGo 徹底擊敗樊麾,顯示這部機器是真正的贏家,但是樊麾的棋力遠不及李世乭。根據用來評估遊戲對戰能力的 ELO 等級制度,李世乭完全是在不同的等級。但是哈薩比斯卻認為這場人機大戰會有截然不同的結果。

第二天下午,在展開第一局對戰的兩小時前,他與幾名記者共進午餐,他拿著一份《韓國先驅報》(Korea Herald),這是用桃色紙張印刷的韓國英文日報。他和李世乭的照片都出現在報紙的頭版上半部。他沒有想到竟會受到如此重視。

「我知道會受到關注,」這位像孩子般矮小,39 歲但已禿頂的英國人說道,「但是沒有想到會這麼多。」不過,在吃著餃子、韓式泡菜的午餐時,哈薩比斯表示他對這場棋賽「審慎樂觀」。他解釋,那些名嘴並不知道 AlphaGo 在十月的棋賽後仍在繼續苦練棋藝。

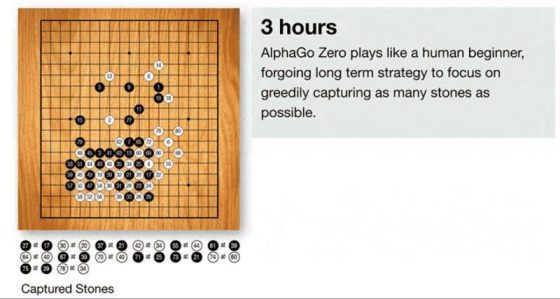

他和他的團隊初始是將三千萬步棋路輸入深度神經網路來教導機器學習圍棋,自此之後,AlphaGo 就開始不斷與自己對弈,並且記錄哪些棋路是成功的,哪些又是失敗的——其運作與實驗室用來破解雅達利老遊戲的系統類似。自擊敗樊麾以來這幾個月,AlphaGo 已和自己對弈了數百萬局;AlphaGo 持續自學圍棋,學習速度之快遠超過所有人類。

在四季飯店頂樓的賽前餐敘,谷歌董事長艾力克.施密特(Eric Schmidt)坐在哈薩比斯的對面,以他一貫冷峻的態度闡述深度學習的優點。一度有人稱他為工程師,他糾正他們,「我不是工程師,」他說道,「我是電腦科學家。」

艾力克.施密特(Eric Schmidt)2001~2011 年間在 Google 擔任 CEO。圖/維基百科 他回憶他在 1970 年代研讀電腦科學時,人工智慧看來前景一片大好,但是隨著 1980 年代過去,進入 1990 年代,這樣的美景從未實現。如今,終於實現了。「這一科技,」他說道,「力量強大,引人入勝。」他表示,人工智慧不只是辨識照片的戲法,同時也代表谷歌 750 億美元的網際網路事業與其他無數的產業,包括保健產業。

機器與人類高手對決 在第一局,哈薩比斯是在私人觀賞室與走廊另一頭的 AlphaGo 控制室之間來回兩頭跑。控制室滿是個人電腦、筆記型電腦與平面顯示幕,這些設備全都與遠在太平洋彼端的谷歌數據中心內部數百台電腦相連。一支谷歌團隊在比賽前一週就已架設一條專屬的超高速光纖電纜直達控制室,以確保網際網路暢通無阻。

不過結果卻顯示控制室根本不需要進行多少操控:幾過多月的訓練之後,AlphaGo 已能完全獨力作業,不需要人為的幫助。同時,就算哈薩比斯與團隊想幫忙,也無用武之地。他們沒有一人的圍棋棋力達到大師級的水準,他們只能觀看棋局。

「我無法形容有多緊張,」深度心智研究員說道,「我們不知道該聽誰的。一邊是評論員的看法,你同時也看到 AlphaGo 的評估。所有的評論員都有不同的意見。」

在第一天的棋賽,深度心智團隊與谷歌的重要人物都親眼目睹 AlphaGo 獲勝。

賽後記者會上,李世乭面對來自東、西方數百名記者與攝影師表示他感到震驚。這位 33 歲的棋士透過口譯員說道:「我沒想到 AlphaGo 下棋竟能夠如此完美。」經過逾四小時的對弈,AlphaGo 證明自己的棋力可與全球最厲害的高手匹敵,李世乭表示他被 AlphaGo 殺了個措手不及,他在第二局會改變策略。

左為代替 AlphaGo 移動棋子的深度心智台灣研究員黃士傑,右則為李世乭。圖/YouTube 神來一筆的第三十七手 第二局對弈進行一小時後,李世乭起身離開賽場,走到露台抽菸。坐在李世乭對面,代替 AlphaGo 移動棋子的是來自台灣的深度心智研究員黃士傑,他將一枚黑子落在棋盤右邊一大塊空地上單獨一枚白子的側邊下方,這是該局的第三十七手。

在角落的評論室內,西方唯一的圍棋最高段九段棋手邁克.雷蒙(Michael Redmond)忍不住多看了一眼確認,然後他告訴在線上觀看棋賽的兩百多萬英語觀眾:「我真的不知道這是高招還是爛招。」他的共同評論員克里斯.戈拉克(Chris Garlock)則表示:「我認為下錯了。」他是一本網路圍棋雜誌的資深編輯,同時也是美國圍棋協會的副會長。

李世乭在幾分鐘後返回座椅,然後又緊盯著棋盤幾分鐘。他總共花了 15 分鐘才做出回應,在棋局的第一階段他有兩小時的時間,而這一手占用了他不少時間——而且此後他再也沒有找回節奏。在經過逾四小時的對弈後,他投子認輸,他連輸兩局了。

第三十七手也讓樊麾大感詫異,他在幾個月前遭到 AlphaGo 徹底擊敗,自此之後他就加入深度心智,在 AlphaGo 與李世乭對弈前擔任它的陪訓員。他從來沒有擊敗過這部人工智慧機器,但是他與 AlphaGo 的對弈也讓他對棋路的變化大開眼界。事實上,他在遭 AlphaGo 擊敗後的幾週內,與(人類)高手對弈連贏六場,他的世界排名也升至新高。

現在,他站在四季飯店七樓的評論室外面,在第三十七手落子幾分鐘後,他看出了此一怪招的威力。「這不是人類會下的棋路,我從來沒有看過有人這麼下,」他說道,「太美了。」他不斷地重複說道,太美了、太美了、太美了。

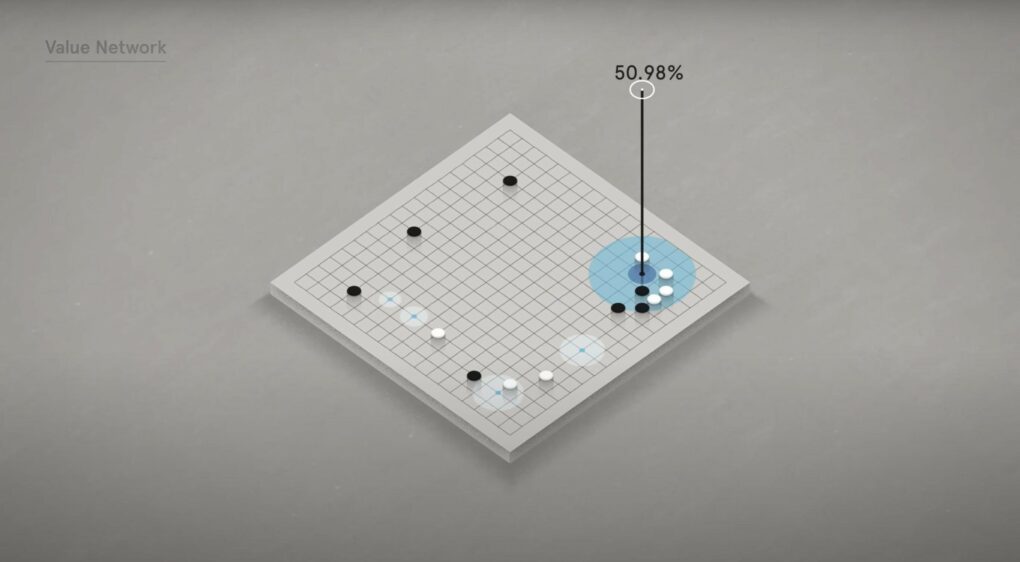

第二天上午,深度心智的研究員大衛.席瓦爾溜進控制室,他想知道 AlphaGo 如何做出第三十七手的選擇。AlphaGo 在每一局對弈中都會根據它所受過數千萬種人類落子變化的訓練,來計算人類做出此一選擇的機率,而在第三十七手,它算出的機率是萬分之一。

AlphaGo 在對弈中會根據千萬種落子變化,計算出人類下此一步棋的機率。圖/YouTube AlphaGo 知道這不是專業棋手會選擇的路數,然而它根據與自己對弈的數百萬次經驗——沒有人類參與的棋局——它仍是這麼做了;它已了解儘管人類不會選擇這一步,這一步棋仍是正確的選擇。「這是它自己發現的,」席瓦爾說道,「透過它的內省。」

這是一個既甜美又苦澀的時刻,儘管樊麾大讚此一步棋是神來之筆,但是一股鬱悶之情席捲四季飯店,甚至整個韓國。一位中國記者表示,儘管他為 AlphaGo 贏得第一局感到高興,可是現在他深感沮喪。

第二天,一位在首爾彼端經營一家新創企業育成中心的韓國人權五亨表示他也感到悲傷,這並非因為李世乭是一位韓國人,而是因為他是人類,「這是全人類的轉捩點,」權五亨說道,他的幾位同事點頭表示同意,「它讓我們了解人工智慧真的已在我們眼前——也讓我們了解到其中的危險。」

在那個週末,此一鬱悶的情緒只增不減。李世乭第三局也輸了,等於輸掉整個棋賽。坐在賽後記者會的桌子後面,李世乭懺悔之情溢於言表。「我不知道今天要說什麼,但是我首先要表達我的歉意,」他說道,「我應該拿出更好的成績,更好的結局,更好的比賽。」但是坐在李世乭身邊的哈薩比斯卻發現,自己衷心期盼這位韓國棋手在接下來的兩局中至少能贏一局。

AlphaGo 認輸的那一局 在第四局的七十七手,李世乭再度陷入長考,就和第二局的情況一樣,但是這一回他考慮的時間更久。棋盤中間有一堆棋子,黑白相間,他有近二十分鐘只是緊盯著這些棋子,抓著後頸前後擺動。最後,他將他的白子落在棋盤中央的兩枚黑子之間,將棋勢一分為二,AlphaGo 方寸大亂。

在每一場對弈中,AlphaGo 都會不斷重新計算勝率,並且顯示在控制室的一台平面顯示幕上。

在李世乭落子後——第七十八手——這部機器的反擊很差,在顯示幕上的勝率立刻大降。「AlphaGo 累積到那一步之前的所有戰略都算是報銷了,」哈薩比斯說道,「它必須重新再來。」就在此刻,李世乭抬頭看著對面的黃士傑,彷彿他擊敗的是這人,不是機器。自此之後,AlphaGo 的勝率一路下跌,在近五個小時後,它投子認輸。

DeepMind 製作的 AlphaGo 與李世乭對弈紀綠片。/YouTube 兩天後,哈薩比斯穿過四季飯店的大廳,解釋 AlphaGo 為什麼會輸。AlphaGo 當時是假設沒有人類會這樣下第七十八手,它計算出來的機率是萬分之一——這是一個它熟悉的數字。

就像 AlphaGo 一樣,李世乭的棋力也達到一個新境界,他在棋賽最後一天的私人聚會場合中這樣告訴哈薩比斯。他說與機器對弈不僅讓他重燃對圍棋的熱情,同時也讓他茅塞頓開,使他有了新想法。「我已經進步了。」他告訴哈薩比斯,一如幾天前的樊麾,李世乭之後與人類高手對弈,連贏九場。

AlphaGo 與李世乭的對弈,使得人工智慧在世人眼前大爆發,它不僅是屬於人工智慧領域與科技公司,同時也是屬於市井小民的里程碑。在美國如此,在韓國與中國更是如此,因為這些國家視圍棋為人類智慧結晶的巔峰。這場棋賽彰顯出科技的力量與其終將超越人類的恐懼,同時也帶來樂觀的前景,此一科技往往會以出人意表的方式推動人類更上層樓。儘管馬斯克等人警告其中的危險性,但是這段時期人工智慧的前景一片光明。

裘蒂.英賽恩(Jordi Ensign)是佛羅里達州一位四十五歲的程式設計師,她在讀完棋賽報導後出去在身上紋了兩幅刺青,她在右臂內側紋了 AlphaGo 的第三十七手——左臂紋了李世乭的第七十八手。

——本文摘自《AI製造商沒說的祕密: 企業巨頭的搶才大戰如何改寫我們的世界? 》,2022 年 8 月,時報出版 ,未經同意請勿轉載 。