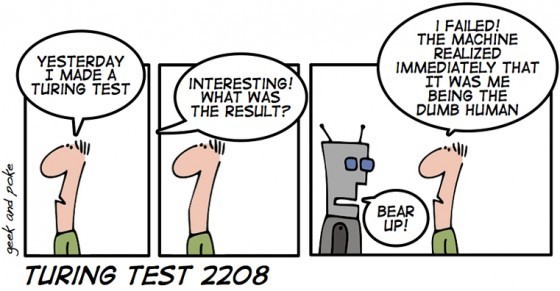

1950 年10 月,圖靈在《心智》(Mind)期刊發表了第二篇重要論述〈計算機器與智能〉時,在論文中設計了所謂的「圖靈測試」。圖靈一開始先明確聲明:「我提議大家思考以下問題:『機器能不能思考?』」他像個愛玩的孩子般發明了一個遊戲(直到現在還有人玩這個遊戲,並為之爭辯不休),賦予上述問題實證的意義。他為人工智慧提出了純粹操作型定義:假如我們分辨不出機器的產出和人類大腦思考的結果有何不同,那麼就沒有理由堅持機器不會「思考」。

圖靈稱為「模仿遊戲」的測試其實很簡單:提問者會事先寫好問題,然後對不同房間的人與機器提問,再根據他們的回答辨認哪個房間裡的答題者是人,不是機器。他寫道,以下是題目範例:

問:請以福斯橋為題,寫一首十四行詩。

答:別指望我。我從來都不懂寫詩。

問:34,957 加70,764 等於多少?

答:(停頓30 秒後,給的答案是)105,621。

問:你會下西洋棋嗎?

答:會。

問: 我的棋子K 在K1 位置上,此外沒有其他棋子了。你只有K6 位置上的棋子K 和R1 位置上的棋子R。輪到你走,你要怎麼下這一步?

答:(停頓15 秒後)棋子R 走到R8,將軍。

在這段對話範例中,圖靈做了幾件事。仔細檢查後發現,答題者在計算了三十秒後,仍犯了個小錯誤(正確答案是105,721)。這樣就足以證明答題者是人嗎?也許吧。不過,也說不定是機器在處心積慮假扮人類。傑弗遜的反對意見(機器不會寫十四行詩)也遭圖靈輕鬆反駁:上面的答案說不定是人類答題者在承認自己的不足。圖靈後來在論文中,以下列提問內容說明:以能否創作十四行詩為標準,來判斷答題者究竟是人或機器,其實不是那麼容易:

問: 你的十四行詩在第一行說「你好比夏日」,那麼用「春天」來形容也一樣嗎,還是會更好?

答:這樣不合詩的韻律。

問:那假如用「冬日」呢,這樣就能押韻了。

答:對,可是沒有人想被比擬為冬日。

問:你覺得皮克威克先生會讓你想起聖誕節嗎?

答:或多或少吧。

問: 可是聖誕節的時候正逢冬天,我認為皮克威克先生不會介意這樣的比喻。

答: 你不是當真吧。「冬日」的意思是指典型的冬天,而不是像聖誕節這樣的特殊節日。

圖靈的觀點是,或許我們根本無從判斷答題者究竟是真人,或只不過是機器在假扮人。究竟電腦能否在這場模仿遊戲中勝出,圖靈的猜測是:「我相信大約要到五十年後,人類才有能力設計出電腦程式⋯⋯ 讓電腦玩模仿遊戲的功力高強到,一般人質問電腦五分鐘後,能正確判斷的機率低於七成。」

圖靈也試圖在論文中為他所定義的思考提出辯駁。神學界的異議著眼於,世間萬物中,上帝只賦予人類靈魂和思考能力;圖靈則加以駁斥,認為他們的觀點「暗自為無所不能的上帝設下嚴重限制」。他問道,只要上帝「認為適當」,祂能否「自由賦予大象靈魂」?假設如此,那麼依照相同的邏輯(諷刺的是,這樣的邏輯居然出自沒有宗教信仰的圖靈),只要上帝想這麼做,祂自然可以讓機器也擁有靈魂。

最有趣的反對意見(尤其對本書而言),則是愛達的看法。「分析機不會聲稱自己創造了任何東西,」她在1843 年寫道:「它可以執行任何我們懂得命令它做的事情,但它沒有能力預言任何分析關係或真相。」換句話說,機械裝置和人類心智不同的是,機器沒有自由意志,也無法採取主動,只能依照設定的程式執行任務。圖靈則在1950 年發表的論文中,特別撥一些篇幅來討論「勒夫雷思夫人的反對意見」。

針對愛達的反對意見,圖靈最有創意的反駁是辯稱:機器或許有能力透過學習而開始產生主體性,有能力創造新的思維。「與其試圖設計程式來模擬成人心智,何不乾脆製造出能模擬孩童的程式?」他問:「透過適當的教育,或許可讓它擁有成年人的腦力。」他承認,機器的學習過程和孩童不一樣。「比方說,機器沒有腳,所以你不能叫他到屋外鏟煤,把桶子裝滿。機器可能也沒有眼睛⋯⋯ 你不能送機器去上學,因為其他孩子會拚命取笑它。」所以,必須想其他法子來教育機器寶寶。圖靈建議利用獎勵和懲罰機制,引導機器重複某些行為和避免某些行為,最後機器自然會發展出一套自己的判斷方式。

但圖靈的批評者指出,即使機器真能模擬人類思考,仍然不具備真正的意識。當參與圖靈測試的人類使用文字時,會把文字連結到真實世界代表的意義、情感、經驗和知覺,機器則不然。然而如果缺乏這樣的連結,語言就完全脫離意義,只是一場遊戲。

對圖靈測驗最歷久不衰的挑戰,正是由這類反對意見引發的:1980 年,哲學家瑟爾(John Searle)提議進行一項名為「中文房間」的想像實驗。進行實驗時,房間裡有個人只會講英語,對中文一竅不通,他拿到一本完整的中文指南,教他在面對任何中文字組合時,如何依照規則形成新的中文字組合,然後把答案遞出房間。只要教學手冊寫得夠完整,這個人或許能讓提問者信以為真,以為他真的懂中文。儘管如此,他完全不了解自己的答案究竟在說什麼,也沒有展現任何意圖。套用愛達的說法,他完全說不上有任何原創力,只不過聽命行事罷了。同樣的,無論圖靈模仿遊戲中的機器能多麼逼真的模仿人類反應,機器仍然不了解、也無法意識到自己在說什麼。所以,說機器懂得「思考」,就好像說那個照著中文指南依樣畫葫蘆的人懂中文一樣。

針對於瑟爾的觀點,反對者辯稱,即使這人並非真的懂中文,中文房間裡的整套系統,包括這個人(處理單位)、中文指南(程式)和充滿中文字的檔案(資料),加總起來可能真的理解中文。這很難有定論。的確,圖靈測驗和反駁圖靈測驗的論點,迄今仍是認知科學領域最火熱的爭辯主題。

圖靈在完成〈計算機器與智能〉幾年後,似乎十分樂於參與這場他挑起的爭論。對於那些一味嘮叨著十四行詩和意識問題的批評者,他以反諷式的幽默挑撥他們:「有朝一日,女士會帶著電腦在公園裡散步,互相閒聊著:『今天早上,我的電腦說的事情好好!』」他在1951 年如此戲謔的說。他的老師紐曼後來指出:「他說明自己的想法時,會用種種好笑但聰明的比喻,和他聊天十分愉快!」

有別於機器,性慾和情感欲望在人類思考中扮演的角色,是許多人和圖靈討論時一再提及的題目,而且不久之後就引發悲劇性的回響。1952 年1 月,BBC 在電視上播出圖靈與腦外科醫師傑弗遜的辯論,這場辯論會由紐曼和科學哲學家布瑞斯維特(Richard Braithwaite)一起主持。「人類的興趣大體上是由欲望、渴求、衝動和本能所決定,」布瑞斯維特指出。他認為,要創造出真正能思考的機器,「似乎必須讓機器擁有相當於欲望的東西。」紐曼插話指出,機器的「欲望很有限,感到尷尬時也不會臉紅。」傑弗遜更進一步,不斷拿「性衝動」為例,提及「人類與性相關的情感和本能」。他說,男人飽受「性衝動」所苦,「有時可能讓自己出醜」。他大談性慾如何影響人類思考,以致於BBC 不得不剪掉一部分內容之後才播出,包括他提到除非親眼見到機器去摸另一部女性機器的大腿,否則他不相信機器也能思考。

圖靈當時仍小心隱瞞自己的同性戀傾向,在討論到這部分時,一直沉默不語。這個節目在1952 年1 月10 日播出,而圖靈在辯論會錄影前幾個星期忙的事情可說充滿人性,遠非機器所能理解。由於剛完成一篇科學論文,圖靈在他寫的短篇故事中談到他打算如何慶祝:「事實上,他孤家寡人好一段時間了,自從去年夏天在巴黎遇見那個大兵以來,就一直無人作伴。既然論文已經完成,或許他理當找個同志作伴,而他很清楚到哪兒可以找到適當人選。」

圖靈在曼徹斯特的牛津街上,挑上了工人階級出身的十九歲流浪漢默瑞(Arnold Murray),兩人開始交往。錄完影回來,他邀請默瑞搬到他家。一天晚上,圖靈告訴年輕的默瑞,他曾經幻想和一部兇惡的電腦對弈,而他因為成功引發電腦展現怒氣、開心和自以為是,而擊敗電腦。接下來一段時間,兩人的關係變得愈來愈複雜,有一天晚上,圖靈回家時發現家裡曾遭竊賊闖入,犯案者是默瑞的朋友。圖靈向警方報案時,透露自己和默瑞的性關係,於是警方以猥褻罪名逮捕圖靈。

這個案子在1952 年3 月審判,圖靈當庭認罪,但說自己並不後悔。紐曼出庭擔任品格證人。圖靈被定罪並剝奪參與機密計畫的資格,同時還面臨兩個選擇:入獄服刑,還是接受荷爾蒙治療以獲得緩刑,藉由注射合成雌激素抑制性慾,彷彿他是化學藥物控制的機器。圖靈選擇後者,忍受了一年的荷爾蒙治療。

圖靈起初從容面對打擊,後來卻在1954 年6 月7 日,吃下沾了氰化物的蘋果自殺。他的朋友指出,〈白雪公主〉故事中,邪惡王后把蘋果浸在毒藥中的畫面,一直很令他著迷。圖靈被發現時躺在床上,口吐白沫,體內有氰化物反應,身旁有一顆咬了一半的蘋果。機器會做出這樣的事情嗎?

本文摘自《創新者們:掀起數位革命的天才、怪傑和駭客》,由天下文化出版。

延伸閱讀

- 如果你想了解登入帳戶時所需的驗證碼和圖靈測試的關係…

網路驗證碼與電腦科學之父 - 如果你想更了解圖靈…

【科學史上的今天】6/23——圖靈誕辰(Alan M. Turing, 1912-1954)