- 本文轉載自科技大觀園,原文為《人工智慧讓羽球訓練更聰明!》

- 作者/郭雅欣|科技大觀園特約編輯

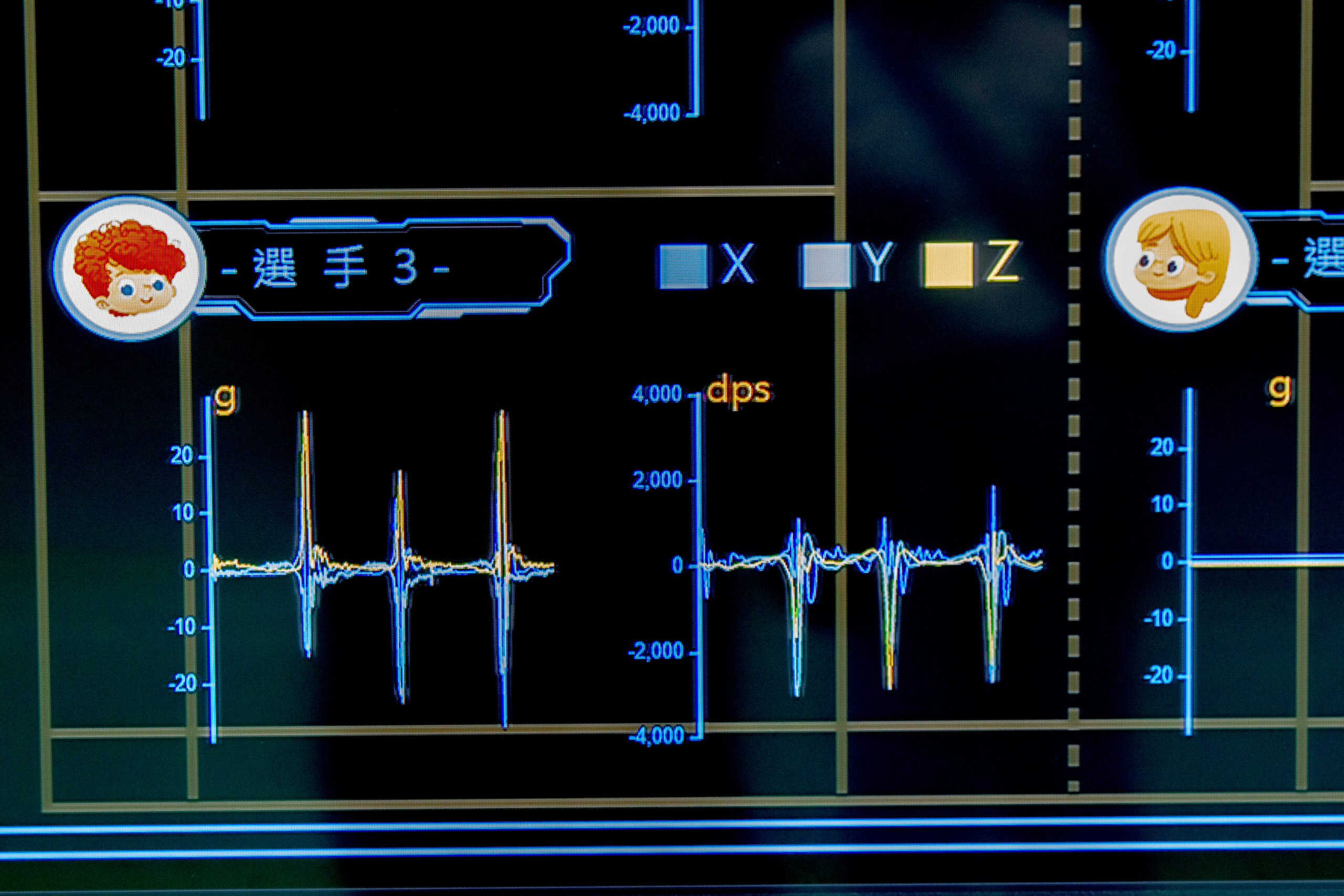

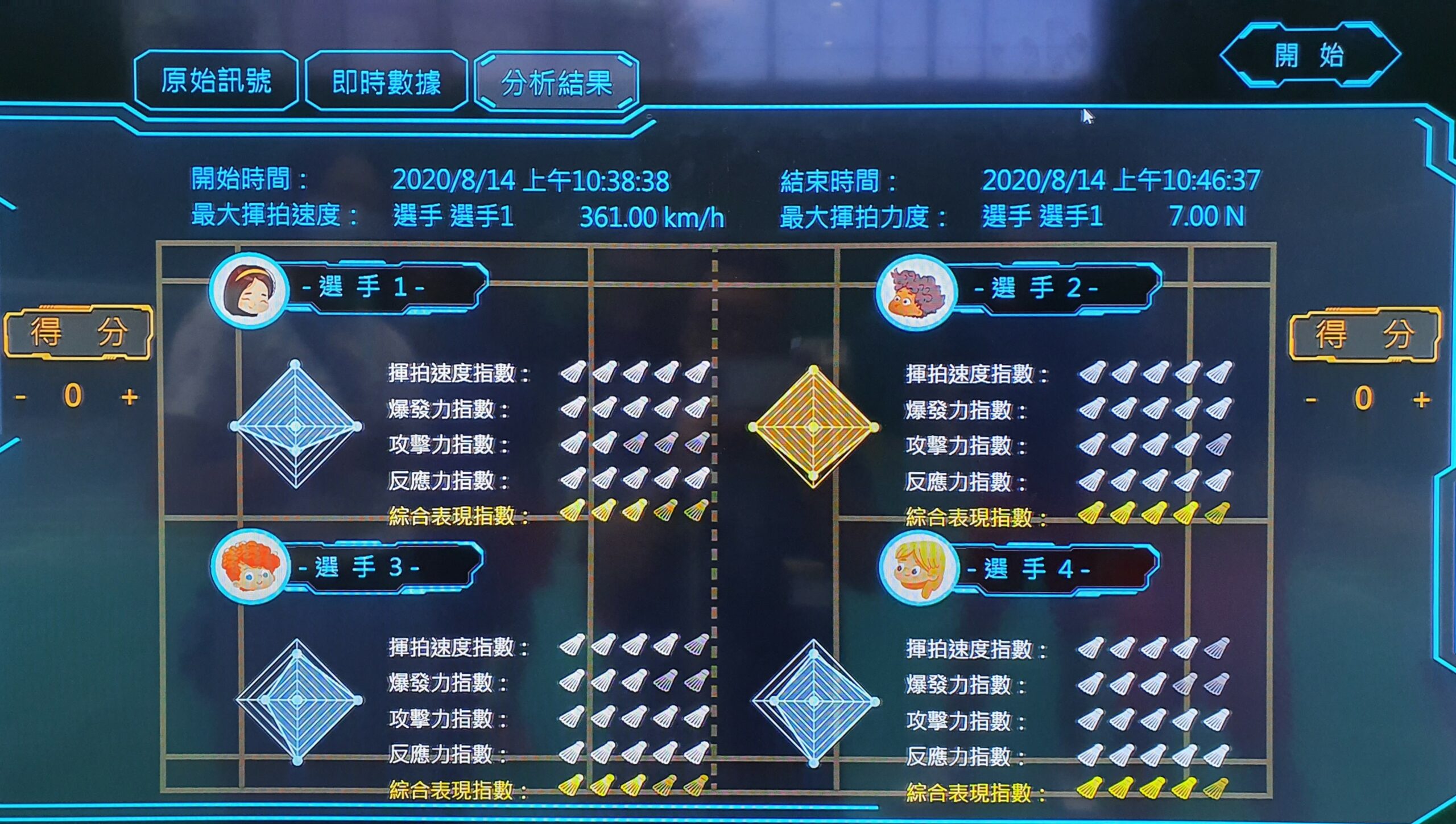

「啪!」「啪!」在臺南新豐高中的羽球場上,球拍強力揮擊的聲響不絕於耳,幾位選手正奮力廝殺著。但這場羽球賽有點不同,因為旁邊還架著一具電視螢幕,而選手手上的球拍也不太一樣。練習賽結束後,教練與選手聚集在螢幕前,對著螢幕上的揮拍速度、爆發力指數等數據,熱烈地討論了起來。

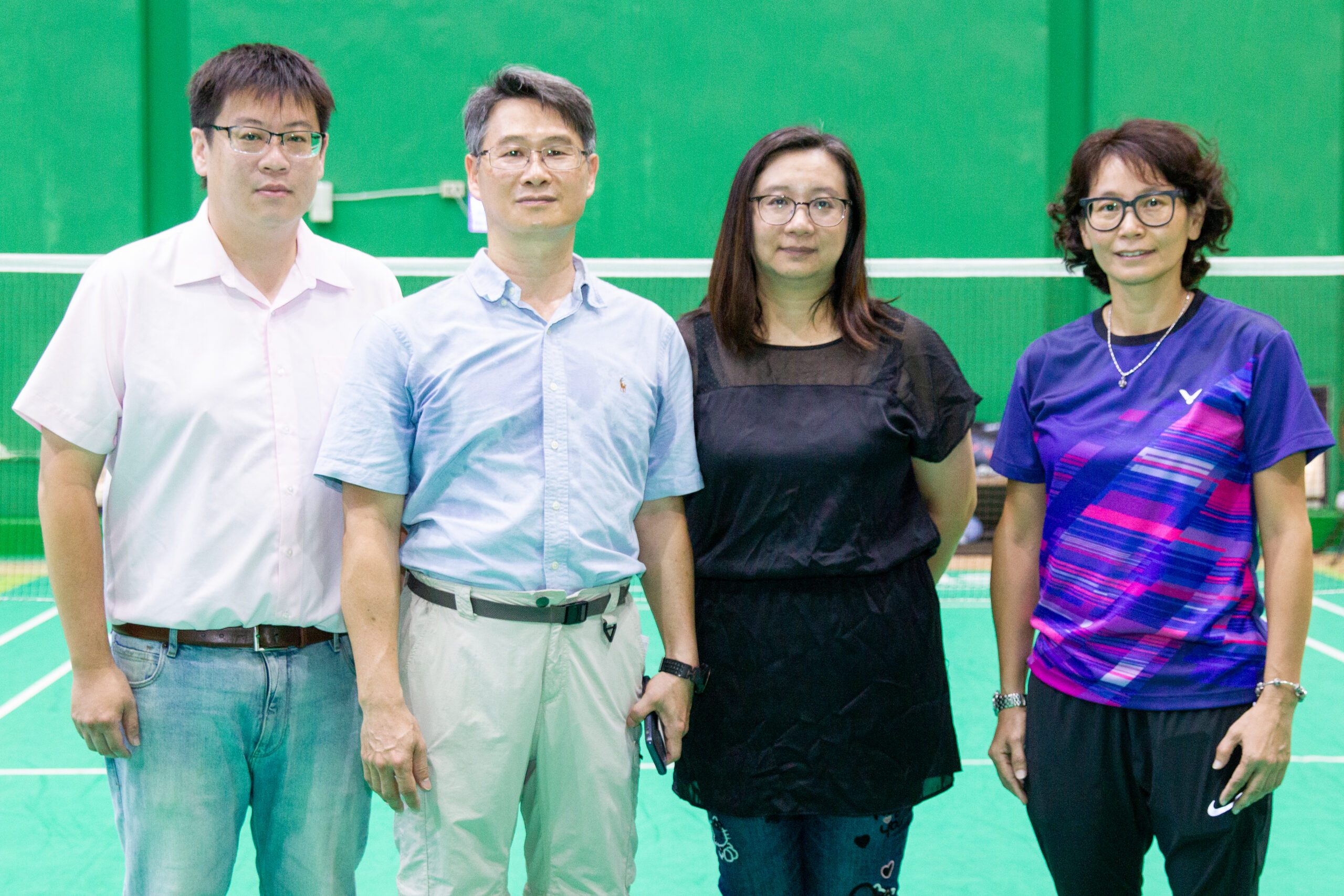

會出現這麼特殊的景象,是因為新豐高中的羽球隊從去年(2019年) 5 月起,開始做為科技部計畫「從中樞系統建構雲端 AI 運動訓練歷程分析與疲勞診斷系統:以羽球項目為例」(以下簡稱「AIOT 智能羽球訓練模式」)的實驗基地,而這個計畫由成功大學體育健康與休閒研究所特聘教授蔡佳良領軍,希望利用人工智慧,將羽球的訓練科學化,達到最有效精準的訓練效果。

這項計畫包含五個部分,包括智能球拍、智能手錶、高速攝影動作捕捉,以及雲端 AI 運算中心和顯示各項運動與生理數值的 APP。智能球拍、智能手錶、高速攝影負責收集運動資訊,將資訊以 Wifi 網路上傳到雲端的 AI 運算中心計算後,結果呈現在電腦螢幕及專用的手機 APP 上,讓教練與選手一目了然。

計畫中使用的雲端計算中心是成大電機系教授王振興所主持的人工智能數位轉型研究中心 ,智能球拍、手錶等裝置不斷上傳的資料,會持續訓練 AI 演算法自身,讓演算法變得愈來愈精準。

為了讓訓練過程面面俱到,蔡佳良組了一支跨領域的「黃金陣容」,除了專研腦波與眼動的自己外,還找了工程專業的成大電機系教授王振興、負責 AI 演算法的逢甲大學自動控制工程學系副教授許煜亮、專研運動傷害的成大物理治療系副教授蔡一如,每位成員的專業領域都不一樣,在計畫中各司其職。

聰明的智能球拍

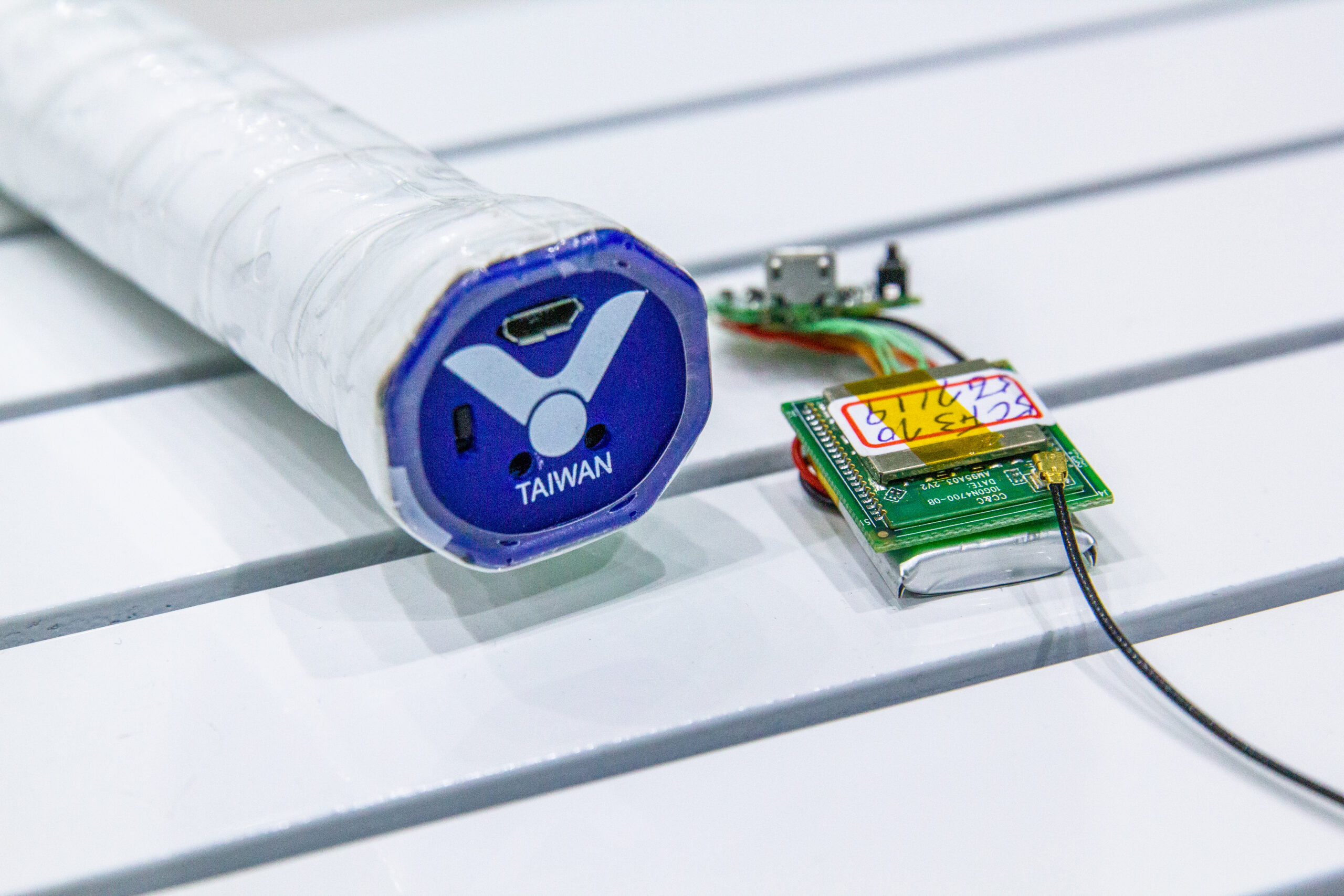

計畫中的一大重點,就是選手手上那支「智能球拍」,它可以收集選手的揮拍力道、轉動角度等數值,經過計算後,能知道揮拍速度、軌跡,還能分辨出九個不同的球種,這是因為球拍的握把中藏了一個感測晶片。

在握把中放入感測晶片就能做到,聽起來很容易,但在羽球拍上卻沒那麼簡單。蔡佳良說:「羽球選手對球拍的重量可是很要求的,一般選手使用的球拍大約 80 幾克,重一點輕一點,手感就差很多了。」而一個晶片動輒 10 幾克,直接放上球拍,不但影響重量,還改變了球拍的重心位置,「這樣的球拍沒有人會想用。」蔡佳良說。

後來,蔡佳良找了勝利體育公司合作,在以碳纖維為材料的握把中納入晶片,並盡量減少晶片重量,才做出了目前的智能球拍。蔡佳良說:「不過我們還是想再縮小晶片的重量,看看是否能讓晶片的電池小一點,希望能將球拍再減少 5 公克左右。」

你累了嗎?疲勞狀態對訓練來說很重要!

有了能收集選手打球狀況的智能球拍還不夠,蔡佳良還希望能將選手的「疲勞狀態」也納入訓練的參考,這也是接下來 AIOT 智能羽球訓練模式的發展重點。

蔡佳良與蔡一如指出,疲勞分成「中樞神經疲勞」與「周邊神經疲勞」,中樞神經疲勞反應在腦的專注力、心理上的鬥志等,例如比賽時間過長,或是選手心態上已經認輸等,這可以從選手的腦波及眼動訊號來判斷;而周邊神經疲勞則反應在肌肉的動作,例如選手的移動腳步可能變慢、揮拍動作變小等。此外,長時間受訓練的選手也可能慢性疲勞,儘管身體好像沒怎麼樣,但可能一早起床就覺得特別累,不想練球等。

分析選手的疲勞狀態,還可以進一步預防選手受傷,在選手有一點點受傷徵兆時,例如動作稍微改變時,就及時察覺,讓選手休息或就醫,這對於延長選手的運動生涯來說是很重要的。

你的疲勞,AI 比你先發現

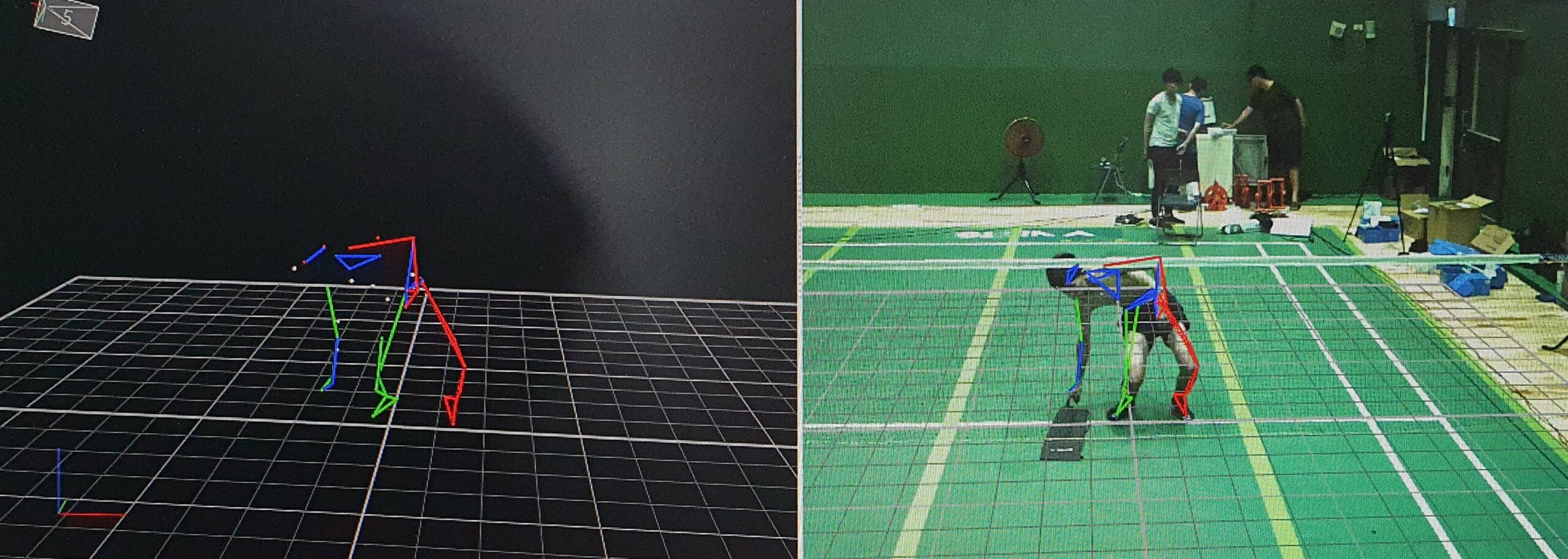

為了偵測選手的肌肉疲勞狀況,重建選手的動作也是這次計畫的重點之一。蔡佳良說:「一般來說,我們是用『光學式動作捕捉系統』來重建選手的運動姿態。」這是一套專門的系統,選手的身上會貼滿光點,由四面八方的攝影機拍攝光點的移動,來重建選手動作。「不過這套系統太昂貴了,」蔡佳良說:「因此我們希望用一般的高速攝影機來取代。」方法是先以光學式動作捕捉系統找出界定選手疲勞與否的標準(稱為黃金標準),再將黃金標準與高速攝影機的影像共同輸入電腦,訓練電腦以高速攝影機的影像重建選手動作,並判別選手疲勞狀態。

蔡佳良補充說:「等到我們把高速攝影機這一塊做起來,就會推廣到一般球館。」換句話說,未來一般民眾在運動中心等球館打球時,或許就能透過場館附設的高速攝影機,看見自己的動作及打球狀態,雖然不是職業選手,也可以研究自己的動作,享受運動科技帶來的好處。

智能手錶則由選手整天佩戴著,記錄選手日常的心跳及睡眠狀態,教練可以據此觀察選手生理狀況,也能輔助判斷疲勞狀態。計畫中使用的智能手錶由王振興研發,蔡佳良表示:「我們自己研發而不採用市面上的手錶,這樣可以依據我們的需求來收集資訊,也可以避免個資外洩的問題。」

至於中樞神經的疲勞,可以透過腦波與眼動的狀態來發現,這也是蔡佳良的研究專長。但是蔡佳良說:「我們若要收集這些訊號,得讓選手戴上特製眼鏡,並在頭上貼特殊的貼紙,這會對選手打球造成影響。」因此,蔡佳良希望先將腦波及眼動的訊號,和智能球拍的感測訊號做連結,找出彼此的關聯,建立一個演算法,再將這個演算法寫入智能球拍的晶片中,「如果我們的演算法夠強,球拍感測訊號與腦波、眼動的關聯準確性夠高,就能直接從球拍的訊號,計算出選手的中樞神經疲勞狀況。」

學術與運動的跨領域溝通

AIOT 智能羽球訓練模式發展到目前的階段,已經可以從智能球拍的訊號,計算出個別選手的最快揮拍速度、最大擊球力道,以及爆發力、攻擊力、反應力等指數,蔡佳良笑說:「我們和教練也有一段磨合的過程,因為我們做研究的,想的都是怎樣的數據合適發表,卻不一定是教練真正需要的。」

新豐高中羽球隊的教練李宜勳也對此舉例:「一開始蔡教授的團隊提供過一個數據叫做『積極度』,判別的方式就是一場雙打比賽中擊球次數多的,就是比較積極。可是事實上,我們比賽的時候,會故意將球打給比較弱的選手,所以他們的擊球次數自然比較多,這不代表他們比較積極。」

不過,李宜勳認為將 AIOT 智能羽球訓練模式納入訓練,對選手的練習的確有幫助,「有時候教練說破了嘴,還不如數據直接攤開來看。」李宜勳笑說。看到明確的數據,選手之間也會有正向競爭,覺得不想輸給同儕,對於自己的動作或缺點也有更明確的認識。

運動訓練科學化

儘管 AIOT 智能羽球訓練模式還未真正完成,但蔡佳良對於這項研究的未來發展深具信心,他說:「我們的研究成果在其他有球拍的運動上都可以應用,例如網球。」

蔡佳良並且認為,運動科技的蓬勃發展下,未來的運動訓練一定也都會走向科學化。「其實我一開始做運動科學時,接觸過一些國家級的教練,他們對運動科學有點排斥,認為運動科學發展起來之後,會搶了他們的教練工作。但其實運動科學只是用數據輔助訓練,真正的訓練專業還是在教練身上。」蔡佳良希望現在還在起步階段,就有機會經歷科學訓練的選手,未來若是成了教練,可以經由自己的經驗,明白如何運用科技,讓訓練變得更有效率。

「我們還希望我們的成果也能普及到一般民眾,因為運動科學的市場是很大的。」蔡佳良希望將智能球拍研發完整後,普及到一般運動用品店,讓民眾也能買來使用。他說:「即使是一般民眾,若能看看自己今天打球的狀況,也是很好玩、很有趣的事情。我相信會有人想買這種智能球拍的。」