「難道,真的回不去了嗎?」「沒錯,真的回不去了…….」

塞車是春節返鄉的遊子們不得不面對的嚴峻考驗,尤其當高速公路徹底化身為一個大停車場時,更是令人絕望到想砸車窗。

究竟塞車是怎麼發生的?

______________________________

想了解更多塞車的科學?你需要看這三篇:

「難道,真的回不去了嗎?」「沒錯,真的回不去了…….」

塞車是春節返鄉的遊子們不得不面對的嚴峻考驗,尤其當高速公路徹底化身為一個大停車場時,更是令人絕望到想砸車窗。

究竟塞車是怎麼發生的?

______________________________

想了解更多塞車的科學?你需要看這三篇:

本文與 PAMO車禍線上律師 合作,泛科學企劃執行

走在台灣的街頭,你是否發現馬路變得越來越「急躁」?滿街穿梭的外送員、分秒必爭的多元計程車,為了拚單量與獎金,每個人都在跟時間賽跑 。與此同時,拜經濟發展所賜,路上的豪車也變多了 。

這場關於速度與金錢的博弈,讓車禍不再只是一場意外,更是一場複雜的經濟算計。PAMO 車禍線上律師施尚宏律師在接受《思想實驗室 video podcast》訪談時指出,我們正處於一個交通生態的轉折點,當「把車當生財工具」的職業駕駛,撞上了「將車視為珍貴資產」的豪車車主,傳統的理賠邏輯往往會失靈 。

在「停工即停薪」(有跑才有錢,沒跑就沒收入)的零工經濟時代,如果運氣不好遇上車禍,我們該如何證明自己的時間價值?又該如何在保險無法覆蓋的灰色地帶中全身而退?

過去處理車禍理賠,邏輯相對單純:拿出公司的薪資單或扣繳憑單,計算這幾個月的平均薪資,就能算出因傷停工的「薪資損失」。

但在零工經濟時代,這套邏輯卡關了!施尚宏律師指出,許多外送員、自由接案者或是工地打工者,他們的收入往往是領現金,或者分散在多個不同的 App 平台中 。更麻煩的是,零工經濟的特性是「高度變動」,上個月可能拚了 7 萬,這個月休息可能只有 0 元,導致「平均收入」難以定義 。

這時候,律師的角色就不只是法條的背誦者,更像是一名「翻譯」。

施律師解釋「PAMO車禍線上律師的工作是把外送員口中零散的『跑單損失』,轉譯成法官或保險公司聽得懂的法律語言。」 這包括將不同平台(如 Uber、台灣大車隊)的流水帳整合,或是找出過往的接單紀錄來證明當事人的「勞動能力」。即使當下沒有收入(例如學生開學期間),只要能證明過往的接單能力與紀錄,在談判桌上就有籌碼要求合理的「勞動力減損賠償 」。

根據警政署統計,台灣交通違規的第一名常年是「違規停車」,一年可以開出約 300 萬張罰單 。這龐大的數字背後,藏著兩個台灣駕駛人最容易誤判的「直覺陷阱」。

陷阱 A:我在紅線違停,人還在車上,沒撞到也要負責? 許多人認為:「我人就在車上,車子也沒動,甚至是熄火狀態。結果一台機車為了閃避我,自己操作不當摔倒了,這關我什麼事?」

施律師警告,這是一個致命的陷阱。「人在車上」或「車子沒動」在法律上並不是免死金牌 。法律看重的是「因果關係」。只要你的違停行為阻礙了視線或壓縮了車道,導致後方車輛必須閃避而發生事故,你就可能必須背負民事賠償責任,甚至揹上「過失傷害」的刑責 。

數據會說話: 台灣每年約有 700 件車禍是直接因違規停車導致的 。這 300 萬張罰單背後的僥倖心態,其巨大的代價可能是人命。

陷阱 B:變換車道沒擦撞,對方自己嚇到摔車也算我的? 另一個常年霸榜的肇事原因是「變換車道不當」 。如果你切換車道時,後方騎士因為嚇到而摔車,但你感覺車身「沒震動、沒碰撞」,能不能直接開走?

答案是:絕對不行。

施律師強調,車禍不以「碰撞」為前提 。只要你的駕駛行為與對方的事故有因果關係,你若直接離開現場,在法律上就構成了「肇事逃逸」。這是一條公訴罪,後果遠比你想像的嚴重。正確的做法永遠是:停下來報警,釐清責任,並保留行車記錄器自保 。

另一個現代駕駛的惡夢,是撞到豪車。這不僅是因為修車費貴,更因為衍生出的「代步費用」驚人。

施律師舉例,過去撞到車,只要把車修好就沒事。但現在如果撞到一台 BMW 320,車主可能會主張修車的 8 天期間,他需要租一台同等級的 BMW 320 來代步 。以一天租金 4000 元計算,光是代步費就多了 3 萬多塊 。這時候,一般人會發現「全險」竟然不夠用。為什麼?

因為保險公司承擔的是「合理的賠償責任」,他們有內部的數據庫,只願意賠償一般行情的修車費或代步費 。但對方車主可能不這麼想,為了拿到這筆額外的錢,對方可能會採取「以刑逼民」的策略:提告過失傷害,利用刑事訴訟的壓力(背上前科的恐懼),迫使你自掏腰包補足保險公司不願賠償的差額 。

這就是為什麼在全險之外,駕駛人仍需要懂得談判策略,或考慮尋求律師協助,在保險公司與對方的漫天喊價之間,找到一個停損點 。

除了有單據的財損,車禍中最難談判的往往是「精神慰撫金」。施律師直言,這在法律上沒有公式,甚至有點像「開獎」,高度依賴法官的自由心證 。

雖然保險公司內部有一套簡單的算法(例如醫療費用的 2 到 5 倍),但到了法院,法官會考量雙方的社會地位、傷勢嚴重程度 。在缺乏標準公式的情況下,正確的「態度」能幫您起到加分效果。

施律師建議,在談判桌上最好的姿態是「溫柔而堅定」。有些人會試圖「扮窮」或「裝兇」,這通常會有反效果。特別是面對看過無數案件的保險理賠員,裝兇只會讓對方心裡想著:「進了法院我保證你一毛都拿不到,準備看你笑話」。

相反地,如果你能客氣地溝通,但手中握有完整的接單紀錄、醫療單據,清楚知道自己的底線與權益,這種「堅定」反而能讓談判對手買單,甚至在證明不足的情況下(如外送員的開學期間收入),更願意採信你的主張 。

在這個交通環境日益複雜的時代,無論你是為了生計奔波的職業駕駛,還是天天上路的通勤族,光靠保險或許已經不夠。大部分的車禍其實都是小案子,可能只是賠償 2000 元的輕微擦撞,或是責任不明的糾紛。為了這點錢,要花幾萬塊請律師打官司絕對「不划算」。但當事人往往會因為資訊落差,恐懼於「會不會被告肇逃?」、「會不會留案底?」、「賠償多少才合理?」而整夜睡不著覺 。

PAMO看準了這個「焦慮商機」, 推出了一種顛覆傳統的解決方案——「年費 1200 元的訂閱制法律服務 」。

這就像是「法律界的 Netflix」或「汽車強制險」的概念。PAMO 的核心邏輯不是「代打」,而是「賦能」。不同於傳統律師收費高昂,PAMO 提倡的是「大腦武裝」,當車禍發生時,線上律師團提供策略,教你怎麼做筆錄、怎麼蒐證、怎麼判斷對方開價合不合理等。

施律師表示,他們的目標是讓客戶在面對不確定的風險時,背後有個軍師,能安心地睡個好覺 。平時保留好收入證明、發生事故時懂得不亂說話、與各方談判時掌握對應策略 。

從違停的陷阱到訂閱制的解方,我們正處於交通與法律的轉型期。未來,挑戰將更加嚴峻。

當 AI 與自駕車(Level 4/5)真正上路,一旦發生事故,責任主體將從「駕駛人」轉向「車廠」或「演算法系統」 。屆時,誰該負責?怎麼舉證?

但在那天來臨之前,面對馬路上的豪車、零工騎士與法律陷阱,你選擇相信運氣,還是相信策略? 先「武裝好自己的大腦」,或許才是現代駕駛人最明智的保險。

PAMO車禍線上律師官網:https://pse.is/8juv6k

討論功能關閉中。

每到年節時期,不管返鄉或是出遊,用路人最討厭遇到的就是塞車,漫長的等待、讓人踩剎車踩到腳痛的行車速度,抑或是被汽車廢煙包圍的感覺,本是愉悅心情恐怕都大打折扣。你也是恨不得讓「塞車」這個詞消失在這世界上的人嗎?自動駕駛或許能幫你達成心願喔~感到好奇的話,那就繼續看下去吧!

試想,人類與機器人在駕駛汽車時,要維持車與車之間等速前進,誰會 hold 得最好呢?答案很明顯是……機器人!為什麼呢?關鍵就在於「人類的反應速度」,反應速度因人而異:當老(手)司機在開車時,他們能夠對於哪時候該踩剎車、油門的反應速度快,因此不會因誤判與前車之間的距離,而落下一大段「空白車距」;然而菜鳥司機就不一樣了,他們反應速度沒有老(手)司機快,所以在看到前方車輛時,因無法正確判斷哪時候踩剎車最恰當,加上基於安全意識都會先減慢避免 A 到前車為第一反應,「空白車距」自然就出現了~而後方的車輛們會因為這位菜鳥司機(老鼠屎)的行車速度減慢而開始擠成一團,造成塞車。

相反地,當機器人在行車時,因為他們的動作程序一致,因此能穩穩地維持等速行駛。這也就是為何現今車廠想推出自動駕駛車(以下簡稱「自駕車」)的原因之一。自動駕駛真有那麼神嗎?讓我們來一一剖析它吧!

延伸閱讀:連假無法逃離宿命!為什麼會塞車呢?

自動駕駛,顧名思義就是讓車子在無人為操作的情況下,將行車速度與控制車間距離等原本需要手動操控車子行進的動作轉為自動化,以減輕駕駛人的行車負擔。

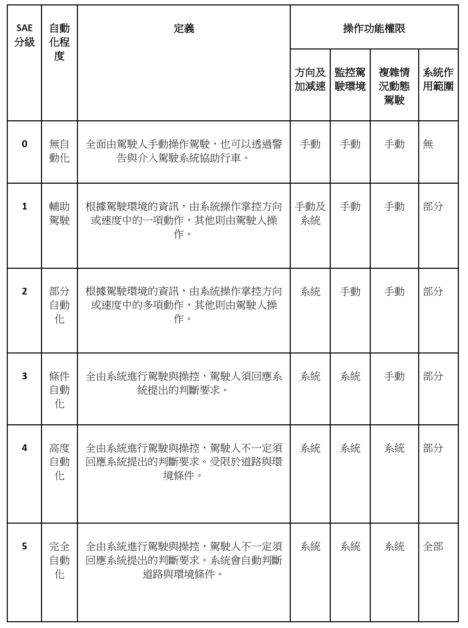

自動駕駛可是也有分級制度的!國際汽車工程師協會 (Society of Automotive Engineers, SAE) 依據汽車的自動化程度分為以下級別:

時至 2020 年末,汽車業的自動駕駛即將發展至第四級,第五級則是各企業競相達成的最終目標。

參考資料:自駕車發展趨勢與關鍵技術

自駕車本身雖能達到自動辨識路口標誌及安全煞停系統,但它就像一個好的食材,需要透過精湛的廚藝及調料的輔助才能發揮它最完美的風味,而輔助自駕車的便是「車聯網」。究竟什麼是「車聯網」?自駕車與車聯網的搭配真的能解決塞車嗎?就讓台大資工系的林忠緯教授來幫大家解惑吧!

林忠緯教授小檔案:

林忠緯教授在博班時期的研究題目即是關於 Cyber-Physical System(CPS)的研究,而 CPS 簡單來說是指能夠執行物理層面上動作的電子產品,例如車子(能在路上行走)、心律調節器(能放電控制心律)都屬於 CPS。林教授在博班的研究即是關於車子的 CPS,也曾在美國通用汽車(General Motors)實習,畢業後持續拓展自己所長,進入加州矽谷的豐田汽車(Toyota InfoTechnology Center)擔任研究員。林教授熟知自駕車與車聯網的研究,自身也致力於自駕車、車聯網與資安問題的研究,並開心表示對於未來 28 年後自駕車的展望懷抱深深的期許。

林教授認為自駕車結合車聯網勢必能解決部分層面的塞車問題,也能避免酒駕、恍神、視線死角等人為意外肇事的發生比率,但在現實生活要自駕車能實際放在道路上跑,現階段仍面臨重重難關。

當我們檢視塞車問題的視野再拉遠一點,除了自駕車及車聯網以外,教授也慷慨地分享了以下管道解決塞車問題:

雖然現階段自駕車要完全解決塞車問題仍需經時間歷練,但相信透過林忠緯教授及眾多研發單位的辛勤貢獻,大家在春節期間能夠利用自駕車與車聯網享受更加順暢、迅速的行車體驗,而不再受塞車之苦的日子指日可待!新春期間,也祝大家行車平安,旅途別塞!

「 2000 年受臺大財金系合聘之邀,我開了一門『財務統計』課程。當時股市正值科技泡沫,我很好奇為什麼會有這個現象,加上受到財金系同事和學生的耳濡目染,漸漸覺得財務的『實證研究』蠻有趣,就一直研究到現在……」

研究室位於中研院統計所的迴廊深處,何淮中像個隱士般。置身股市戰線之外,以嚴謹的統計模型、歷史的股市資料,驗證股票市場的理性與不理性。

但 2017 年獲得諾貝爾經濟學獎的 Richard H. Thaler ,曾經做一個有趣的實驗,闡述另一位諾貝爾經濟學獎得主 Herbert Simon 所提的「有限理性」(bounded rationality),證明人沒有辦法完全理性。

Richard H. Thaler 在 1997 年 5 月於《金融時報》(Financial Times)刊登一則活動廣告,希望大家來報名參加 “pick a number game” ,大獎是英國航空往返倫敦與紐約/芝加哥的機票。玩法很簡單,只要玩家在 1~100 中選一個整數寫在信中、寄回主辦單位,截止後將所有收到的數字蒐集起來「取平均數、再乘以三分之二 」 ,最靠近這個數字的玩家,就是贏家。

假設 5 個人參加比賽,他們選擇 10,20, 30, 40 和 50 ,在此情況下,平均數是 30,而 30 的三分之二是 20 ,因此最初選擇 20 的玩家是勝利者。

這遊戲的隱含意義是──人們的預期心理、有限的理性。

若按照「市場是理性」假說,所有玩家應該會預期別人選擇什麼數字、並取平均數再乘以三分之二;然後又預期別人應該也會這麼做,又再取平均數再乘以三分之二……;經過這樣的循環,直到最後每個人都會選擇 1。

但無論是 1997 年《金融時報》這次、或我在各場合玩這個遊戲,都發現理性是有限的,人們一開始只會猜測別人的答案兩到三次循環,然後就選一個直覺大概沒錯的數字。

不同市場群體,會理性到什麼程度,我們可能不知道,就需要蒐集資料、根據統計來估計,這就是統計的重要性。

但其實台股的「菜籃族」常常搞不清楚股票上漲或下跌的原因,聽聞小道消息就跟風「追高殺低」,導致損失慘重。其實這背後有「動能效應」可以解釋,1993 年由 Jegadeesh and Titman 提出,指的是股票報酬率有持續性的現象,強者恆強、弱者恆弱。

投資人會有預期心理,預期心理又受到小道消息影響。由於小道消息的資訊傳遞像漣漪一層層擴散出去,因此股價在一定期間內呈現漲繼續漲、跌繼續跌,好像有個「動能」在持續推高或拉低股價。

動能投資策略,就是運用這種現象來規劃投資組合:買進贏家股票(漲繼續漲)、搭配賣出輸家股票(跌繼續跌)。

然而,2000 年之後的股票市場,這種動能效應似乎消失了。有些人認為是因為大家都知道這種賺錢方法,有些人認為是時機不對。但我們認為動能效應應該還存在,只是被一些「雜訊」給掩蓋,所以就撈出 1930 年 1 月到 2010 年 12 月的美國股市資料,和學生一起設計我們的「WL-LH 動能投資策略」做實證研究。

其實這與過往的動能投資策略差不多,差別在於,我們透過美股歷史資料分析,於投資策略中刪掉一些「雜訊」:「漲幅被高估」的贏家股票,也就是動能燃料已經燒完、會開始下跌;還有「跌幅被高估」的輸家股票,因為超跌、未來會再漲回來。這兩者分別代表投資人對於市場中好與壞的資訊,呈「過度反應」的現象。

困難的是,如何判定漲幅或跌幅是否被高估?我們從「資訊擴散」的角度出發,提出一個資產價格模型。然後藉由價格模型,設計一個價格風險指標,有效地篩選掉超漲或超跌的股票,從而驗證了市場的預期心理和動能效應,也同時說明市場的不效率性。

其中相關的統計模型算式,通常大家看了就頭痛,這裡先不贅述,有興趣的朋友請直接看看我們的論文。

從 1930 年 1 月的資料開始,我們先看過去一年的累計複利報酬、排序,買表現好的股票、賣表現壞的股票,一個月後檢視這樣的投資組合的報酬率。因為資料時序已經移動一個月,所以我們再從新的一個月回頭看過去一年的累積複利報酬、排序,再進行一次剛剛說的投資。

最後把累計複利報酬取平均值,例如下圖的 2000 – 2010 年資料所示。其中可看到, 2000 年以後的動能效應,原本大家認為已經消失了,但經由我們的 WL-LH 投資策略挖掘,失而復得,動能投資策略的獲利空間仍然存在。

我們對這個詮釋抱持懷疑,所以我們試著將 WL-LH 投資策略,套用至不同國家股市的歷史資料(1990-2014 年)驗證,發現只要去掉「雜訊」──上漲動能燃料已燒完的股票、以及超跌的股票,無論是美國、歐洲、日本、印度等 21 個國家,都能看見動能效應,比率接近九成。

換言之,因為人們投資行為的偏誤,例如貪婪追高股價、恐懼在低點持股,而導致市場的不效率性,是超越地域、族群而存在的共通現象。

但是台股比較特別,在 WL-LH 策略下,仍看不到動能效應。

在台股歷史資料(1990-2014 年)中,刪掉漲幅「被高估」的贏家股票、跌幅「被高估」的輸家股票後,並未找到動能效應。我們的推斷認為,台股投資人普遍容易過度預期,以及股票交易周轉率較高,可能是主要的原因。兩者都影響了模型預測「資訊擴散程度」的準確性。

由機率跨入統計,是很自然的。兩者都是處理「不確定性」的方法體系,密不可分。

我的研究,包括前面提到市場效率性的課題,「機率」與「統計」兼而有之。透過資料分析,可以證實股市有一定程度的不效率性,也有獲利的空間。但投資仍有風險,不會因為這些研究發現就產生過度自信,所以我老婆和我還是存定存、買共同基金。再說,她的錢我也管不了呀。

本著作由研之有物製作,原文為《行情總是在希望中毀滅? 專訪何淮中》以創用CC 姓名標示–非商業性–禁止改作 4.0 國際 授權條款釋出。

本文轉載自中央研究院研之有物,泛科學為宣傳推廣執行單位