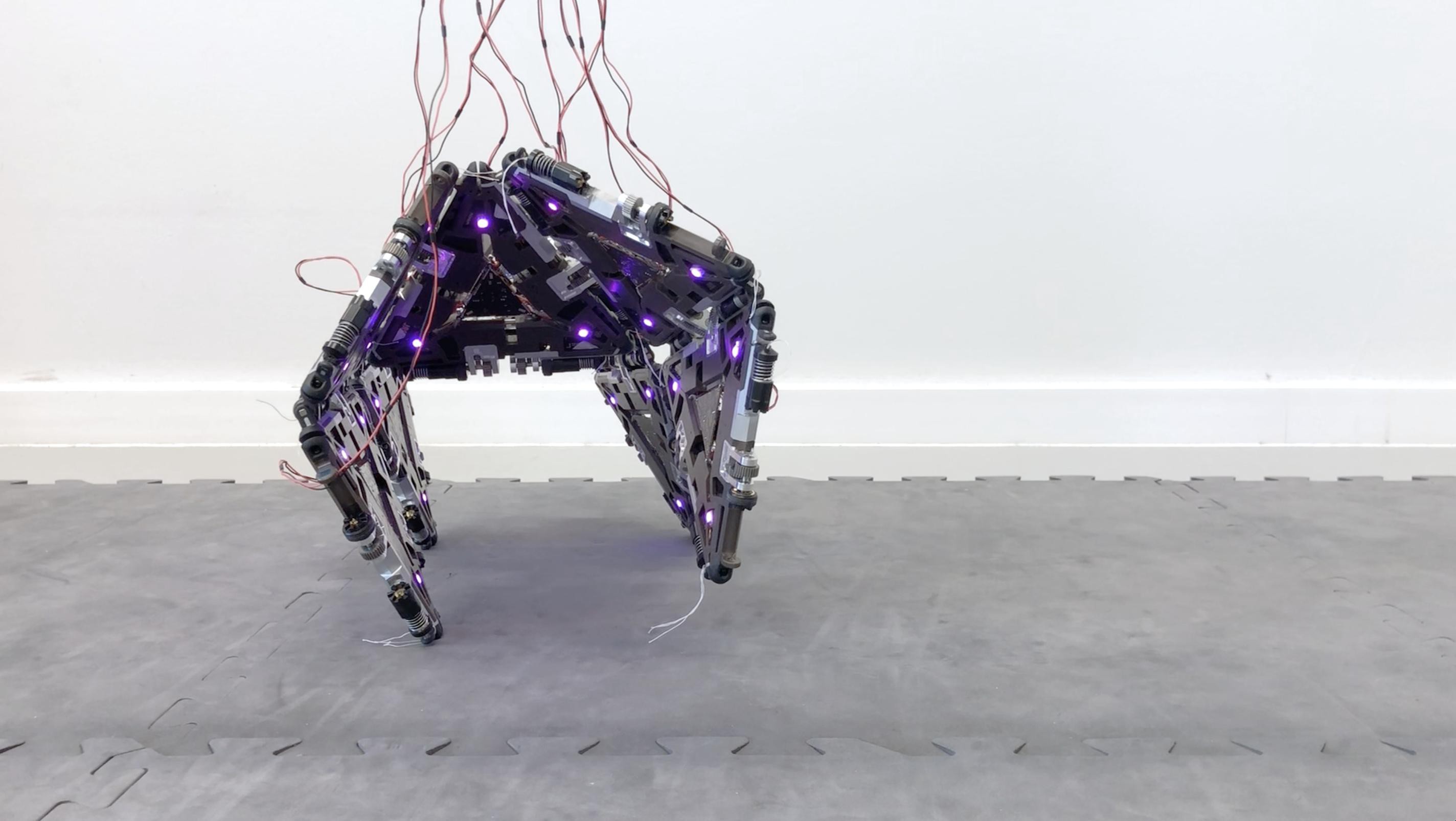

隨著機器人的發展越來越快速,能否或是否賦予機器人道德地位(moral status),已成倫理學和技術哲學的經常爭論之一。

在討論怎樣的情況下可以賦予機器人(或其他對象)道德地位——不應虐待和殺害它/牠——時,長期的主流論點是「屬性論」,即認為其具有某些特定的特性因此該賦予其相應的地位;近五年,伴隨著針對屬性論的反省與批判,聚焦在討論對象與人類的關係的「關係論」有逐漸成為主流觀點的趨勢,但我對此頗有保留。即便不贊同屬性論,但我也很難完全同意關係論。在這篇文章中,我想先簡述屬性論的內容、關係論對屬性論的批評,接著說明關係論的觀點為何,然後檢視關係論是否能成功避開它對屬性論的種種批評,最後再提出我對使用與看待關係論的建議。

子非於安知魚之樂:屬性論的侷限

屬性論,簡單來說就是:如果我們賦予 X 道德地位是因為 X 具有 Y 特性,那麼同樣具有 Y 特性的 Z,也應該獲得道德地位。

例如,我們可以用這樣的說法來支持有善對待動物:「因為動物跟人類一樣擁有感受痛苦的能力,所以動物也具有道德地位(因此不應該虐待或殺害動物)」(註 1)。同樣地,如果機器人具有跟人類一樣的某種特性(比如說自我意識),那麼就應該賦予機器人一定的道德地位。

關係論者對這樣的論證頗有批評。首先,屬性論需要有參照點,而這個參照點往往——幾乎無可避免——是人類本身。 因此,我們經常看到這種說法:

「因為 Z 像人類一樣有 Y,所以 Z 也有道德地位。」

關係論者認為,這無非是人類中心主義。再者,要確認 Z 是否具有 Y,其實不如想像中容易(認識論問題)。「子非魚,安知魚之樂?」的反駁也適用於此:人類不是動物 A,怎麼知道動物 A 真的感受到痛苦?我們可能會說「動物 A 的叫聲聽起來很痛苦啊」,但實際上叫聲本身沒有痛苦或不痛苦可言,那只是人類的解讀。

可能會有人說,那就透過量測數據來確定吧:比如說人類疼痛時血壓升高、瞳孔放大,那麼如果科學家在動物 A 身上也量測到相同(或等比例)數據,就可以證明動物 A 也有受苦能力。這就關聯到關係論者的第三個批評:這種做法等於把決定權和話語權交給科學家,而倫理學家和哲學家插不上話。

第四個批評與第三個有關,關係論者認為,道德是個非常複雜的議題,哪些特性算是「道德屬性」,而 Z 是否具有該道德屬性,這兩者都會隨著文化和時間改變,這正是為何以前人類不認為奴隸和婦女有道德地位可言,但如今已經沒有人懷疑這點。

總的來說,關係論者認為,屬性論的侷限在於,它只關注某物 Z「向內」的狀況,卻沒有考慮它「向外」的情境。相較於觀察外部,觀察內部顯然更為困難,可到達性和不確定性都很高。姑且不論關係論的批評是否成功(坦白說我認為不太成功),但屬性論在近年確實遭遇不少困難,這也使得亟欲突破的學者紛紛找尋出路、轉向關係論。

關係論:與人相互關愛的那一位?

關係論認為,與其關心 Z 本身,不如聚焦在 Z 與人類的「關係」。簡單來說,如果 Z 與我們的關係密切,那麼 Z 就應該被賦予道德地位。比如說,狗與人類在歷史過程中共同演化、相互依存,把狗與人類切割開來獨立看待並無道理,既然「有道德(地位)」的人類社會一直有狗的存在,那麼沒有理由把狗排除在道德地位的清單之外(註 2)。

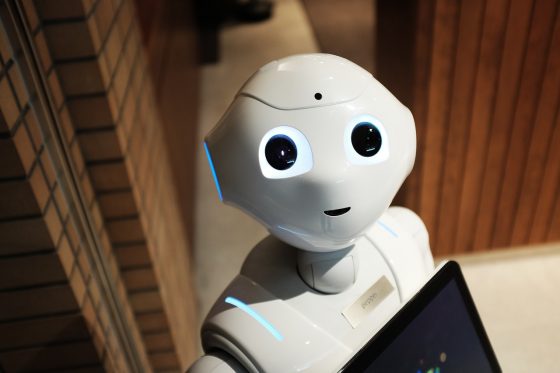

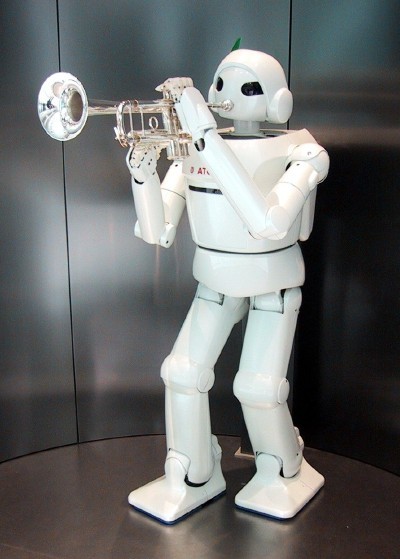

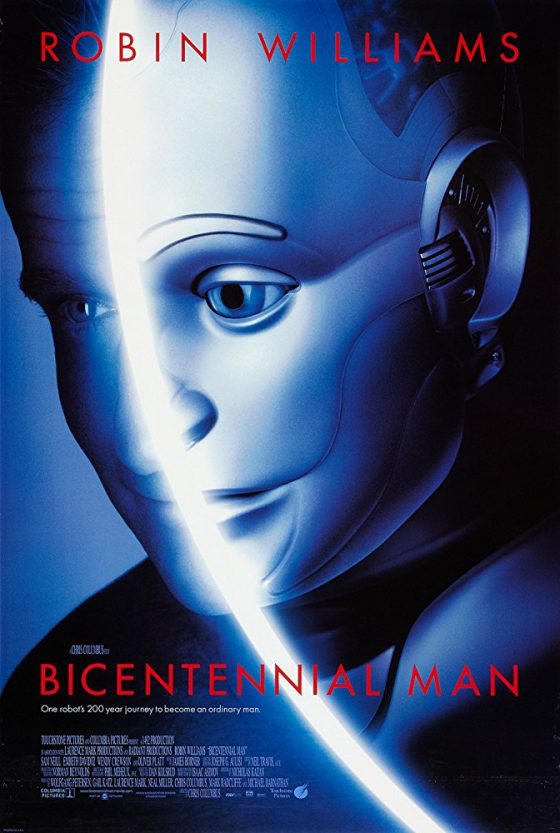

或者,如果機器人能夠與人類大量互動,並產生相互依存的情感關係,那麼就應該賦予機器人道德地位(註 3)。就關係論而言,殘害你心愛的狗或者摧毀你會跟它吐苦水的機器傭人,堪比殺死你的親戚或朋友——因為牠和它與你的關係不亞與他或她(與你的關係)。

Z 與人類關係是否密切,關係論者提供了幾個判斷方式。例如,看看你是否會幫 Z 取暱稱。當你幫小狗取名「阿福」或「黑寶」,通常表示牠跟你關係密切;同樣的,有些人會幫心愛的商品(汽車、娃娃…等)取名字,這也表示該物在他心裡有一定份量。

或者,觀察 Z 的「位置」是否在特定生活圈中。如果一隻狗經常出現在你的身邊,或者某台車經常停在你家車庫,這通常表示那隻狗或那台車與你關係密切——可能你擁有牠/它,或你經常與牠/它互動。當然,關係論者不認為光憑這些條件就能確定 Z 具有道德地位,但他們強調這些條件具有指標性意義。

到最後還是「以人為中心」啊!關係論的問題

關係論本身能夠避開它對屬性論的批評嗎?在我看來頗為困難。

首先,關係論批評屬性論的參照點是人類,但關係論本身談論的「關係」究竟是什麼?是 Z 與「人類」的關係。如果說屬性論是以人類為參照點,那麼關係論就是人類為連接點,似乎也難以避免被批評為人類中心主義。

再者,關係論也會遇到認識論問題:我們如何確定行為上互動密切的 Z 與人類,兩者在情感上也非常密切,以至於人類願意賦予 Z 道德地位?養豬戶可能與自家豬群天天互動(說不定還會取名字),但他們會說這些豬殺不得嗎?行為上的密切不代表情感上的密切。甚至,即使某人用嘴巴說出他很愛他的貓,看起來感情密切,也很難保證他說的是真話(例如,可能會有些虐貓者表面看起來也很愛貓)。

第三點,如果要用科學數據來確定關係的真偽,關係論同樣會落入「獨厚科學家」的批評之中,並未優於屬性論。至於最後一點,關係論確實比屬性論有更大的彈性,因為關係論不尋找某些確定的性質。不過,這個看似優於屬性論的特點,反而是關係論弱於屬性論的原因。

關係論認為「何種性質是道德屬性」並不固定,而是關係發展的結果,這意味著,在關係確定或穩定下來之前,我們無法討論「該或不該」賦予 Z 道德地位。換句話說,不同於屬性論,關係論無法做出道德指引,只能事後追認和解釋 Z 之所以獲得道德地位的原因。也就是說,如今我們多半認為應當賦予貓狗道德地位(不應隨虐待或殺害貓狗),但對於數十萬年前——那時貓狗還沒被馴化——我們的祖先來說,那種足以讓我們考慮「是否應該賦予貓狗道德地位」的關係根本還不存在。

關係論者並非沒有意識到關係論的這個弱點,因此經常宣稱:關係論只是說明 Z 獲得道德地位的可能條件(與人類關係密切),目的在於讓人們換個角度來思考道德地位問題,而不是要做出具體指引和建議(註 4)。這種宣稱,可以避開批評,但略嫌取巧。如果不打算賦予 Z 道德地位,我們又何必開始討論 Z 的道德地位問題?

從關係論的角度來看,如果不是 Z 已經跟人類關係越來越密切,我們又何必思考是否賦予 Z 道德地位?換句話說,「應該賦予 Z 道德地位」這樣的起心動念,多半內含於「提出關係論」的行動之中。

如何使用關係論

關係論並非毫無用處,它至少是個離開屬性論的另類出路,但我建議,最好把關係論看成類似演化論的觀念。演化論用「比較適應環境」來解釋「為什麼(生物)N 長成現在這個樣子」,而關係論則用「與人類關係密切」來解釋「為什麼 Z 足以或能夠獲得道德地位」。這是一種「指向過去」的用法,著重解釋。

演化論不應用於「指引未來」——我們不能也不應預先判斷 N 中的 N1 或 N2 何者比較適合環境,然後除去另外一群。這種運用演化論的方法——那些以社會達爾文主義為由的優生學和種族主義——已經造成歷史上許多悲劇。同樣的,關係論也不能預先判斷 Z 是否具有道德地位,若「是」就大量發展 Z 並要求人類與之展開密切關係,若「否」則直接否定 Z 並將它從人類社會移走。

就提供道德指引而言,關係論並未比屬性論更有用處。關係論既不能也不應用於提供道德指引。不過,關係論確實提供一個重新思考道德地位的視角:道德地位的來源於是經由互動而產生的相互關係,而不是天生就有的。這提醒我們關注任何 Z 與人類互動的過程和歷史,而不是把某人或某物具有的道德地位視為理所當然。

簡言之,如果關係論能夠提供任何建議,那就是:保持開放,讓人類與動物、人類與機器人的關係繼續發展吧!

註釋:

- Singer, P. (2009). Animal liberation: The Definitive Classic of the Animal Movement (Reissue edition). New York: Harper Perennial Modern Classics.

- Haraway, D. (2003). The Companion Species Manifesto: Dogs, People, and Significant Otherness. (M. Begelke, Ed.). Chicago: Prickly Paradigm Press.

- Coeckelbergh, M. (2010). Robot Rights? Towards a Social-Relational Justification of Moral Consideration. Ethics and Information Technology, 12(3), 209–221.

- Coeckelbergh, M., & Gunkel, D. J. (2014). Facing Animals: A Relational, Other-Oriented Approach to Moral Standing. Journal of Agricultural and Environmental Ethics, 27(5), 715–733.