- 作者/高涌泉

人有人權,機器人是否應該也有某種類似於人權的權力(姑且稱之為「機器人權」)?目前這個問題還沒有被大眾認可的標準答案,因為我們還不知道機器人是否值得擁有機器人權。以當下(2021)最先進的機器人來說,我想多數人對於將它「關機」,不會有絲毫猶豫,就像我們可以毫不在意地任意關掉(或開啟)最先進的蘋果電腦。也就是說,當前最先進的機器人還沒有先進到需要我們去擔心關機是否影響它的福祉(生命)。但是未來呢?當,譬如說,一萬年之後 ( 或許不用那麼久,說不定一千年之後即可?)的機器人,已具備人性(我稍後會討論出現這種狀況的機率),那時人類應該允許機器人擁有機器人權嗎?

科幻電影中的機器人

對於這個假設性問題,好萊塢已經給了答案——你所能想像的狀況大約已經出現於某部科幻電影裡。有一類情境相當常見,讓我舉幾部很好看的片子為例來說明:

- Ex Machina(人造意識,也譯為機械姬;據說拉丁文片名本意是「來自機器」)。片中的女機器人在主人的設計下,已經具有足以通過「圖林測試」(Turing Test)的智能,但是她還進一步發展出主人所不知的自主意識,最終為了自由而殺死把機器人當作娛樂工具的主人。

- Blade Runner(銀翼殺手)。此片的機器人是仿生人,在外貌、語言以及行動上,與人類沒有區別,和 Ex Machina 中的機器人相比,好似更加先進,然而其機器人本質還是可以被一項對於情緒反應的測試揭發(有如測謊器的功能),片中機器人當然也被安排會為了避免「被退休」而殺人。

- I, Robot(機械公敵)。片中機器人在外貌上,與人類有明顯區分,它們被製造來服務人類,有遠超越人類的體能,因此必須遵循艾西莫夫「機器人三定律」(第一定律:機器人不得傷害人類,或坐視人類受到傷害;第二定律:機器人必須服從人類命令,除非命令抵觸第一定律;第三定律:機器人在不違背前兩定律的情況下,必須保護自己),此片也一樣安排讓機器人產生某種程度的自主意識(主角機器人甚至會做夢),以及與人類的衝突。

以上三部科幻片的共同點是人類製造出的機器人終究會產生某種具自由意志的心智,並且會捍衛自己生存的權利、抗拒人類的宰制。這種「覺醒、反抗、勝利」三部曲的故事也廣為其他科幻電影所採用。(有一部叫好叫座、由 HBO 推出的科幻電視影集 Westworld(西方極樂園)也是大致循這樣的套路。)事實上,這樣的套路也出現在非科幻的一般劇情片中,大約是這種勵志招式符合某種人類的心理需求,所以很受歡迎。總之我們從機器人科幻片學到了兩件事:一是我們與機器人的關係取決於機器人能否產生自我意識(心靈),而且大家願意相信機器人應該終究會具有這樣的能力;第二是對於我們應該賦予機器人多少「機器人權」的問題,無論我們如何操心,恐怕不是重要的事,因為就如「人權是爭取來的,不是靠施捨的」,「機器人權」的內涵還是由機器人決定。不過這兩點若真要仔細推敲,就會發現可以質疑的地方非常多。

機器人適用心物二元論還是原子論?

首先,到底什麼是機器人?對此我一直沒有下個定義,因為不需要:大家都很清楚機器人儘管在外型與行為上,有很多種類,但一定都是人造的。所以機器人就是人造人(或人工人),是人類用材料製造出來的。所謂的材料就是物質,物質拆解到最後,就是各種原子罷了。所以機器人都是原子組裝出來的。但是人類不也是由原子組成的嗎?為什麼人不是機器人?或者,人其實也是一種是機器人?也就是說人也不過是一群原子依據某種明確的指令(程式、算則)在運行罷了!然而自古以來,不斷有哲學家懷疑這樣的看法,因為大家想不透在這樣的假設下,自由意志(俗稱靈魂)如何能夠出現?如果不行,也就是說靈魂這東西和物質屬於兩個範疇(即所謂的二元論),那麼人當然就不是機器人了:人有靈魂,機器人沒有。

但是自古以來也有不少人不相信二元論,例如古希臘的原子論者就不相信有獨立的靈魂這回事,以法國哲學家柏格森(Henri Bergson)的話說,原子論者相信的是「身體、靈魂、所有的物體以及世界,都是由原子所構成的。自然現象和思維都只是原子的運動而已。一切的事物與現象都是由原子、原子之間的真空(void)、以及原子的運動所組成的。除此之外,就沒有其他東西了。」如果原子論終究是對的,那麼人便只是一類較高明的機器人罷了!

那麼到底二元論與原子論兩者間哪一個比較有道理?(當然了,聰明的哲學家還發明出其他更繁複細膩,或者說更怪異有趣的理論,例如原子本身就是有意識之物體的說法等等,感興趣的人可以自行探究。)自近代科學出現以來,由於物理、化學與生命科學以及電腦科學的快速進展,眾多科學家自然地認為原子論的觀(自然現象和思維都只是原子的運動而已)是一件合理的假設,理解意識如何出現在腦子裡於是成為眾多研究的目標。

認知思考的想像實驗

美國哲學家瑟爾(John Searle)在 1980 年提出一項想像實驗(類似的想法其他人也有),試圖證明意識絕不是物質加上(電腦)程式就能產生的,具體說,即電腦不可能具有思考能力。他這個想像實驗一般稱為「中文房間論證」(Chinese room argument),讓我用一個不同於瑟爾原始版本、但我想仍不失其意的簡化版來說明這個論證:設想在某房間裡有位美國哲學家,他不懂中文與日文,但是能夠依據指令行事,房間裡有個資料庫,裡面有一份中日文字對照表(對哲學家來說,這裡的中日文字都只是奇怪的符號而已)及一本以英文寫的中日文語法規則簿(即中日文字對照表內符號之間應遵循的關係),我們將一篇中文文章送進房裡,這位先生就依據房間裡的資料庫,將這篇文章「翻譯」成日文,然後送出房間。房間外的人會以為這篇文章是房間內有位懂中文與日文的人所做的翻譯,但是瑟爾說房內的哲學家根本不知道他所經手的文章在講些什麼。

以行話說,瑟爾想示範的是掌握了「語法」(syntax)不意味就了解「語意」(semantics),而不了解語意就談不上認知與思考。總之,瑟爾的重點是知道依據明確的規律來操弄符號(這是所謂「人工智慧(智能)」(AI)的功能)儘管有翻譯的本事,但仍不具認知、理解與思考的能力,也就是他不相信電腦(AI)能夠導致意識與心靈。瑟爾的講法引發大量評論,有人主張自由意識根本是個幻覺(當然另有人說這麼想的人錯得離譜),也有人主張人腦與電腦有根本差異(但是究竟差異為何,則意見紛雜)等等。

在我的簡化版本中,瑟爾的想像實驗假設了機器翻譯是行得通的(但是即便如此,機器還是沒有意識可言),不過長久以來,機器翻譯其實一直沒有太大的進展。然而近年來由於大數據與深度學習方法的出現,機器翻譯的水準已經頗為可觀,儘管還算不上完美,但是已經不像更早些時,譯文漏洞百出,明顯就不是人為的。同樣地,深度學習也讓電腦下棋(無論是西洋棋或是圍棋)的功力,遠遠超越人類棋手。在翻譯與下棋之外,電腦還有很多令人刮目相看的新本事(傳統的本事當然是其快速計算的能力),所以就算電腦還談不上有真正的意識(無論這是什麼意思)可言,不少人(包括我)已經感到震撼。

對於意識等抽象概念的探討,如果沒有具體的例子作為對象,容易流於空泛,莫衷一是。目前在人類之外,什麼東西可能擁有某種程度的意識?動物是個明顯的答案,無怪乎科學家與哲學家對於動物的心智很感興趣。不過動物心智也不容易捉模,相關意見也一樣紛雜。據說,主張心物二元論的笛卡爾就認為由於動物沒有語言能力,因此談不上具有心智,不過我想很多養過寵物的人恐不會接受這個見解。

動物的心智與生存權

我自己雖不養寵物,但全然認同(起碼有些)動物是具有心智的。主因是我在過去五、六年間,迷上了在 YouTube上觀賞對於白頭鷹(bald eagle)的巢 24 小時全天候(晚上有紅外光夜視)的實況轉播。簡單講,整個情況就像電影 Truman Show(楚門的世界)的白頭鷹版——除了白頭鷹的真實生活比虛假的楚門世界要有趣太多了。白頭鷹是美國國鳥,曾一度列入瀕臨滅絕物種(endangered species)名單,後來在種種保護措施(包括禁止殺蟲劑 DDT)下,族群數量才逐漸回升。白頭鷹是美麗的大型鳥,位於食物鏈頂端,有王者氣質,令人著迷。現在網路上可以找到很多位於世界各地的這種稱為「白頭鷹巢實況監視」(live bald eagle nest cam)的 YouTube 頻道,我最早看的是一個位於美國首都華盛頓特區的巢:多年來,有一對白頭鷹固定在那裡築巢、育(鷹)嬰,人類鷹迷們分別暱稱公、母鷹為「總統先生」與「第一夫人」;它們每年秋季回到這裡,修整離地數十公尺的巢、交配、產卵、孵卵、撫育幼鷹,直到幼鷹於初夏可以自行飛翔離巢。

對於我這樣剛入門的觀鳥人,白頭鷹的一切生活習性都很有意思。例如,幼鷹一但接連破殼而出,殘酷的「手足競爭」(sibling rivalry)立即登場,父母不會介入這種(從觀眾留言可知,令不少人不忍心看的)天生的競爭,弟妹在受到兄姊的壓制之後,很快學到要避開對方的攻擊,並且如何在適當時機,迅速從父母口中搶到食物。又例如,公鷹規律地獵捕魚、松鼠等動物回巢,轉交母鷹餵食幼鷹。還有令我特別訝異的——父母會在下雨(雪)或大太陽時張開翅膀護著幼鷹。

觀鷹久了,我發現自己能夠預測老鷹的企圖,或者說可以領會老鷹在「想」些什麼、在動些什麼「心思」。老鷹儘管沒有語言,但是能夠發聲「呼喚」、「警告」、「恐嚇」其他老鷹或其他生物。我一點也不懷疑白頭鷹具有某種程度的心智。(知名哲學家奈格爾(Thomas Nagel)在 1974 年發表了一篇文章「身為蝙蝠會有什麼樣的感受?」(What is it like to be a bat?),他此文的主張就是,不是蝙蝠的我們永遠不會知道蝙蝠的主觀感受是什麼。我自以為多少了解白頭鷹的心思,當然是不認同奈格爾的主張可以推廣至白頭鷹。)為什麼白頭鷹能夠具有心智,而機器人沒有?這就是當代心智研究的基本問題。我猜測關鍵在於演化與成長歷史:白頭鷹是經過長期自然演化而產生的物種,從出生至獨立成熟也有個成長過程,而機器人卻不是如此。

動物應該擁有生存權,尤其是那些我們覺得具有某種心智能力的動物,這是很多人認可的事(在很多社會這件事其實已經成為法律)。白頭鷹的生存受到保護,數目也逐年增加,愛鷹人士都很高興。但是如果白頭鷹的數目因為保護而過度增加以至於影響了人類的利益呢?是不是白頭鷹的生存權也應受到限制呢?(對於某些動物,這種情況不是已經出現了嗎?)總之,動物權的範圍操之於人類。

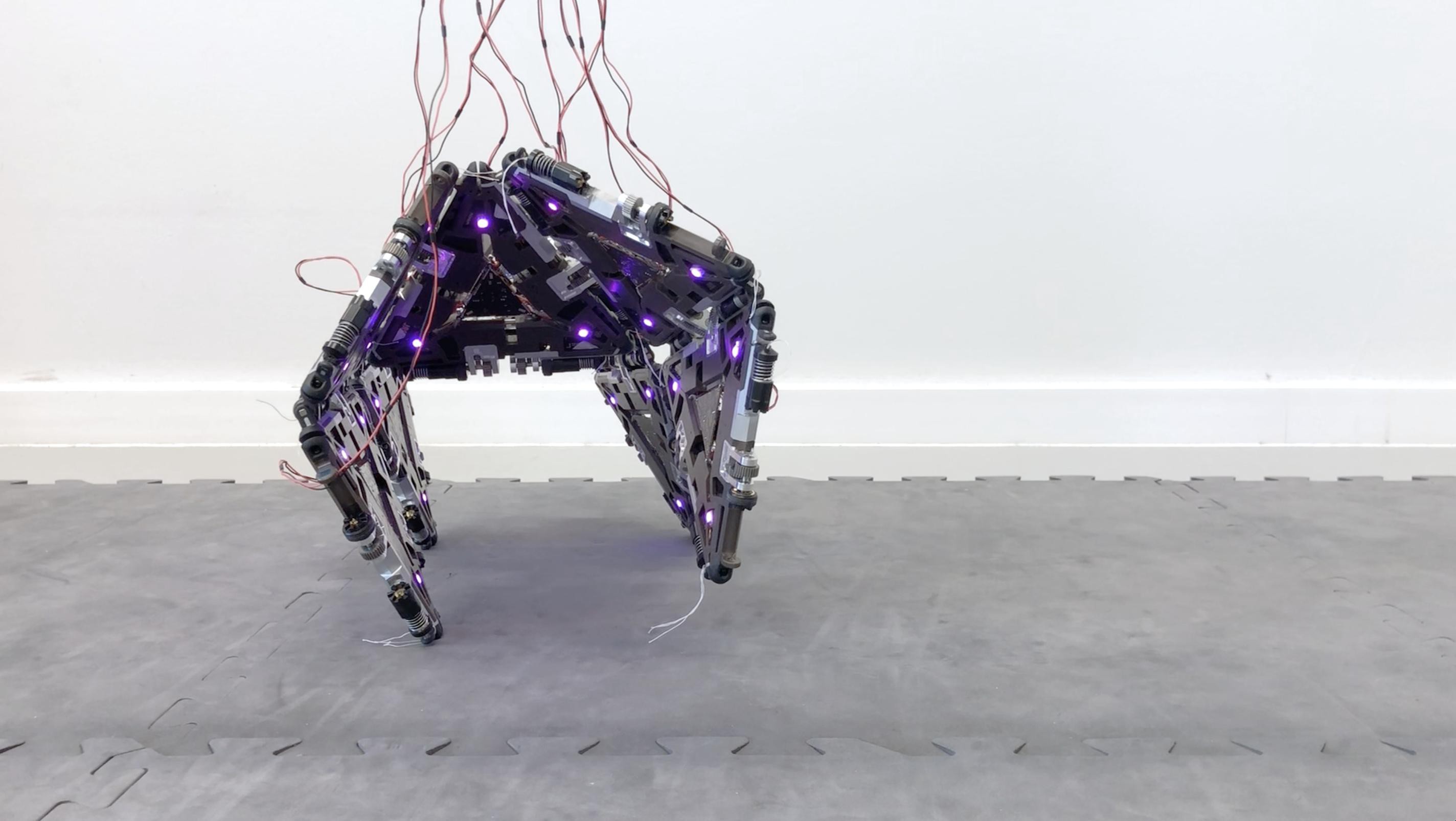

機器人目前的處境還遠在動物之下,我看不出機器人如何能夠因產生心智而改變這種狀況。即便機器人因本事提高,讓我們將它們如同白頭鷹看待,它們生存權的範圍大小,仍是取決於人類,除非它們的聰明才智超越包括人類在內的一切動物。

人類目前的科技水準還處於初級階段,或許在很久很久以後,人類可以製造出和蚊子一樣靈活的「機械蚊」,那時才開始來操心所謂機械人權的問題還不晚。