- 文/賴昭正 前清大化學系教授、系主任、所長;合創科學月刊

有心栽花花不開,無心插柳柳成蔭

-明代《增廣賢文》

在十六世紀以前,宇宙的起源、歷史、與結構一直被認為是屬於宗教與哲學的範圍,因此最初的許多宇宙論都是以人為中心、基於神話和傳說,並認為宇宙是永恆不變的。

為什麼是永恆不變的?一個正在改變的宇宙,便應該有面臨終結的命運,這似乎不符合超越人類之創世者存在的宗教信仰。

因此 17 世紀末至 19 世紀初之歐洲啟蒙時代(也稱為理性時代)雖然企圖擺脫對宗教盲目的信仰,追求通過理性和感官證據去獲得知識,但似乎並未改變科學家深信自盤古開天闢地以來,宇宙是靜態、永恆不變的根深蒂固想法。

牛頓在 1687 年提出萬有引力來闡述宇宙星球的運行,但只有一個吸引力的宇宙是不可能保持靜態的,因此牛頓理論需要一個持續的奇蹟來保持宇宙的靜態,防止宇宙的崩潰(即防止宇宙因為太陽和恆星被拉到一起而崩潰)[1]。

愛因斯坦 1915 年發表包括重力在內的廣義相對論後,當然也思考著宇宙結構的問題。但他 1917 年所提出來的宇宙模型也像其它只有吸引力的模型一樣,謂宇宙是不可能保持靜態,只能膨脹或收縮!所以愛因斯坦就將重力方程式做了「少許修改」,讓宇宙能保持靜態。

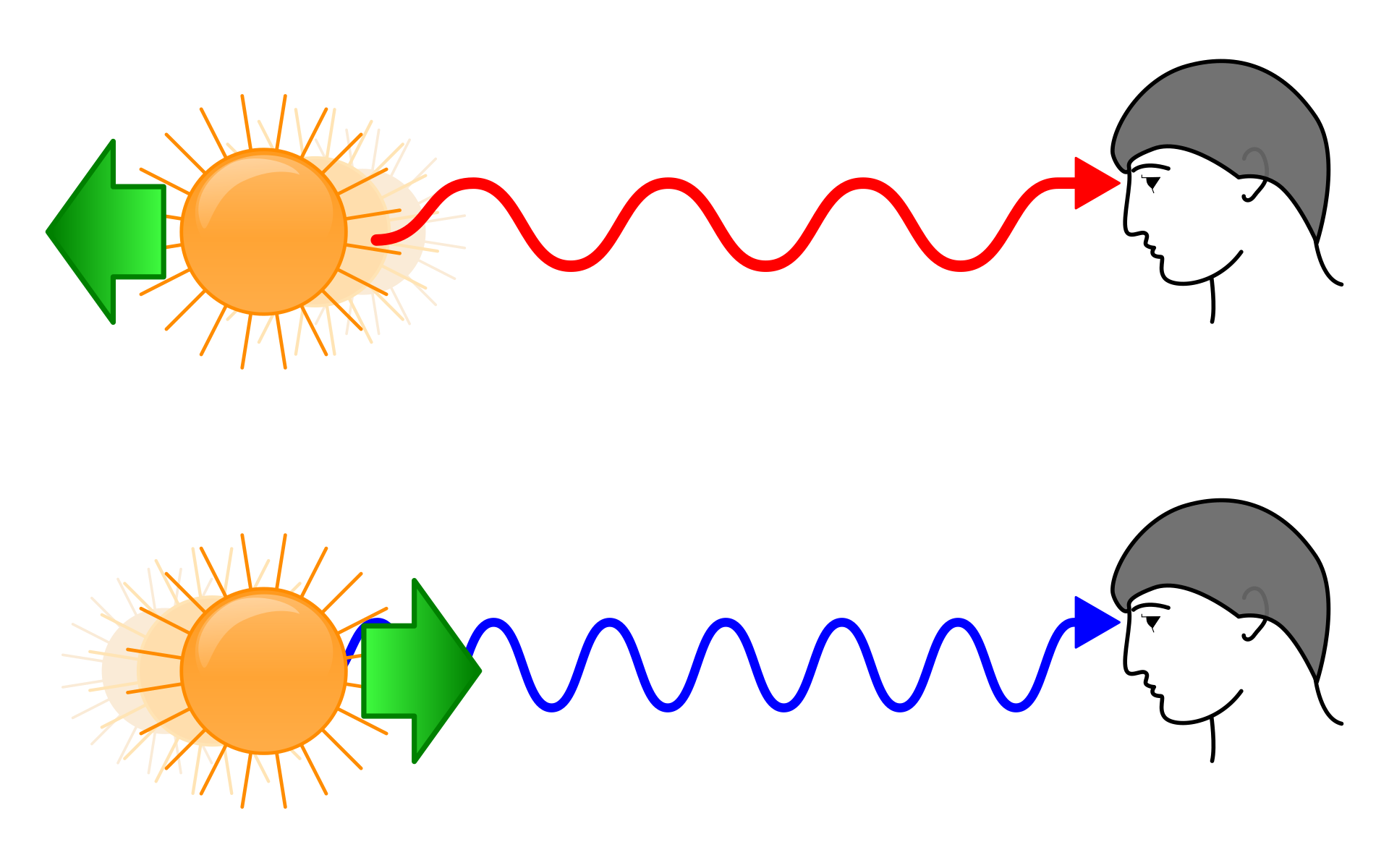

1929 年,美國天文學家哈柏(Edwin Hubble)分析了一些從遙遠星群傳來之光譜的測量結果,發現其頻率很有系統地往較低之紅色位移(red shift),其位移值隨星群離我們之距離的增加而加大。顯然地,遙遠星群是依一定的規則在遠離我們:距離我們越遠,後退速率越快,稱為「哈柏–勒梅特定律」(Hubble-Lemaître law)]。

- 紅移

多普勒效應(Doppler effect)或多普勒頻移(Doppler shift)是因聲音波源及觀察者的相對移動而造成波頻率變化的現象。當波源及觀察者互相接近時,觀察者會測到波源的頻率比原來的高;反之,當他們遠離時,觀察者會測到波源的頻率例比原來的低。頻率的改變與相對速度成正比。因為光也是一種振動,故也有類似的現象。就可見光而言,紅光頻率較低,藍光頻率較高,因此光頻因兩物體互相遠離而變低時,我們稱為「紅移」(redshift);反之,我們稱為「藍移」(blueshift)。

這無可避免的結論是:宇宙正處於正在膨脹的狀態!此一完全出乎意外的發現,改變了宇宙論這一研究的整個面貌!可是哈柏後來辯稱,不確定性的有限數據似乎支持靜止宇宙的概念,但他並沒有明確排除宇宙膨脹的可能性,因此他從未獲得諾貝爾獎——開玩笑的,他真正未得諾貝爾獎的原因見後。

有什麼證據可以說服像牛頓、愛因斯坦、哈柏這樣的大科學家相信宇宙是在膨脹呢?

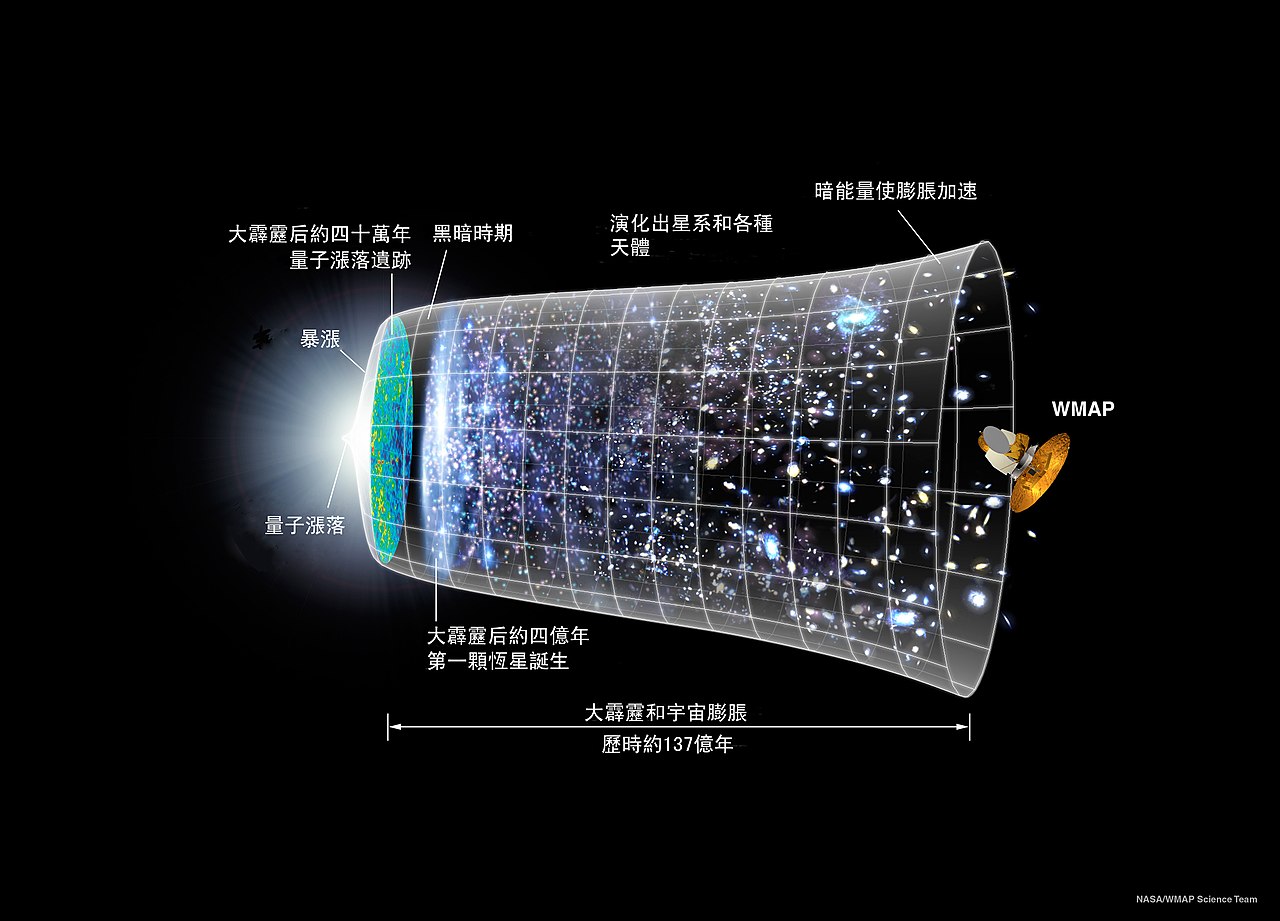

標準大霹靂宇宙論

一個正在膨脹的宇宙是一個動態改變的宇宙,因此應該具有生命的歷史──甚至可能有出生與死亡。依現在廣為大部份科學家所接受的「標準大霹靂宇宙論」(standard cosmological Big Bang model),現在的宇宙年齡大約是 140 億年。

我們雖然對 140 億年前的宇宙結構細節非常不清楚,但大部份的科學家均認為宇宙是由「一個時空特異點」突然大爆炸而出現的──雖然物理學家尚不知道可用什麼理論來解釋該特異點。

剛爆炸時的宇宙處於一個高度均勻、非常高溫、及高輻射能密度的狀態;大約 10-12 秒後,溫度下降到太陽核心溫度的一億倍時,我們現在所知道的自然力就出現了,此時被稱為夸克的基本粒子在能量海洋中自由遊蕩。大約 10–6 秒時,自由夸克就被限制在中子和質子中。大爆炸一秒鐘後,宇宙充滿了中子、質子、電子、反電子、光子、和中微子。之後,隨著宇宙繼續膨脹,溫度也繼續下降,質子和中子開始結合形成原子核,然後又與電子結合形成現今宇宙中主要成分的氦和氘原子。這些中性原子透過重力開始合併成氣體雲,慢慢演變成恆星。當宇宙膨脹到現在大小的五分之一時,恆星已經形成了可以識別的年輕星系群體。

在電子、質子、和中子結合形成不帶電之原子前,因輻射能直接與帶電體作用,故宇宙是「不透明」的。當宇宙膨脹持續了 38 萬年、比現在小 1000 倍、溫度只有 ~3000K 時,中性原子開始大量出現;宇宙學家稱此一時期為「複合時期(recombination epoch)」。因為中性原子不能散射輻射,故輻射能在其間自由遊蕩,宇宙於是就變「透明」了,宇宙學家稱此一事件為「光子去耦(photon decoupling)」。

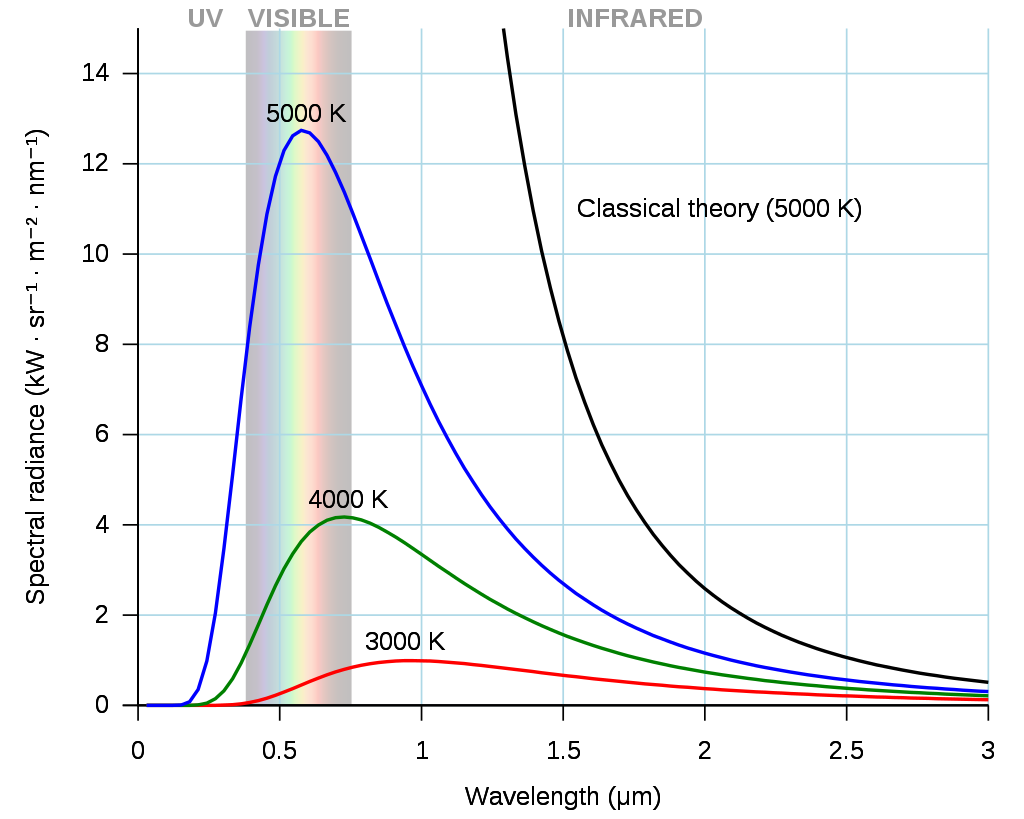

黑體輻射光譜

在物理學上,黑體(blackbody)是可以吸收所有入射電磁輻射的理想物理體;因它吸收所有顏色的光,故呈黑色,稱為「黑體」。黑體也發射所有頻率的電磁波,稱為「黑體輻射」;其頻率分佈稱為「黑體輻射光譜」(blackbody radiation spectrum)或「黑體光譜」。

實驗發現黑體光譜與物體之形狀或成分完全無關,只與其溫度有關。古典物理沒辦法解釋黑體光譜,導致了量子力學的發展(詳見《量子的故事》)。處於恆溫之熱平衡狀態的物體會發射該溫度之黑體輻射,其頻率或波長分佈如上圖。

黑體輻射的總能量與其溫度的四次方成正比,稱為「斯特凡-玻爾茲曼定律」(Stefan–Boltzmann law);其光譜的峰值波長與其溫度成反比,稱為「維恩位移定律」(Wien displacement law)。太陽表面溫度約為 6000K,其光譜的峰值落在可見光的範圍,正是我們眼睛所能感應到的電磁波(見上圖)!

你說這是巧合還是演化的必然結果?

宇宙微波背景輻射——理論

1960 年代,普林斯頓大學物理學家迪克(Robert Dicke)及學生皮布爾斯(Jim Peebles)對 38 萬年前可以自由地穿過宇宙的輻射感到興趣,開始探討這些輻射遺留下來的可能性。他們推論說:如果宇宙是根據大爆炸理論創造的,那麼在「光子去耦」時,這些輻射應與物質作用達到平衡,其頻率分佈應是 3000K 之黑體輻射的光譜,強度最高的輻射在紅外線區(波長約為 970 nm)。托爾曼(Richard Tolman)在 1934 年的《相對論、熱力學和宇宙學》一書謂:宇宙因膨脹而溫度一直在下降,輻射頻率的分佈當然也一直隨其溫度在改變,但卻永遠保持著黑體輻射的分佈特性。

去耦時的宇宙大約比現在小 1000 倍,溫度大約為 3000K,因此當宇宙空間膨脹到現在之值時,當時之黑體輻射峰值波長便應該增長 1000 倍到微波範圍的 970 μm。因黑體光譜的峰值波長與其溫度成反比,故如果黑體輻射峰值波長增長 1000 倍,黑體的溫度便應該下降 1000 倍到 ~3K。所以現在的宇宙應充滿著 ~3K 的黑體輻射,稱為「宇宙微波背景輻射」(cosmic microwave background radiation,縮寫為 CMB 或 CMBR)。

迪克及皮布爾斯都是動嘴不動手的理論物理學家,因此只好說服同事威爾金森(David Wilkinson)和羅爾(Peter Roll)去安裝天線搜索這些輻射(有心栽花…… )。

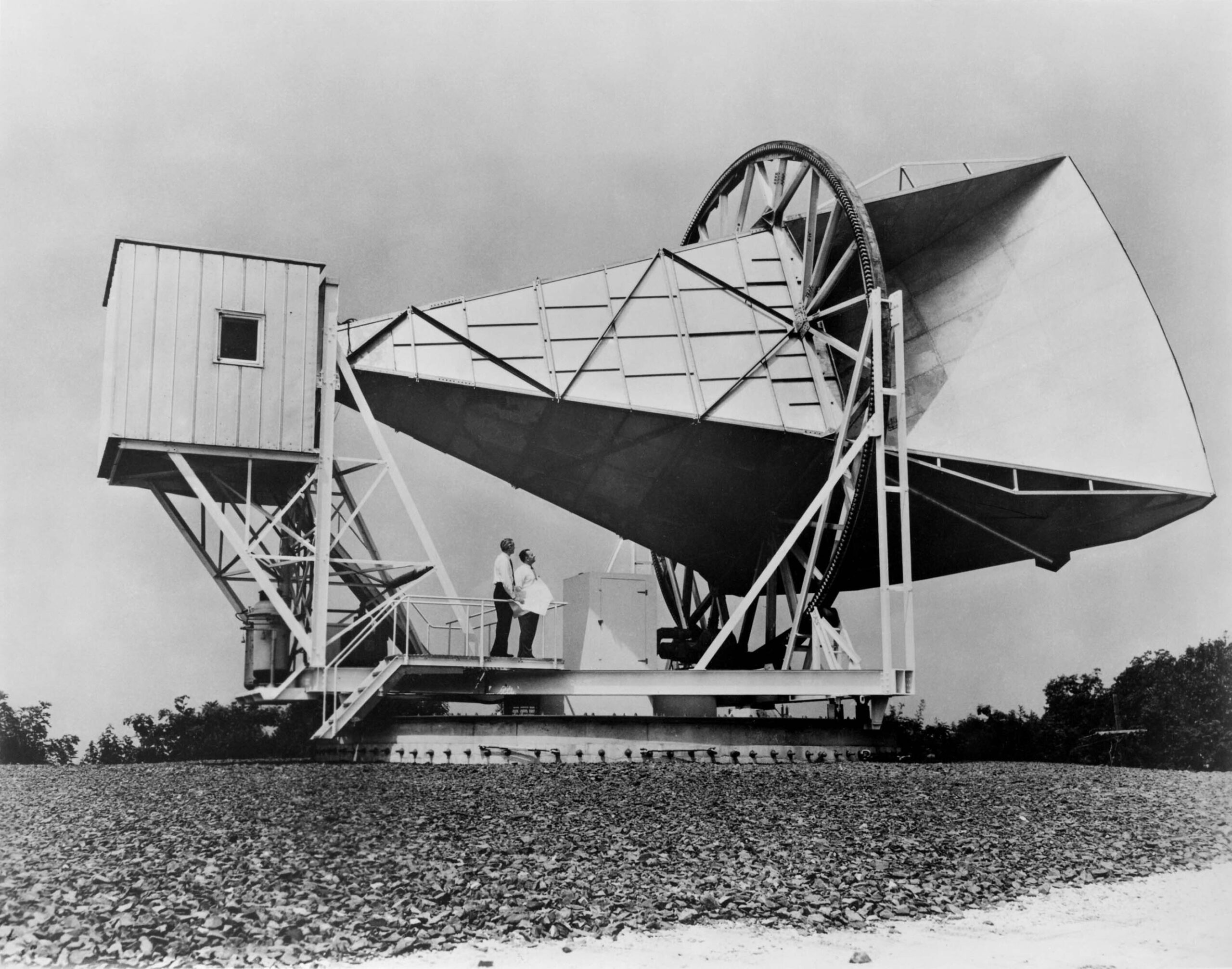

宇宙微波背景輻射——偵測

幾乎就在同時,貝爾實驗室的彭齊亞斯(Arno Penzias)和威爾遜(Robert Wilson)抓住機會,將該實驗室本想作廢的一個巨大的 20 英尺喇叭形天線,轉來作為輻射望遠鏡,以放大和測量來自星系之空間的無線電信號。為此,他們必須消除來自地面之雷達和無線電廣播的影響,並通過液氦冷卻接收器本身來抑制其核心的干擾。

在排除了能想到的一切過量輻射的來源後,他們發現接收器中仍持續存在有一種低沉、穩定、神秘的噪音。這殘留的噪音不但比他們預想的強烈一百倍,還晝夜均勻地散佈在天空;他們再次徹底檢查了設備,甚至清理了一些堆積在天線中的鴿子糞便後,噪音依然存在。顯然地,這 7.35 厘米波長的輻射不是來自地球、太陽、或我們的銀河系,而是來自銀河系外。可是什麼地方呢?

當麻省理工學院物理學教授伯克(Bernard Burke)告訴彭齊亞斯他曾看到皮布爾斯的一篇預印本論文,討論在宇宙出現後可能留下的輻射時,彭齊亞斯和威爾遜立刻意識到他們之發現的可能重要性。彭齊亞斯打了電話給就在附近工作之迪克,要了一份尚未發表的皮布爾斯論文。讀完該論文後,彭齊亞斯又打了電話給迪克,邀請他到貝爾實驗室看喇叭天線,欣賞背景噪音。迪克與貝爾實驗室的研究人員分享了他的理論工作後,認為後者(無心插柳)所發現的微波輻射正是他們正在尋找的大爆炸的標誌(柳成蔭)。

為了避免潛在的衝突,他們決定聯合發布他們的結果。 兩封快報同時迅速地在 1965 年的《天體物理學雜誌》(Astrophysical Journal)出現。在該雜誌裡,迪克和他的同事先概述了宇宙背景輻射作為大爆炸理論證據的重要性,然後彭齊亞斯和威爾遜報告了 3.5K 之殘餘背景噪音實驗,並謂迪克快報中的理論正可能是噪音的來源。

彭齊亞斯回憶說:「當我們第一次聽到莫名其妙的嗡嗡聲時,我們不明白它的意義,我們做夢也沒有想到它會與宇宙的起源有關。直到我們對聲音的起源用盡了所有可能的解釋後,我們才意識到我們偶然發現了一件大事。」彭齊亞斯和威爾遜因意外發現「微波背景輻射」而獲得了 1978 年的諾貝爾物理學獎。提供理論解釋的迪克及皮布爾斯則被排除在外[2]。據皮布爾斯的回憶:迪克在掛斷彭齊亞斯之電話後,曾無奈地向普林斯頓大學的同事說:「完了,同事們,我們被別人捷足先登了(Well, boys, we’ve been scooped.)」。皮布爾斯雖然在 1978 年與諾貝爾獎失之交臂,但在 2019 年還是因在物理宇宙學方面的貢獻而獲得諾貝爾物理學獎。

宇宙微波背景輻射——誰先提出?

事實上早在 1941 年科學界就開始有幾個對宇宙空間溫度的估計,但這些估計存在兩個缺陷。

首先,它們是對宇宙空間有效溫度的測量,並不表明宇宙空間充滿了黑體光譜。

其次,它們依賴於地球在銀河系邊緣的特殊位置,也沒有表明輻射分佈與方向無關。儘管如此,現在很多文獻都錯誤地認為第一位提出宇宙微波背景輻射的科學家是名科普作家伽莫(George Gamow)。

1940 年代初期,伽莫想知道早期宇宙的條件是否會產生科學家現在所觀察到的氫、氦、和其他元素。這項研究需要核物理知識,但當時美國的大多數核物理學家都被招募去發展原子彈,因此伽莫基本上是獨自一人在研究核合成問題。伽莫本人並不特別擅長數學計算,因此建議他的博士生阿爾弗(Ralph Alpher)去做這雜事。他們假設大爆炸後的宇宙非常熱、充滿了中子,原子核是透過一次捕獲一個中子而形成的,偶爾原子核會衰變產生一個更重的原子核(加上一個電子和一個中微子)。在 1948 年 4 月的論文裡,他們成功地預測了宇宙中氫和氦的比例(佔所有原子的 99.99%),為大爆炸模型的另一次重大勝利。

在上面提到的 1948 年的論文裡,伽莫和阿爾弗並沒有提到「宇宙初始膨脹的殘餘輻射」。幾個月後,阿爾弗和約翰霍普金斯大學同事赫爾曼(Robert Herman)發表了另一篇論文,謂現今觀察到的氫和氦濃度說明了在宇宙誕生後的幾分鐘內,宇宙的溫度曾經處於十億度的範圍內;並預測那早期宇宙中強烈輻射的微弱殘餘現今大約在「5K 左右」(兩年後他們重新估計為 28K)。事實上,阿爾弗說伽莫最初是反對這一預測的;他在 1997 年 8 月 25 日的一封信中寫道:

1948 年末,我和赫爾曼發表那篇論文後,伽莫三年來對預測(宇宙背景溫度)的貢獻一直是:對其正確性及意義強烈地表達了保留意見。後來他返回(這題目)並發表了幾篇論文,在理論上承認了這種輻射的存在,但繼續錯誤地計算其性質,混淆了數年的(歷史)文獻!

結論——從背景輻射,到恆星的「種子」

事實上彭齊亞斯和威爾遜並沒有探測到輻射具有黑體的光譜分佈;在 8 個月後,威爾金森和羅爾的實驗才總算開花顯示出 2.7K 光譜分佈的證據。但完全證明輻射的黑體性質則在更長的時間後才出現。靜態宇宙論雖然也可以解釋宇宙背景溫度,卻沒辦法解釋其光譜分佈,因此黑體微波背景輻射光譜的發現終於鞏固了大霹靂宇宙論在天文學上的地位!

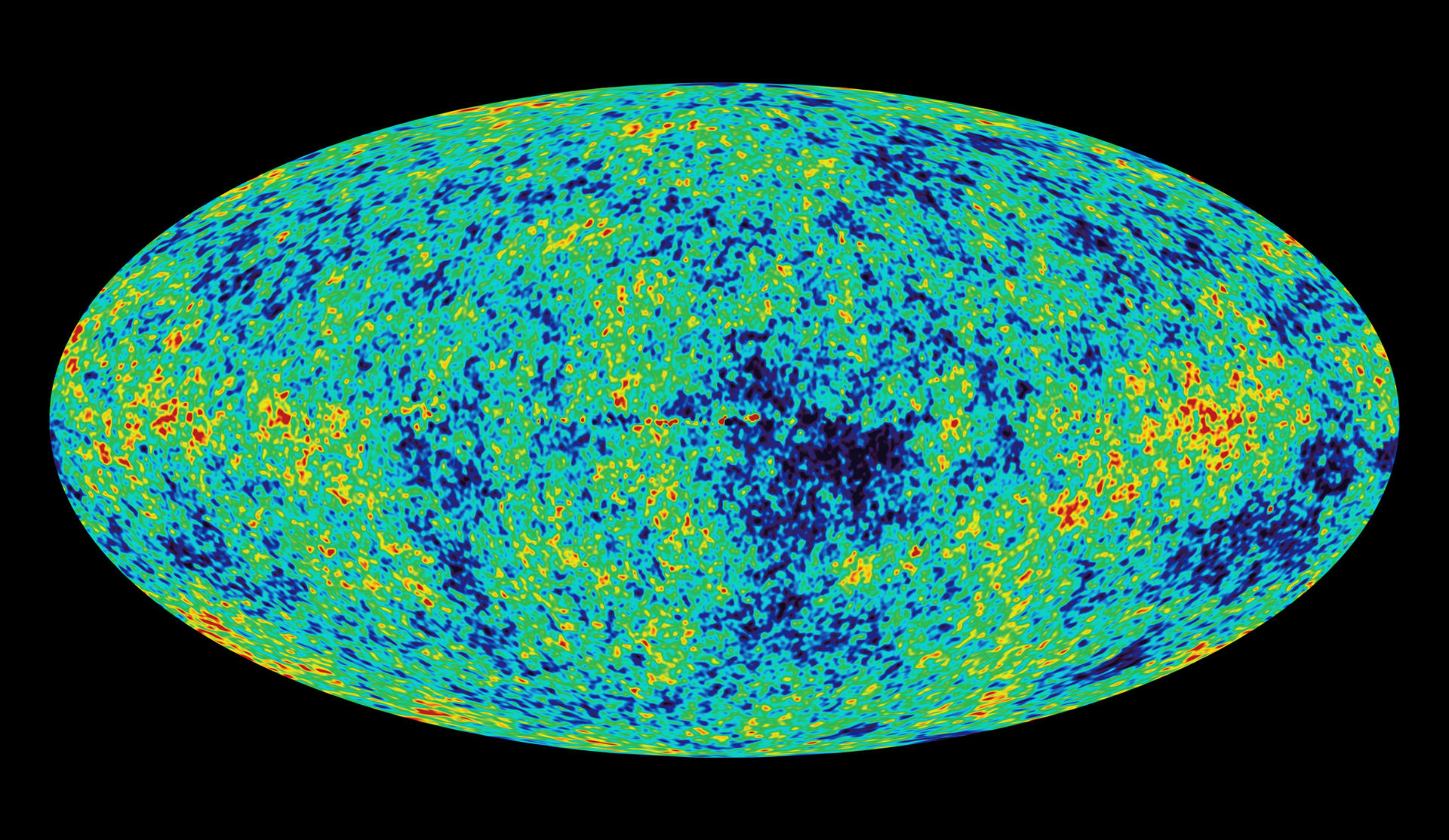

一個在空間均勻分佈的輻射怎麼可能產生星球呢?因此這一充滿空間的輻射必須有一些局部變化⎯⎯無論多麼輕微,來提供形成物體的「種子」。1970 年代,天文學家發現了宇宙背景輻射在不同方向上確實有些微差異。這一發現激發了美國宇航局投入數十億美元,在戈達德太空飛行中心(Goddard Space Flight Center)開始研製一種不僅可以測量背景輻射的變化,還可以證明它是黑體輻射的「宇宙背景探測器」 (COsmic Background Explore;COBE)衛星。

宇宙背景探測器於 1989 年發射。它準備花四年的時間來觀察蒐集資料。但在幾個小時內,它就證明了宇宙背景輻射的光譜分佈確實是黑體,完全符合與來自大爆炸時的理論計算。在 1992 年 4 月 3 日的新聞發布會上,加州大學柏克萊分校的天文物理學家斯穆特(George Smoot)宣布衛星探測器偵測到了宇宙微波背景的微小波動,為研究早期宇宙的一個突破:「我們觀察到早期宇宙中最古老和最大的現代結構(如星系、星系團等)的原始種子。不僅如此,它們也是(宇宙)創造時期遺留下來的時空結構中的巨大漣漪」;並謂「如果你有宗教信仰,那就像是看到了上帝」。馬瑟(John Mather)與斯穆特「因發現了宇宙微波背景輻射的黑體形式和各向異性」而獲得 2006 年諾貝爾物理學獎。

哈柏的發現改變了整個宇宙論研究的面貌,這麼大的貢獻,為什麼他從未獲得諾貝爾獎呢?原來那時的諾貝爾獎物理委員會不承認天文學是物理!因為這個關係,哈柏後來一直在努力爭取諾貝爾獎承認天文為一物理學的工作。

註解

- 註 1:因為正在撰寫這篇文章,筆者在此就賣個關子,不談牛頓如何解決這個問題。

- 註 2:是否因諾貝爾獎最多只能給三人之故就不得而知了。有趣的是:當初楊振寧與李政道因提出理論而獲得諾貝爾獎,吳建雄及雷德曼(Leon Lederman)之實驗驗證則被排除在外。

延伸閱讀

- 賴昭正:「我愛科學」(華騰文化有限公司,2017 年 12 月出版):裡面收集了下面那兩篇文章。

- 愛因斯坦的最大錯誤–宇宙論常數 (科學月刊 2011 年十二月號;或泛科學 2011/12/11) 。

- 黑體輻射的光譜分佈請參考「太陽能與光電效應」(科學月刊 2011 年十二月號)或《量子的故事》, 新竹凡異出版社,第二版 (2005)。

- 賴昭正譯(P.C.W. Davies 原著):「近代宇宙觀中的空間與時間」(新竹國興出版社,1981 年 8 月出版)。