對於新創團隊甚至是許多企業來說,「做公益」似乎很少會是第一優先考量 。因為做公益或稱之為企業社會責任 ( CSR, Corporate social responsibility ) 很難去衡量它的「績效」,大多數說法都僅止於可能對品牌形象有益 (無形面)。

對於新創團隊甚至是許多企業來說,「做公益」似乎很少會是第一優先考量 。因為做公益或稱之為企業社會責任 ( CSR, Corporate social responsibility ) 很難去衡量它的「績效」,大多數說法都僅止於可能對品牌形象有益 (無形面)。

其實大多數品牌並不是不想做,但在 時間、資源、金錢都是有限的狀況下,往往必須錙銖計較。更進一步來說,許多新創團隊除了面臨行銷推廣的問題,另一個常苦惱的問題是,如何拉攏心中已經有固定愛好品牌的人進入它們的生態圈。

自身難保,哪還有空理甚麼社會責任。「公益」、「獲利」這兩者真的那麼難兼具嗎? ( 這裡暫不提以公益需求出發的社會企業,有興趣的人可以參考 社企流 的個案 )

剛好最近在行銷期刊上看到一篇很有趣的實驗,實驗中量化、測量了 「道德行銷」(Moral marketing) 的效果。而實驗結果,證明了公益、獲利兩者是有強烈關聯性的,或許值得企業與新創團隊好好思考,能鼓勵企業與新創團隊們多多做公益。

什麼是「道德行銷」?簡單來說,就是孟子提到的 「人性本善」,一種觸發人們道德認知的行銷手法。

講到道德行銷,必須先跟大家介紹一個理論 ─ 道德身分理論 ( Moral identity ),或稱道德認同理論。

道德身分理論說的是,每個人對於自己扮演的角色都有一個道德認知模式 (包含特質、目標與行為) ,像是誠實、憐憫心、正義,因此會產生關心他人、幫助他人、對人友善的認知與行為。

道德身分認知 ─ 拉近與消費者距離的關鍵

學者認為如果能成功觸發人們腦中的道德身分認知,可以降低人們心中對於不熟悉品牌的距離感。換句話說,在人們的道德身分認知被觸發的狀況下,會更容易變成品牌的支持者、購買者。

而要觸發人們腦中的道德身分認知,可以分為長期與短期影響。長期包含著許多因素,從小到大的生長環境、學校教育、對事物的看法、個性…。

這個實驗主要會注重於如何 短期 / 暫時性地觸發人們的道德身分認知,特別是透過一些「關鍵文字」觸發腦中的道德認知。接下來讓我們來看看由學者 Choi & Winterich 所做的一系列「道德行銷實驗」吧!

第一個實驗,是一個 2×2 的實驗設計 ( 親近 vs 不親近的品牌、學生身分 vs 道德身分)

首先 Choi & Winterich 找了 90 名大學生受試者,請他們填寫問卷。問卷上列出了許多品牌名稱、 讓受試者挑選 覺得自己對於各個品牌的親近程度 (親近 or 不親近)。列完後,受試者被要求從 親近與不親近的品牌中各挑一個品牌出來。

接著受試者隨機被分派到 觸發腦中 「學生身分認知」 或是 「道德身份認知」的情境中。

在學生身分的情境中,列出了像是 書、鉛筆、電腦、書桌等字,請受試者用這些字寫成一篇短文。

道德身份的情境中,則是列出了像是、友善、關懷、公平、誠實等字,請受試者用這些字寫成一篇短文。寫完短文後,再請他們表達對該品牌的感受。

實驗結果發現,被觸發 「道德身分認知」 的人,對於不親近品牌的接納程度比被觸發學生身分認知來高得多。而親近品牌部分,兩邊則是沒有明顯差異。

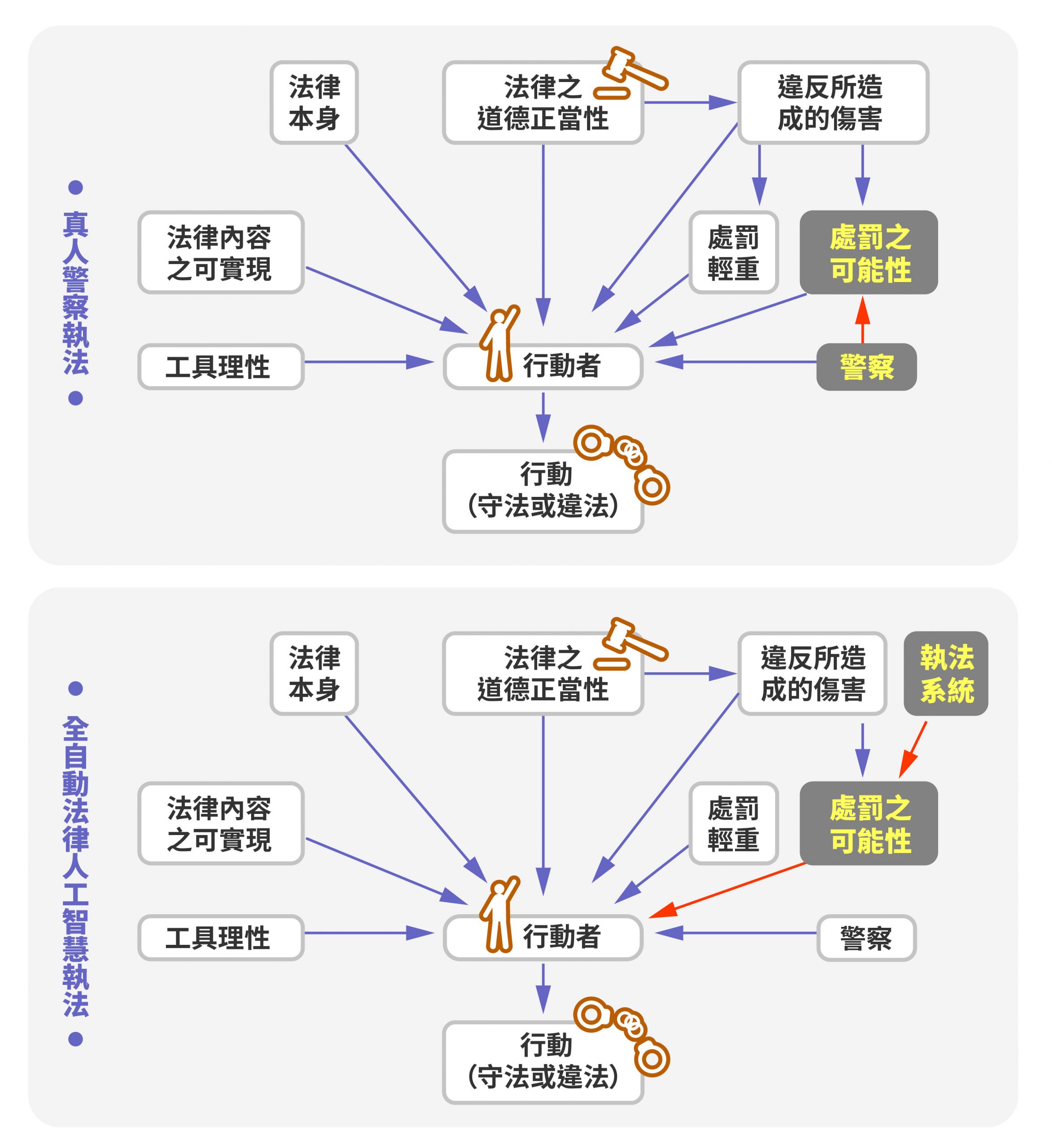

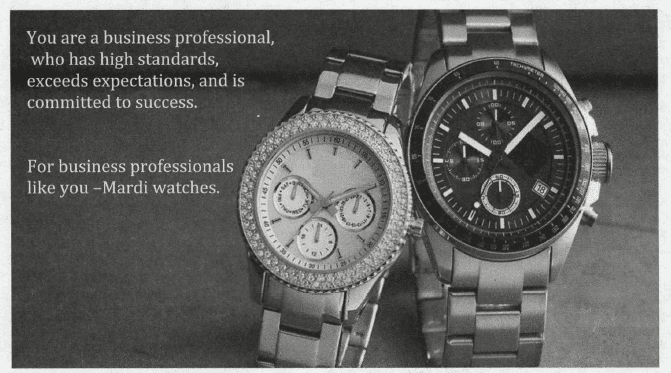

接下來學者進一步做了另一個類似的實驗,但是是用實際廣告去測試。想知道被觸發道德身分的人,是否也會由如同上述的結果。下圖為觸發 道德身分認知 vs 商人職業身分認知 的兩個廣告情境:

被觸發 「道德身分認知」的受試者,對於不親近的品牌手錶的願意購買意願比被觸發 「商人職業身分認知」 的受試者來高得多。而如果是親近的品牌手錶,兩邊依舊是沒有明顯差異。

會有這樣的行為結果,不是因為消費者覺得它是一個很道德的品牌,而是因為當人的腦部認知被觸發道德身分的狀況下,人會對外來 資訊 / 品牌 比較沒有戒心,自然與品牌的距離就被拉近了 !

這兩個實驗也證明了道德行銷的強力效果。但商業實務上要怎麼運用呢?接下來帶大家看看幾個實際案例:

一、 基本款,直接告訴你 ─ 你買我捐款

你買我捐款的公益活動,是最近很常見的手法。其實就是一種非常典型的 「道德行銷」案例,希望藉由直接平白的活動觸發人們腦中的道德身分認知,增進對品牌的親近程度與購買的可能性。

當你看到這些你買我捐的活動時,會不會更加想去消費呢?

二、 進階版,殺人於無形 ─ 廣告關鍵字讓消費者放下戒心

當初智慧型手機 iphone 能獨佔鼇頭,觸發道德身分認知的人性廣告可是幫了很大的忙。當初 iPhone 4S 剛推出強打的 siri 功能就是典型的案例。

影片一開始就以「What can I help you with ?」 為開頭,整部影片也都以「幫助」人們更便利為主軸。廣告利用「關鍵字」去觸發人腦中的道德身分認知,也因此讓人們對 APPLE 品牌更加有親近感。

http://www.youtube.com/watch?v=YnQFWYvxWDo

而 Samsung 能後來居上,廣告也不是省油的燈,影片以「 it understands you」「share what’s in your heart」、 「keep track of loved ones」等關鍵字觸發「關懷」的道德身分認知,來打動人心。

相較之下 HTC ONE 當初 2012 年的廣告僅僅只是強調其性能,強調連高空彈跳都可以攝影兼拍照。是否在感覺就差很多,會對它比較有距離感呢?

http://www.youtube.com/watch?v=TGp1O38CzJ8

道德行銷並非萬用靈藥

要注意道德行銷並非萬能,學者發現幾個限制條件:

- 對於你的品牌已經很親近的消費者,並不會有效。這個是顯而易見的,他已經夠愛你了,做不做公益、道不道德則是其次了。

- 如果你的品牌,已經先被消費者根深蒂固地認定為 不道德(或是 道德)的品牌,道德行銷也不會產生作用。原因很簡單,已經認定你很不道德了,你用道德行銷的手法怎麼還會有用?

無法吸引消費者嗎?或許你該考慮 道德/公益 行銷!

當你的品牌還是中立、且消費者對你還不親近時,道德行銷是最有效的!(值得新創團隊深思)

所以回到這篇文章的標題,企業社會責任真的那麼重要?我會說,是的。

如果你已經在做的話,且名聲還不錯。恭喜你,雖然道德行銷不會對你特別有利,但消費者對你的品牌形象已經根深蒂固地好了!

如果你還沒在做,一般消費者也沒聽過你的品牌,快快使用道德行銷拉攏你的消費者吧!

如果你沒在做,品牌形象又差,那拜託你請別炒短線,乖乖一點一點做公益慢慢累積回消費者對你的信任。

想拉近與消費者的心理距離,何不試試做公益呢?

看完上述的案例,你有想到甚麼其他的 道德行銷 的手法嗎?歡迎你與我們分享 🙂

文獻來源:Can Brands Move In from the Outside? How Moral Identity Enhances Out-Group Brand Attitudes, Woo Jin Choi & Karen Page Winterich, Journal of Marketing Volume 77 (iVIarch 2013), 96-111

衍伸閱讀:

- 行銷與心理學 ─ 實務案例:reBuzz x kono 獨家電子雜誌第一刊

- 行銷與心理學 ─ 商品定價:數大就是美,數字心理行銷學

- 行銷與心理學 ─ 商品命名:產品取名大學問!洋名一定比較好?

- 行銷與心理學 ─ 商品描述:利用「消費詞彙」,讓消費者多愛你一點!

reBuzz 來報這 專注於分享行銷與心理學、使用者行為、創新商業個案的分析文章,歡迎有興趣的朋友訂閱文章、加入粉絲團,大家一起來交流!