在 Google 的搜尋結果裡面,你的網頁會出現在第幾頁?被大眾看到的機會有多高?

在 Google 搜尋引擎中,有多項重要演算法來協助搜尋引擎的運作,其中,名為「PageRank」的演算法可說是關鍵中的關鍵。

PageRank 演算法已問世二十餘年,至今仍是 Google 於搜尋結果頁為網站劃分排名的核心依據之一,接下來,本文將一一簡介 PageRank 的發展及歷史、運作原理,以及它如何影響使用者所看見的搜尋引擎結果排名。

什麼是 PageRank ?

1990 年代,網路世界剛剛起步,搜尋引擎遠不如現在精確及貼近人心。1997 年,為了提升搜尋引擎的搜尋品質, 兩位 Google 創辦人 Sergey Brin 及 Larry Page 設計出了 PageRank 演算法,幫助使用者更有效率地找到能解決問題、實用的資訊。

PageRank 的核心概念是利用網站和網站間的連結 (link) 數量多寡與連結來源的品質,來判定一個網站的價值高低,以及其在網路世界中的權威性。

PageRank 的設計靈感來自學術界對論文的評估依據之一:越多人引用的論文,表示其內容的可信度越高、品質越好,在學術界的地位越重要。同理,越多網站願意引用、放置連結連過去的網站,表示其內容越受信賴,是個值得被使用者閱讀、能為使用者帶來實用幫助的優質網站,必須排在前面、優先被使用者看到。

起初,所有人皆可透過 Google 官方開發的專屬工具查看某個網頁的 PageRank 分數,並且將 PageRank 的分數當作 SEO 評估的重要指標。

但也正因為一切分數所見即得、高低明瞭,引來有心人士濫用,利用一些投機手段在分數高的網站硬塞入自己的網站連結以獲得高分,或是將連結作為買賣交換的商品、嚴重影響公正性。

2016 年,Google 官方宣布不再公開 PageRank 分數,以解決濫用亂象。然而,雖然 Google 隱藏了分數,但 PageRank 仍然是 Google 演算法中的重要骨幹且不斷修正漏洞、持續優化中!這一點已獲得 Google 內部負責維護良好搜尋體驗的網站管理趨勢分析師 (Webmaster Trends Analyst) Gary Illyes 兩次證實。

有多少人推薦你的網站?看反向連結!

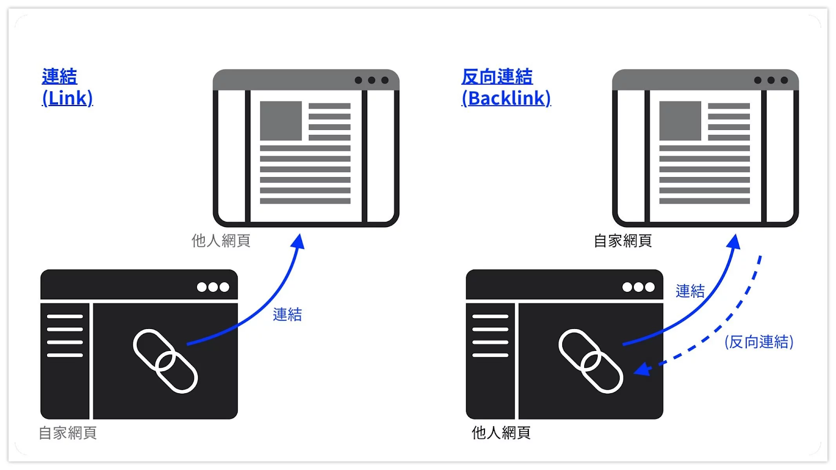

在了解 PageRank 的運作之前,必須先明白「反向連結」(Backlinks) 及「外部連結」(External Links) 的意義。

「反向連結」指的是「他人網域中,連到我的網站的連結」,而對他人來說,這是他網站中的「外部連結」,也就是「由某網域連到另一個網域的連結」。

例如,小美在她的網站裡放了一個連結導到我的網站,對小美而言,這是一個外部連結;對我而言,則是一個反向連結。

「反向連結」是 PageRank 考量的重要依據。如同前面所說的,當你的網站獲得越多反向連結、意味著你的內容被越多人引用及信賴;且 PageRank 的分數是可傳遞的,而反向連結就是傳遞的媒介。

總的來說,PageRank 會參考三項關鍵因素:

- 反向連結的數量以及連結來源網頁的品質

- 連結來源網站的外部連結數量

- 連結來源網站本身的 PageRank 分數

除了可傳遞性外,PageRank 運作的另一個重點是:分數會被連結對象所平分。

假設有 A、B、C、D、E、F、G 五個網頁。其中,A 是一個 4 分網頁,連結到 C 與 D;B 是一個 2 分網頁,連結到 C、E、F、G。五個網頁間的 PageRank 計算如下:

- C:獲得來自 A 的反向連結並與 D 平分分數,先得 4÷2=2 分,再加上來自 B 的反向連結並與 E、F、G 平分分數,再得 2÷4=0.5 分。最後為 2+0.5 = 2.5 分。

- D:獲得來自 A 的反向連結並與 C 平分分數,得 4÷2=2 分。

- E、F、G:獲得來自 B 的反向連結並平分分數,各得 2÷4=0.5 分。

(補充:以上是 PageRank 的簡易算法,更完整的計算方式詳見 WiKi。)

買連結來連向自家網站,不行嗎?

你有沒有看過充滿各種無意義連結的部落格?或是專門在別人文章留言並貼上一堆無意義連結的帳號?

由於反向連結是 PageRank 計算的關鍵,在過去 PageRank 分數仍公開、被濫用的年代,許多人會刻意到高分網站洗留言、拼命留下自己網站的連結,藉此「強制」獲得 PageRank 分數;又或者,高分網站開始兜售反向連結,浮濫連去各式各樣客戶的網站。

隨著 Google 的反制,大量洗連結、買賣連結等手段已經被明文禁止,也有相應的其他演算法來偵查這些惡意行為。像是企鵝演算法 (Google Penguin) 就是 Google 用來掃蕩植入劣質反向連結網站的演算法。

有趣的是,Google 自家的 Chrome 瀏覽器也曾經違反自家的規定而被懲罰,2012 年時, Chrome 因付費購買不當連結來行銷自己,對此 Google 除了公開道歉外,還將 Chrome 原先在搜尋結果第一頁的排名大幅調降,長達兩個月之久,而此事件也因此成為了 Google 反制劣質連結的經典案例。

別讓自己淪為人人喊打的黑帽 SEO!

洗連結這種欺騙搜尋引擎的作弊手法,在搜尋引擎優化 (SEO, Search Engine Optimization) 技術中被稱為黑帽 SEO (Black Hat SEO) 。

使用黑帽 SEO 雖然可能在短期內快速取得 SEO 成效,但正如上述所提,黑帽手法違反搜尋引擎的規範,所以如果使用黑帽 SEO 且被演算法發現,後果將會不堪設想!除了洗連結和買賣連結等,在文章中硬塞關鍵字也是黑帽 SEO 的一種。

- 補充:更多黑帽SEO手法介紹可以參考美國SEO權威網站MOZ

雖然 PageRank 演算法仍然是 Google 進行網頁排名的命脈之一,但如果網站經營者想提高自己網站的 PageRank 分數,最好的辦法還是打造出優質的網站內容,獲取其他高分網站的認同與信賴、願意在他們的網站中放上你的連結,爭取到高價值的反向連結!

參考資料

- PageRank – Wikipedia

- Google Penguin – Wikipedia

- Search Engine Land: Google has confirmed it is removing Toolbar PageRank

- Search Engine Land: Google Chrome’s Paid Link Penalty Now Lifted

- Ahrefs: Google PageRank is NOT Dead: Why It Still Matters

- Google搜尋中心:連結配置

- Google搜尋中心:搜尋引擎最佳化 (SEO) 入門指南