編按:你的理智知道「眼見不為憑」,但你的眼睛還是會背叛你的理智,不自覺得被眼前的影像所吸引,儘管你真的、真的知道他是假的。Youtuber 小玉於2021年底涉嫌利用 Deepfake 技術,偽造多位名人的色情影音內容並販售的事件,既不是第一起、也不是唯一、更不會是最後一個利用「深偽技術」進行科技犯罪的事件。

當科技在走,社會和法律該如何跟上甚至超前部署呢?本次 Deepfake 專題,由泛科學和法律白話文合作,從Deepfake 技術與辨偽技術、到法律如何因應,讓我們一起全方位解析Deepfake!

第一篇,讓我們就 Deepfake 技術做一基礎的介紹,那我們就開始囉!

什麼是 Deepfake?

深偽技術 Deepfake 於 2017 年陸續開始進入大眾的目光中。原文 Deepfake 源自於英文「deep learning」(深度學習)和「fake」(偽造)組合,主要意指應用人工智慧深度學習的技術,合成某個(不一定存在的)人的圖像或影片、甚至聲音。最常見的應用,就是將影片中的人臉替換為另一張臉(常是名人),讓指定的臉在影片中做出自己從未說過或做過的事情。

現今談到 Deepfake,大多數人想到的可能是偽造的成人影片,就如前述 Youtuber 小玉的事件,Deepfake 一開始受到關注,主要與名人或明星的臉部影像被合成到成人影片有關,然而,Deepfake 的功能遠不僅於此,相關的技術使用還包括了替換表情、合成一整張臉、合成語音等等。

除了像是讓過去或現在的名人在影片中「栩栩如生」做出使用者想要的表情與動作,之前在社群媒體上曾有好幾款 APP一度風靡,包括上傳一張照片就可以看看「變老」「變性」自己的 FaceApp,甚至於讓自己的臉在經典電影中講上一段台詞的「去演」APP,這類的功能也是應用前述 Deepfake 的技術。

雖然有些線索顯示這類 APP 常有潛在的資安疑慮[註],但好歹技術的成果多屬搏君一燦自娛娛人,尚可視為無傷大雅。

而過往電影的影音產業要仿造人臉需要應用許多複雜、耗時、昂貴的電腦模擬,有了 Deepfake 相關的技術,也使得許多只能抱憾放棄的事情出現了彌補的空間。最有名的應用應是好萊塢電影《玩命關頭7》與《星際大戰》系列。《玩命關頭7》拍攝期間主角保羅・沃克(Paul William Walker IV)意外身亡,剩下的戲份後來由弟弟擔綱演出,劇組再以 Deepfake 的技術讓哥哥弟弟連戲,整部電影才得以殺青上映。

Deepfake 讓「變臉」變得太容易了?

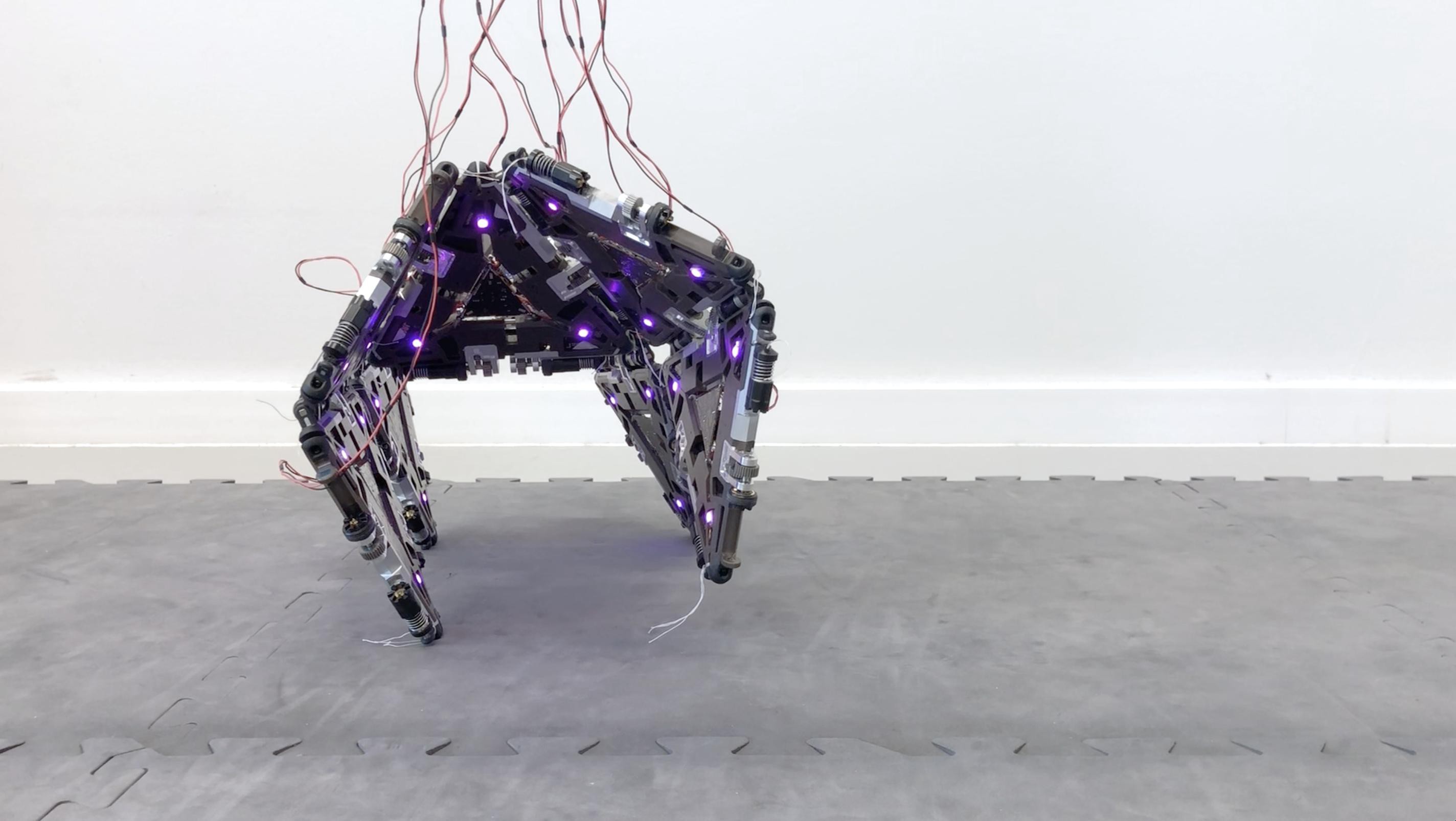

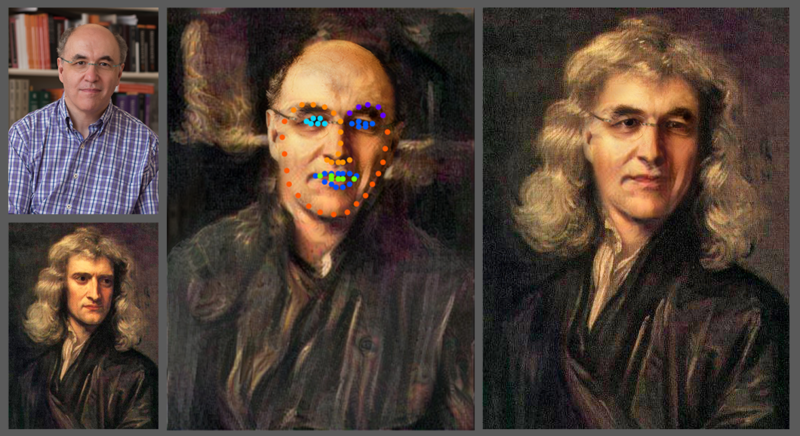

想想過去的電影如《魔戒》中的咕嚕、或是 2008 年布萊德・彼特主演的《班傑明的奇幻旅程》,將影片或照片中人物「換臉」「變老」的修圖或 CG 技術,在 Deepfake 出世之前就已經存在了。Deepfake 受到關注的核心關鍵在於,應用 AI 的深度學習的演算法,加上越來越強大的電腦與手機運算能力,讓「影片換臉」這件事情變得越來越隨手可得、並且天衣無縫。

過往電影中採用的 CG 技術要花好幾個月由專業人士進行後製,才能取得難辨真偽的影像效果,而應用了 AI 演算法,只需要一台桌上型電腦甚或是手機,上網就可以取得軟體、有機會獲得差強人意的結果了。

進一步,傳統軟體演算法主要依靠工程師的持續修改調整,而如 Deepfake 這類技術,內部的演算法會經過訓練持續進化。有許多技術被應用於提高 Deepfake 的偽造效果,其中最常見的一個作法被稱為「生成對抗網路(Generative Adversarial Network, GAN)」,這裡面包含了兩組神經網路「生成器(Generator)」和「辨識器(Discriminator)」。

在投入訓練資料之後,這兩組神經網路會相互學習訓練,有點像是坐在主人頭上的小天使與小惡魔會互相吐槽、口才越來越好、想出更好的點子;在練習的過程中,「生成器」會持續生成偽造的影像,而「辨識器」則負責評分,反覆訓練下來,偽造生成的技術進步,辨識偽造的技術也得以進步。

舉例來說,This Person Does Not Exist 這個網站就充滿了使用 GAN 架構建構的人臉,這個網站中的人臉看上去非常真實,實際上都是 AI 製造出來的「假臉」。

Deepfake 影片不一定是問題,不知道是 Deepfake 才是問題

現今的 Deepfake 技術得以持續進步、騙過人眼是許多人努力的成果,也不見得都是壞事。像是《星際大戰:俠盜一號》片尾,年輕的萊婭公主出面驚鴻一瞥,就帶給許多老粉絲驚喜。這項技術應用癥結在於,相關演算法輕易就能取得,除了讓有心人可以藉以產製色情影片(這類影片佔了Deepfake濫用的半數以上),Deepfake 製造的影片在人們不知情的情況下,很有可能成為虛假訊息的載體、心理戰的武器,甚至於影響選戰與輿情。

因此,Deepfake 弄假似真不是問題,閱聽者因此「不辨真假」才將是最大的問題所在。

相關的研究人員歸納了幾個這類「變臉」影片常見的特徵,可以用來初步辨識眼前的影片是不是偽造的。

首先,由於 AI 尚無法非常細緻的處理一些動作細節,因此其眨眼、視線變化或臉部抽蓄的動作會較不自然。其次,通常在邊緣處,如髮絲、臉的邊緣線、耳環等區域會出現不連貫的狀況。最後,在一些結構細節會出現不合理的陰影瑕疵,像是嘴角的角度位置等。

由於現階段的 Deepfake 通常需要大量的訓練資料(影像或影片)才能達到理想的偽造成果,因此會遭到「換臉」的受害者,主要集中在影像資源豐富的名人,如電影明星、Youtuber、政治人物等。需要注意的是,如果有人意圖使用 Deepfake 技術製造假消息,其所製造的影片不見得需要非常完美,有可能反而降低解析度、非常粗糙,一般人如用手機瀏覽往往難辨真假。

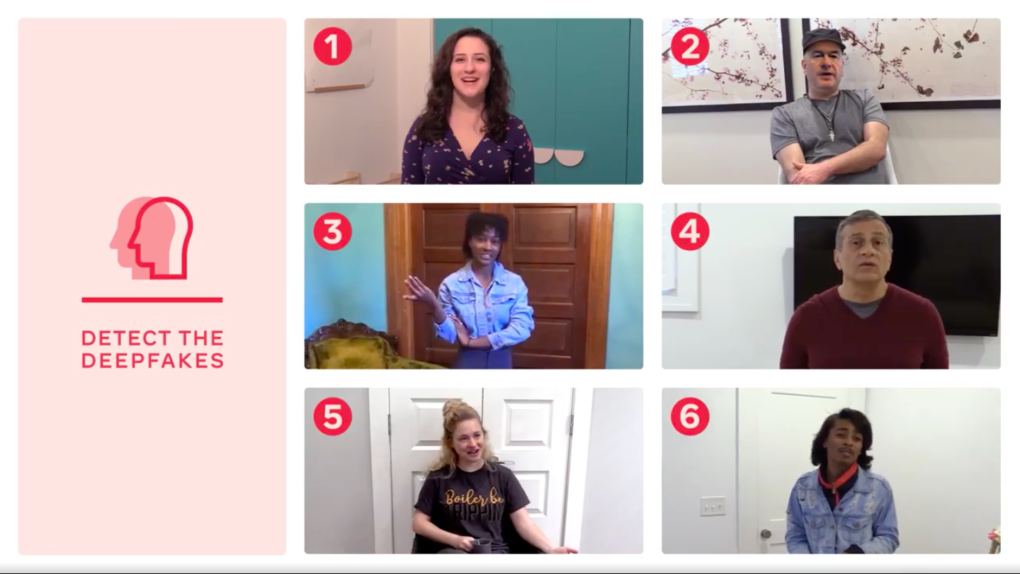

人眼已經難辨真假,那麼以子之矛攻彼之盾,以 AI 技術辨識找出 Deepfake 的成品,有沒有機會呢?隨著 Deepfake 逐漸成為熱門的議題,有許多團隊也開始試圖藉由深度學習技術,辨識偽造影像。2020 年臉書與微軟開始舉辦的「換臉偵測大賽」(Deepfake Detection Challenge)就提供高額獎金,徵求能夠辨識造假影片的技術。然而成果只能說是差強人意,面對從未接觸過的影片,第一名辨識的準確率僅為 65.18%。

對於 Deepfake 可能遭到的濫用,某部分我們可以寄望技術的發展未來終將「道高一尺」,讓社群平台上的影像不致於毫無遮攔、照單全收;然而技術持續「魔高一丈」讓防範的科技追著跑,也是顯而易見的。

社群網路 FB 在 2020 年宣布全面禁止 Deepfake 產生的影片,一旦有確認者立即刪除,twitter 則強制註記影片為造假影片。Deepfake 僅僅是未來面對 AI 浪潮,科技社會所需要應對的其中一項議題,法律、社會規範如何跟上?如何解決箇中的著作權與倫理問題?這些都將是需要經過層層討論與驗證的重要課題。

至少大家應該心知肚明,過往的網路流行語:「有圖有真相」已經過去,接下來即將面臨的,是一個「有影片也難有真相」的網路世界了。

- 註解:推出 FaceApp 與「去演」的兩家公司其軟體皆要求註冊,且對於上傳資料之後續處理交代不清,被認為有侵犯使用者隱私權之疑慮。

參考資料

- Deepfakes and the New AI-Generated Fake Media Creation-Detection Arms Race – Scientific American

- What To Do About Deepfakes | March 2021 | Communications of the ACM

- Tolosana, R., Vera-Rodriguez, R., Fierrez, J., Morales, A., & Ortega-Garcia, J. (2020). Deepfakes and beyond: A survey of face manipulation and fake detection. Information Fusion, 64, 131-148.

- Deepfake 深偽技術的技術濫用與道德困境,大眾正要開始面對 | TechNews 科技新報

- 台灣團隊研究辨識Deep Fake影片 深偽技術的正邪之戰開打 | 台灣事實查核中心 (tfc-taiwan.org.tw)