文 / 曾郁蓁

在2012年,加州的 Google X Lab 用一千台電腦架成的 Google Brain,展現了前所未有的機器學習能力。研究者們準備了一千萬張從 Youtube 隨機截圖的靜止畫面給 Google Brain「觀看」。研究者沒有在系統中預設任何圖像知識、也沒有在圖片上附加任何說明標籤,就讓機器自己發掘圖庫所隱含的規則。在三天的「觀看」學習之後,Google Brain 成功地將這些 Youtube 截圖分成了三類:人臉、身體、還有──貓。

能夠區分出貓的圖片,是Google Brain的一大突破,也是這個研究結果的一大亮點(及笑點),但它的重要性絕不僅於此。它代表機器從此能夠如同人類一樣,在龐雜無盡的資料中自己找出潛在的抽象規則,而不需要他人的說明或指導。它也標示著人工智能(Artificial intelligence, AI)的新篇章:深度學習(deep learning)技術。

深度學習

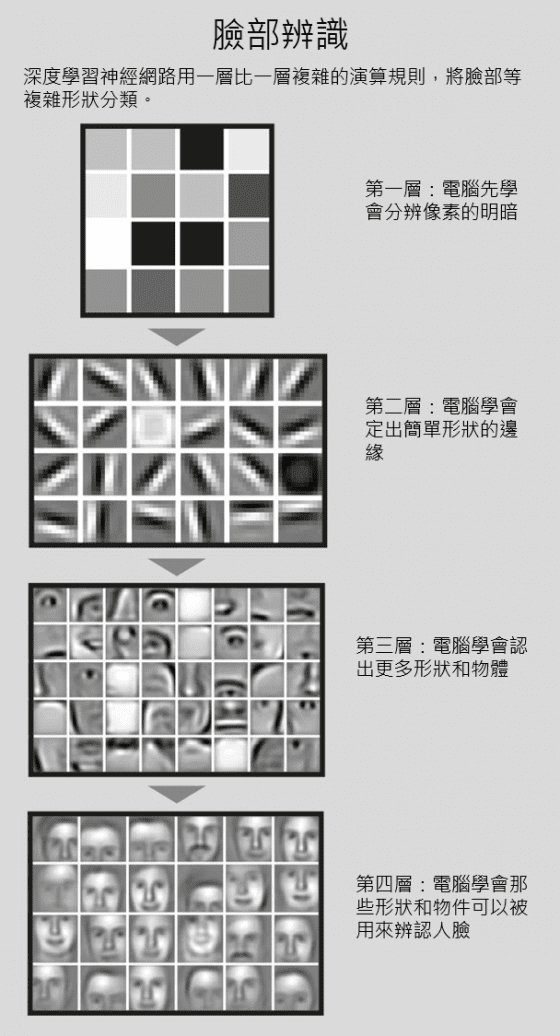

深度學習並不是研究者們憑空創造出來的運算技術,它是模仿神經網路的運算模式,以多節點、分層的運算來分析圖片上的特徵,最低層的節點們只計算每一個像素上的黑白對比,第二層的節點則根據第一層的資料、以連續的對比來分辨出線條與邊界,隨著層級越來越高、累積的計算資訊越來越複雜,就可以對圖片進行辨認與分類。以上述的Google Brain為例,它的結構一共分為九層,模仿人類視神經的分層與功能,最終可以分辨出人臉、身體、與貓圖片的決定性差異、並加以分類之。

神經網路模式運算也不是剛被提出的新玩意。早在1980年代,研究者們已經開始著手進行相關研究,至今相關研究仍在學界佔有一席之地。而隨著軟硬體的光速進步,這樣的技術已經開始被應用在真實世界。2009年,Geoffrey Hinton以及他在多倫多大學的研究團隊就以深度學習技術,開發出高準確度的語音辨認技術,能夠正確地將口語轉換成文字。而這樣的技術已經被廠商採用,搭載在許多智慧型手機之中。最為大眾廣為所知的手機虛擬助理,iPhone的Siri,便是仰賴深度學習技術,來辨認用戶的語音指令。

舊技術,新突破

而史丹佛大學的研究者 Andrew Ng,便是在同時間說服 Google 公司,讓他使用其公司的豐富資源來建立了 Google Brain。借助強勁的硬體與資料庫,一舉將深度運算技術推向新的紀元:發現潛在規則、自發性分類。這樣的技術比語音轉譯還難上許多,主要是因為其成果已經脫離的單純的資料對應轉換,而進化成在大型資料庫中找尋抽象分類與規則。也因此更接近人類的智能。

除了 Google Brain 這樣,因尖端科技公司出資贊助而在資源上佔有絕對優勢的深度學習系統,Andrew Ng 也研發出不需要一千台電腦就可以消化大量資訊的系統。他表示,使用圖形處理器 (graphics processing units, GPUs),就可以架設出功能類似、但成本更為低廉的運算系統來進行深度學習。

在2012年,Geoffrey Hinton 的團隊,就使用圖形處理器架設了一個深度學習系統。知名網路圖庫 ImageNet 每年皆會舉行一場圖片辨認比賽,這個網站會提供約一百萬張的標準化圖片,並標上其分類,參賽者必須寫出可以學到分類規則的語法,並用全新的照片測試之。Geoffrey Hinton 的深度學習系統使用同樣的圖庫,可以展現比過去參賽系統高出約10%的正確率。這樣的結果,讓他被Google 聘請去提升圖片搜尋的正確性。

廣泛的應用領域

除了圖片分類或語音轉譯,深度學習還有更多的用途。例如,Geoffrey Hinton 的學生 George Dahl 就應用深度學習技術,打敗了默克(Merck)藥廠現行的系統,成功提高了對特定化學分子間反應的預測力,以便更有效率地找出有用的藥物。他的團隊藉由這個深度學習系統,提升了約15%的預測力,更獲得了默克藥廠懸賞的2萬美金獎金。 Paskolos internetu su vekseliu iš žmonių automobiliui be užstato, paskolų refinansavimas, SMS greitieji kreditai

此外,麻省理工學院的 Sebastian Seung 也利用深度學習來分析腦部切片、以建立三維空間的腦圖,以及神經束的走向。這樣的系統除了更快以外,也節省了大量的人力。華盛頓大學的 William Stafford Noble 也應用深度學習系統來預測胺基酸鏈會組成如何的蛋白質、並可進一步預測此蛋白質的性狀。而這兩種應用的共同點都是其背後龐大的資料數量,以及深度學習所能提供的預測性。

人工智能的未來

雖然深度學習已經被應用到尖端科學研究及日常生活當中,而 Google 已經實際搭載在核心的搜尋功能之中。但其他知名的人工智能實驗室,對於深度學習技術的反應並不一致。

例如艾倫人工智慧中心的執行長 Oren Etzioni,就沒有考慮將深度學習納入當前開發中的人工智慧系統中。該機構目前的研究是以小學程度的科學知識為目標,希望能開發出光是看學校的教科書,就能夠輕鬆應付各類考試的智能程式。Oren Etzioni 以飛機為例,他表示,最成功的飛機設計都不是來自於模仿鳥的結構,所以腦神經的類比並無法保證人工智能的實現,因此他們暫不考慮借用深度學習技術來開發這個系統。

現行的人工智能程式,基本上都是將大大小小的各種知識寫成一句一句的陳述句,再灌進系統之中。當輸入問題進去智能程式時,它就會搜尋本身的資料庫,再選擇出最佳或最近解。2011年時,IBM 有名的 Watson 智能電腦,便是使用這樣的技術,在美國的電視益智節目中打敗的人類的最強衛冕者。雖然過去都是使用傳統式的手工輸入知識,然而 Watson 團隊現在也考慮將深度學習技術應用在部分的運算之中。IBM 的首席科技主管 Rob High 表示,他們現在已經在進行實驗,檢視深度學習能如何提高 Watson 辨認圖片的能力。

雖然各家人工智能實驗室對於深度學習技術的反應不一,但科技公司與電腦科學家們已經看中它的潛在獲利能力。George Dahl 已經著手在尋找創立公司的可能性,而 Facebook 的人工智能部門也開始招募相關領域的研究者。Andrew Ng 表示,深度學習的系統會隨著資料庫越龐大,而變得更有效率。當硬體與網路的不斷進化、各種影音資料急速累積,深度學習技術將會吸引更多研究者發展它的各種可能性。George Dahl也表示,深度學習還尚在襁褓之中、才開剛始發展,他預期,這個技術將是未來的一大趨勢。

原文:Computer science: The learning machines

參考資料:

- Google Brain報導:How Many Computers to Identify a Cat? 16,000

- Deep Learning(深度學習)網站

- ImageNet網站主辦之大規模圖片辨認競賽:Large Scale Visual Recognition Challenge 2013

特色圖片來源:Saad Faruque via photopin cc

-200x200.jpg)