2021年末,小玉的「Deepfake 換臉事件」讓大眾正視 Deepfake 技術的濫用問題。 Deepfake 發展至今不只有造假技術在進步,辨偽也是:目前任職於成大統計所的許志仲老師,從 2018 年開始便在這個主題中專研,並於 2020 年發表相關研究結果,該篇文章起今已有超過 50 次的引用次數。「以這篇論文發表的期刊影響指數(Impact Factor,簡稱IF值)來說,這個引用數相對來說是高的,這代表 Deepfake 辨偽的議題開始變得重要,但研究的人可能沒那麼多。」

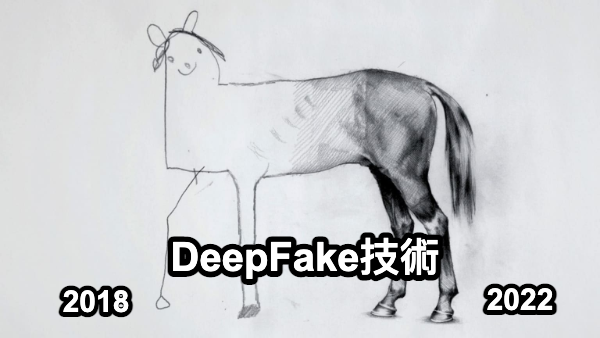

許志仲坦言,自己 2018 年研究 Deepfake 辨偽時,Deepfake 影片品質並沒有特別好。沒想到短短兩三年的時間,Deepfake 的效果就已經好到可能會造成問題了。

雙面刃的 Deepfake

Deepfake 技術起初是希望能藉由電腦產生各種不同的逼真圖片或影片,來因應特效製作或老照片修復之類的工作,而要產生逼真圖片或影片,有許多不同的方法都能達成這個目的,目前 Deepfake 最常使用的方法為 2014 年提出的「生成對抗網路(Generative Adversarial Network, 簡稱 GAN)」,透過生成網路與判別網路的對抗,產生逼真的圖片或影片,因此說到 DeepFake,通常都會說起 GAN。

「我們會說 Deepfake 就是 GAN,是因為就目前生成技術還是以 GAN 最好,當然也有新的方法正在發展,所以未來未必還是以 GAN 作為主體,可能用別的方法偽造,也能做得很漂亮。」

許志仲也表示,Deepfake 的發展目標是正面的,技術本身是中立的,但使用者怎麼使用這項技術,就成了重要問題。而在不能確保使用者心態的情況下,辨偽技術成了這項技術的最後一道防線。而 Deepfake 辨識的主要問題,可以分為偏向研究的「偽造特徵不固定」,以及偏向實務面的「辨偽系統的使用情境差異」兩個面向。

Deepfake 辨識的研究困難:偽造特徵不固定

現在已經有可以辨識貓狗、車牌等物體的影像辨識系統,這些辨識系統也相當成熟可靠,直覺來說,要做出一套辨識 Deepfake 的辨識系統,應該也不會太困難吧?

但實際上卻並非如此,過往辨識系統的做法是抓取容易辨別的特徵,例如貓與狗兩者在形態上就有明顯的差異,只要給電腦夠多的訓練資料,就能有一組精確區分貓與狗的判別式,且能用到各種需要分辨貓與狗的情況下。

先不談分辨人臉真假,就人臉辨識本身來說,就是個值得研究的問題,每個人的臉都長得差不多,差異在於五官的相對位置、形狀或大小有微小的差異,這使人臉辨識本身就難有通則可以去分辨。而不同方法生成相似的 Deepfake 圖片,並不一定具有相同的偽造特徵,從人臉特徵到偽造特徵都不固定,使得 Deepfake 辨識具有一定的困難度。

此外,即便用同一種方法製作同樣的 Deepfake 圖片,也會因為當初給的資料不同,使得偽造特徵出現差異,這讓「一組判別式就能判斷是否為 Deepfake」成為近乎不可能實現的夢。

也許,偽造特徵根本不在人臉上!?

面對 Deepfake 辨識的棘手問題,許志仲說:「要辨識的特徵太多元。我們覺得倒不如去尋找有什麼線索是 GAN 一致會產生的,這線索也許是我們眼睛看不到的,但是電腦可以透過學習的方式去挖掘,所以我就用了這種學習機制去抓出,會不會大部分的這種生成系統,都可能有共同的瑕疵。」

一張 Deepfake 照片並不只有人臉與五官,也包含了背景。而許志仲的論文指出,Deepfake 的偽造特徵,經常出現在背景,或是背景與人臉的交界處:

「臉通常都合成的很漂亮,但是背景跟臉的交界處會不自然。通常在髮絲的地方,髮絲的地方會糊掉這是一種,或是眉毛或者是額頭中的髮線也會有明顯差異。另外就是背景,會明顯看不出背景是什麼東西。大家都忽略看這裡(背景)很正常,而實驗結果也確實看到這些部分具有相對好的辨識度。」

然而,即便該篇論文是近期發布的,許志仲也不敢肯定這套辨識方式是否能套用在目前的狀況下,他表示目前每半年,GAN 生成的 Deepfake 影像的逼真度,就會有顯著的突破,且沒有消退的趨勢。

Deepfake 辨識的實務困難:辨偽系統的使用情境差異

在實務上,許志仲認為目前還有更為棘手的問題需要解決,那就是辨偽系統的使用情境差異。以一段 Deepfake 影片上傳 Youtube 平台為例,上傳的時候 YouTube 就會先對影片進行壓縮,這時原有的 Deepfake 偽造特徵很可能會因為壓縮而被破壞,許志仲解釋:「有些人會故意加上一些雜訊、加一些後處理,比方說整個畫面做類似美肌之類的處理,這些都會破壞掉偽造的線索,我們發現這些狀況十分常見,而且很難克服。這也是為什麼現在幾乎沒有軟體或網站,提供 Deepfake 辨識服務。」

在實驗室裡,我們可以拿到 GAN 生成的原始影像去做分析,但在網路世界裡,每一個影像都可能像上述的情況一樣,做了各種後處理才放到網路上,就算現在有研究指出某種辨認方式是有效的,也未必真的能應對網路上的複雜情況。

許志仲表示,目前看到有希望突破壓縮這個問題的辨認方式,是去抓人臉在一段影片中的五官變化是否足夠自然,這個線索可以克服壓縮的一點點問題,因爲是藉由五官相對位置的變化來偵測,這就跟壓縮沒太大關係。但正如前面提到的,人臉辨識是困難的,人臉的五官定位本身就無法做到精準,真要使用這套方法辨識 Deepfake,還需要更多研究來確認可行性。

也有研究者認為 GAN 理論雖然看似完美無瑕,但在產出 Deepfake 過程中仍可能會出現某些關鍵操作,只要藉由偵測畫面中是否有經歷這些操作,就能間接推測這個畫面是否為 Deepfake,不過這個做法的缺點也很明顯,那就是這些關鍵操作,也很可能只是正常的影片後製造成的,並造成不是 Deepfake 的影像也被歸類到 Deepfake 中。

情境逐個突破,讓研究能落地使用

說到這裡,許志仲語重心長地說:「我們研究做了這麼多偵測 Deepfake 的方法,但都不一定能在真實世界使用,這讓我非常意外,而上述的這些情境,也只是冰山一角。」

其實大家都在研究差不多的特徵,像是五官的落差,說話的時候嘴巴的動態變化會比較小或模糊之類的,但這些特徵面在真實的使用情境中,還能有多少辨識度,就真的是未知數。考量到真實情境的複雜度,目前許志仲認為逐個突破不同的情境下它們適合的辨偽方式,才是比較實實際的。

「我們必須先確認好問題是正確的,才能找到正確的答案。」許志仲說,要在實驗室裡做出一套數據漂亮的辨識系統並不困難,但要做出實際能用的辨識系統卻非常不簡單。

許志仲也嘗試將自己的研究成果運用在實際情境中,但面對製作公司精心製作的 Deepfake 影片,許志仲換了好幾套模型,也只有一套能判別出來,也呼應了「使用情境差異」才是辨識 Deepfake 無法落地的最大問題。

各界都在防範 Deepfake 影響生活

GAN 要能生成以假亂真的 Deepfake 圖像,必須建構在有訓練完善的生成模型上,而一個訓練完善的生成模型,並不是隨便餵幾筆資料給 GAN 就會跑出來的,必須要有足夠算力的電腦,配合大量的資料才能完成。除了像 Google 或 Facebook 這種規模的公司有能力製作外,也只有部分研究單位,能做出這種以假亂真的生成模型。

許志仲說:「由於 Deepfake 對社會的影響很大,現在他們都只公開自己的程式碼,但不會公開自己的模型,主要就是怕模型被拿去幹壞事。」許志仲也坦承,對於辨偽技術的研究來說,目前的狀況是非常不利的,這代表研究者必須自己用程式碼生出不那麼精良的模型,來製作 Deepfake 圖片測試。

面對未來 Deepfake 是否會無法辨別,許志仲表示就影像上來說,這件事情是做得到的,總會有方法做出不被任何辨識系統偵測,堪稱完美的 Deepfake 影像。但身為防禦方的我們,並不是只能靠圖片辨識真偽,上傳的使用者、社群平台的 meta-data,這些能標示來源的訊息,都可能是我們辨識這部影片是否為 Deepfake 的線索。

面對持續進化,仍看不見消退的 Deepfake 技術,許志仲也希望未來能有更多人一同加入 Deepfake 辨偽的研究行列,針對 Deepfake 辨偽系統的使用情境,我們還有非常多的問題等著被解答。