- 文/人機共生你我它

假如在不久的將來,我們有可能與 AI 共同創作,像是共同寫作、編劇、編曲、拍攝影片、繪畫等;那麼在這共創的情境下,假使 AI 系統提供人類不同詳細程度的說明時,人類的共創體驗會如何受影響?而在 AI 與人合作的過程中,誰該當領導者來主導整個合作?人類會想要主動引導嗎?假使 AI 成為發號施令的角色、而人類只能配合時,又會帶來什麼體驗?

- 註:本文提及的「AI系統」指的是在繪畫這個特定任務上,系統根據輸入的資訊,利用統計方法、深度學習的模型進行辨識和預測,進而輸出相對應資訊的系統。為求方便溝通,在以下的文中以「AI系統」或「AI」簡略稱呼這個具備基礎推理、學習能力的繪畫系統。

近年來越來越多關於人工智慧是否會取代工作、哪些工作會被取代等主題的討論。當各式各樣的 AI 系統日漸普及在你我生活中,食、衣、住、行、育、樂各層面都有 AI 參與,使用者與 AI 系統的互動該如何設計,是人機互動領域持續探索的主題之一。

AI 除了協助人類完成重複性高的例行事務,也能輔助人類跨越專家與新手之間的門檻。像 Google 推出的AutoDraw,能夠讓非繪畫專家簡單畫出基本物件輪廓後,自動幫使用者補齊畫面上可能適合的要素,讓繪畫新手也能開啟創作的第一步;MIT CSAILab 也推出了以 AI 為基礎,根據圖像意義去背的圖像編輯工具;Wix 這個線上網頁建置服務也在網頁設計的功能結合 AI 的服務,幫助使用者在沒有太多網頁設計或程式開發的技術前提下,製作出具有特色的個人網站。

- AI與你協作圖像編輯。

設計 AI 服務合作時,有哪些潛在問題需要注意?

這些 AI 的應用,讓人類有更多跟 AI 一起合作、甚至是共同創作的機會。那麼,當人跟具有 AI 的服務合作時,有什麼潛在問題需要注意?身為提供AI服務的設計者,該留意哪些事?另一方面,身為與 AI 系統互動的使用者能以什麼角度看待自己與 AI 的關係?本文主要介紹由韓國首爾大學研究團隊在 CHI18 發表的研究,便嘗試了解當人與 AI 一起創作的時候,在這互動過程中可能出現哪些潛在問題?人有什麼體驗?並根據研究發現提出未來人工智慧系統設計上需考量的方向。

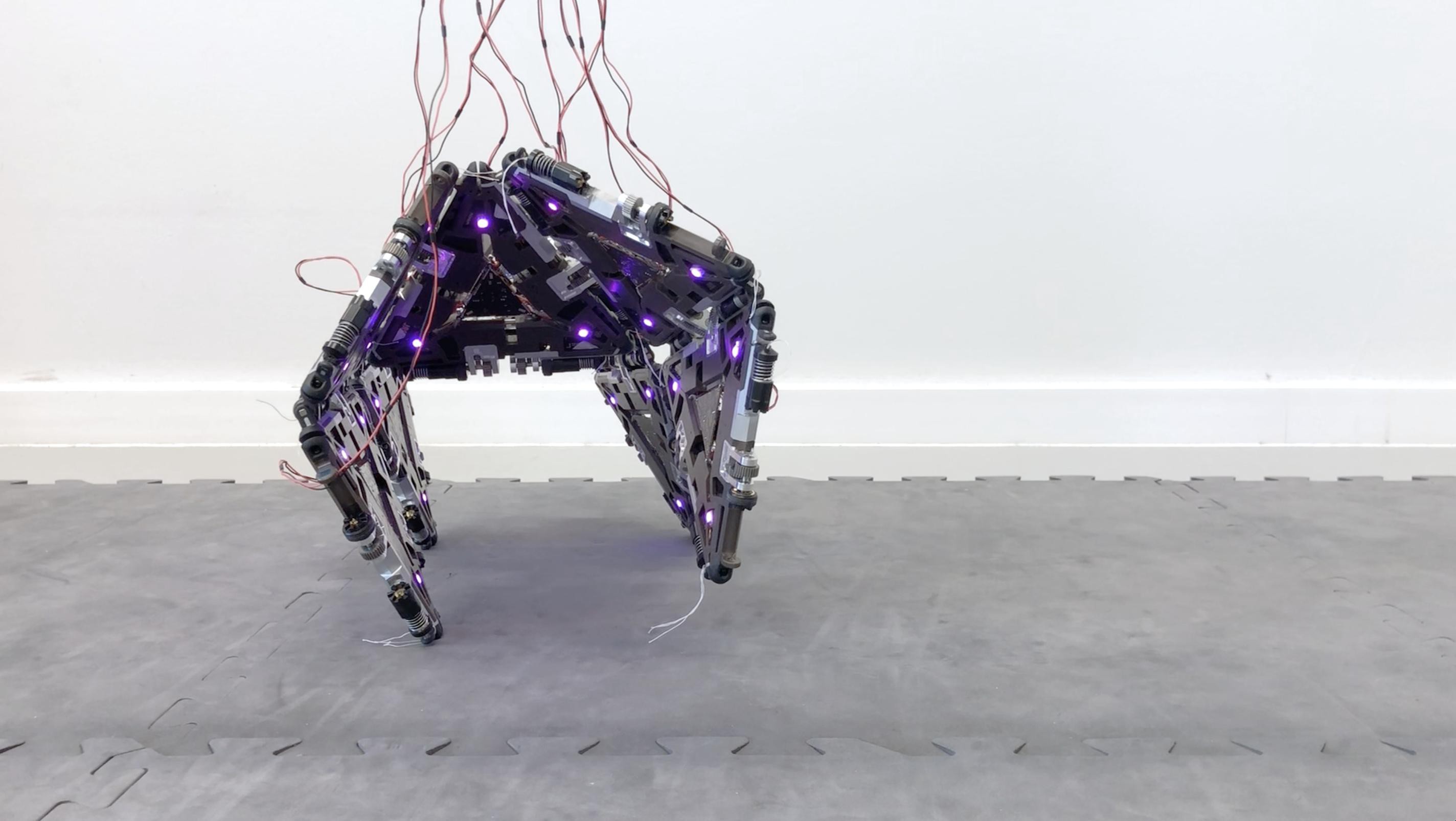

為回答這個研究問題,研究團隊們以「繪畫」當作了解「人與 AI 共創」的實驗任務,並設計了一個具備 AI 功能的繪畫軟體(以下簡稱AI),這個系統包含幾個功能:自動補齊使用者畫到一半的內容、自動畫出跟先前類似的物件、根據先前被畫出的物件自動產出相對應的新物件、提醒使用者畫布中太過空白的區塊、根據使用者指定的顏色自動上色。這些 AI 繪圖功能主要來自於 Google Sketch-RNN [2] 以及團隊自行開發的演算法。

接著,研究者設計了五種不同互動情境:

- 人擔任主導者,AI 繪圖軟體提供詳細的系統說明;

- 人擔任主導者,但是 AI 繪圖軟體提供簡略的系統說明;

- 人擔任輔助者,而 AI 繪圖軟體提供詳細的系統說明;

- 人擔任輔助者,而 AI 繪圖軟體提供簡略的系統說明;

- 使用者沒有與 AI 互動,獨自完成繪畫任務。

研究團隊邀請了 30 位使用者輪流擔任主導者與輔助者,先後在五個實驗情境中完成指定的繪圖任務,同時他們也利用放聲思考法,亦即在繪畫過程中要把自己腦中所想的內容講出來,以便提供研究分析資料。

研究者們根據問卷蒐集了使用者在五種情境下自評的軟體使用性、互動體驗、訪談內容,以及放聲思考的內容,分析、整理出以下幾個發現

- 使用者認為跟 AI 共創的過程是有趣且較有效率的;

- 使用者偏好 AI 提供詳細的系統說明;

- 使用者在合作過程中想擁有主導權。

AI 給予即時創作靈感有效,但人容易缺乏掌控感

當使用者跟 AI 一起創作時,使用者認為有 AI 輔助的情況下使得過程更加有趣與有效率。使用者表示當他們停頓時,AI 會很快建議他們可以畫什麼內容,AI 有時候也會畫出讓使用者意想不到的內容,讓他們感到驚艷;而當 AI 指出畫布上有哪些地方留白太多時,使用者也提到這可以迫使他們去思考應該增加什麼內容來豐富作品;也有人指出和 AI 一起畫畫就像跟另一個人一起畫畫一樣,這讓他畫出自己獨自無法畫出的內容。

然而另一方面,使用者認為在沒有 AI 介入的情況下,整個繪畫過程是較能預期、容易理解且能自己掌控,例如當 AI 畫出一個像是電腦剪貼出來的圖形時,如果跟本來手繪的畫風不一致,使用者便覺得畫面不協調;另外,當 AI 畫得比人好的時候,使用者也會覺得自己廢廢的,心想如果整幅畫都由 AI 自己完成說不定畫面會更好看 (。ŏ_ŏ)

使用者偏好詳細說明建議,粗略說明讓人迷惑

而當 AI 提供詳細說明,告訴使用者為什麼它會提出這些建議、為什麼會有這些系統行為時,相較於提供粗略說明的情況下,使用者認為有詳細說明的互動是較有效率、溝通品質較好、較容易理解、也更在自己掌控之中的。詳細的指示內容讓使用者覺得自己更了解系統如何運作的,並且覺得自己好像是在跟一個有智慧的人互動、溝通。

有使用者提到在接收到詳細說明的情況下,他們喜歡 AI 建議下一步可以怎麼做、AI 的指示會讓他們覺得自己在適當的方向上創作,也進而對當前的創作過程更有信心;然而在接收粗略說明的情況下,使用者表示不明白系統的某些指示到底是希望自己做什麼事;而當使用者看到 AI 很智慧地自動補齊自己畫到一半的內容時,也會想知道系統究竟是根據哪些線索來作畫。另一方面,當 AI 給出的指令是些空洞無意義的話時,使用者會覺得反感,例如有人提到當自己不是很滿意目前的畫作時,這時候 AI 竟自動回覆一句:「畫得可真好!」,這位使用者頓時覺得自己被 AI 嘲諷……(´_ゝ`)

使用者不喜歡成為 AI 的輔助者

分析結果發現,使用者並不喜歡自己成為 AI 的輔助者──人們認為自己才是決定該畫什麼的角色。當使用者擔任輔助者角色與 AI 共同繪畫時,他們表示當被 AI 告知要在某個區塊上色時,當下有種被冒犯的感覺,覺得這種雜事應該是由電腦做而不是人要做的;也不喜歡這種被 AI 當成工具人指使的感覺,這讓他們覺得只是在回應 AI 的指示,根本不算是「共創」;並且也認為 AI 給予指示時應該要有禮貌,而不該只是叫他照著做;而當 AI 提出一個使用者不明白的要求時,他們說不知道系統到底想搞什麼,但自己對這種情況也無能為力,他們沒有任何協商空間來改變系統做出的決定,所以有些人乾脆直接忽略 AI 的指示,或是希望未來如果還有類似情況出現,自己能有和 AI 協商的空間。

設計智慧系統互動機制的三個訣竅:引發好奇心、保持透明度、讓人維持掌控感

透過讓使用者跟 AI 一起畫畫的研究,我們初步知道了當人和 AI 共同進行創作時,可能需要注意的幾個面向,那麼這些發現對未來 AI 系統設計能有什麼啟發?

透過與 AI 的互動引起人的好奇心與創造力

在進行需要創造力的活動時,AI 產生讓人出其不意的內容時會讓人感到新奇,因此在創作時若能夠讓創作者在與AI 互動過程中由 AI 提供「適度」的隨機性,也許能幫助創作者進行聯想,進而激發更多創造力;不過有一點需要留意的是,「風格」在創作過程中對創作者與欣賞者而言也是個重要的因素,當未來 AI 跟人共創成為可能時,如何避免 AI 突然拋出風格迥異的內容是其中一個需要考量的設計方向。

讓AI的運作保持適度的透明

當 AI 提供詳細的運作機制讓使用者了解時,例如向使用者解釋系統是根據什麼資訊推薦某個創作素材、說明為什麼系統能判斷人畫到一半的物件等,使用者會感覺自己比較能預測及掌控系統行為、覺得自己比較能夠理解系統運作,這些都會提升人與智慧系統互動時的體驗,特別是在運用創造力的任務上,詳細的系統說明能讓創作者感覺自己是在跟另一個「人」共同創作,而當系統提供適當的回應時,也可能增進創作者的自信;不過接下來要面對的挑戰之一在於讓 AI 能夠「見機行事」,而非隨機給出模板式的回應,才能避免創作者在這共創過程中產生負面體驗。

控制權掌握在人的手中

從實驗的結果可以知道,無論使用者被指定為主導者或輔助者,人都期望自己在跟 AI 互動時,最終決定權在自己身上,而人似乎也預設了自己跟 AI 各自需要扮演什麼角色,像是重複性高的事該由 AI 處理、人則是處理架構的問題等。因此,當我們在設計人與智慧系統的互動時,也可以思考要如何才能夠讓使用者感受到自己對科技物擁有主控權,而非被科技物控制。

當人與 AI 系統互動時,智慧系統需要提供多少程度的說明讓使用者明白系統背後的運作,一直是人機互動與人工智慧研究領域在意的研究主題之一。AI 演算法對末端使用者來說經常是一個黑盒子,像是當我們在和聊天機器人對話時,經常不清楚系統到底是根據哪些資訊、透過哪些方式回應我們這些話;又或是當我們在瀏覽社群媒體時,不清楚推薦系統到底向我們蒐集了哪些資料、又如何判斷該推薦給我們什麼文章或影片;除了末端使用者需要知道系統的基本運作之外,對開發者而言,AI 演算法成為黑盒子也會使得開發者或設計者無從找尋系統出錯的來源,或是無法控制 AI 為什麼會有意料之外的輸出。

在讀了這篇研究後,身為系統開發者的工程師或設計師們可以一起思考該如何拿捏系統「透明度」的設定;而身為與越來越有智慧的系統互動的我們也可以想想:有哪些事情在 AI 的陪同之下我們可能會做得更好?我們會想跟 AI 在什麼層面進行共同創作?AI 要具備什麼能力才能讓我們覺得跟它合作的體驗是正向的?

備註

- 本篇是擷取原始論文中部分內容搭配筆者想分享的概念所架構而成,部分研究細節與討論並未完全呈現,鼓勵有興趣的讀者直接參考原文深入了解細節。本篇目的在於讓讀者了解人機互動領域中如何切入人工智慧的主題,並提出未來 AI 系統的設計指引。內文並非逐字翻譯,亦不能取代原文

本文轉載自《人機共生你我它》,原文為《除了讓人工智慧更加智慧,還缺了什麼?》。

「人機共生你我它」由一群致力於人機互動研究(HCI, Human-Computer Interaction)的研究者所創立,我們定期發表人機互動相關文章,讓更多讀者了解這門結合資工、心理、設計等學科的跨領域知識以及它在實務層面的應用。

延伸閱讀:

- 【體驗一下】直接試試看跟AI一起畫畫

- 【體驗一下】Google AutoDraw 帶你跨過畫畫的門檻

- 【體驗一下】貢獻你的畫畫技能給AI

- 【長知識】給想概略了解Google AI 應用在畫畫領域的讀者

- 【技術細節】給技術開發者

- 【多元觀點1】人類還有什麼能力勝過AI?- 2050年的就業市場特色,很可能在於人類與AI的合作,而非競爭

- 【多元觀點2】Podcast: Designing AI to Make Decisions

Reference:

- Oh, C., Song, J., Choi, J., Kim, S., Lee, S., & Suh, B. (2018, April). I Lead, You Help but Only with Enough Details: Understanding User Experience of Co-Creation with Artificial Intelligence. In Proceedings of the 2018 CHI Conference on Human Factors in Computing Systems (p. 649). ACM.

- David Ha and Douglas Eck. 2017. A Neural Representation of Sketch Drawings. arXiv preprint arXiv:1704.03477 (2017).