- 作者:黃伊平/執業律師,台北大學法學碩士

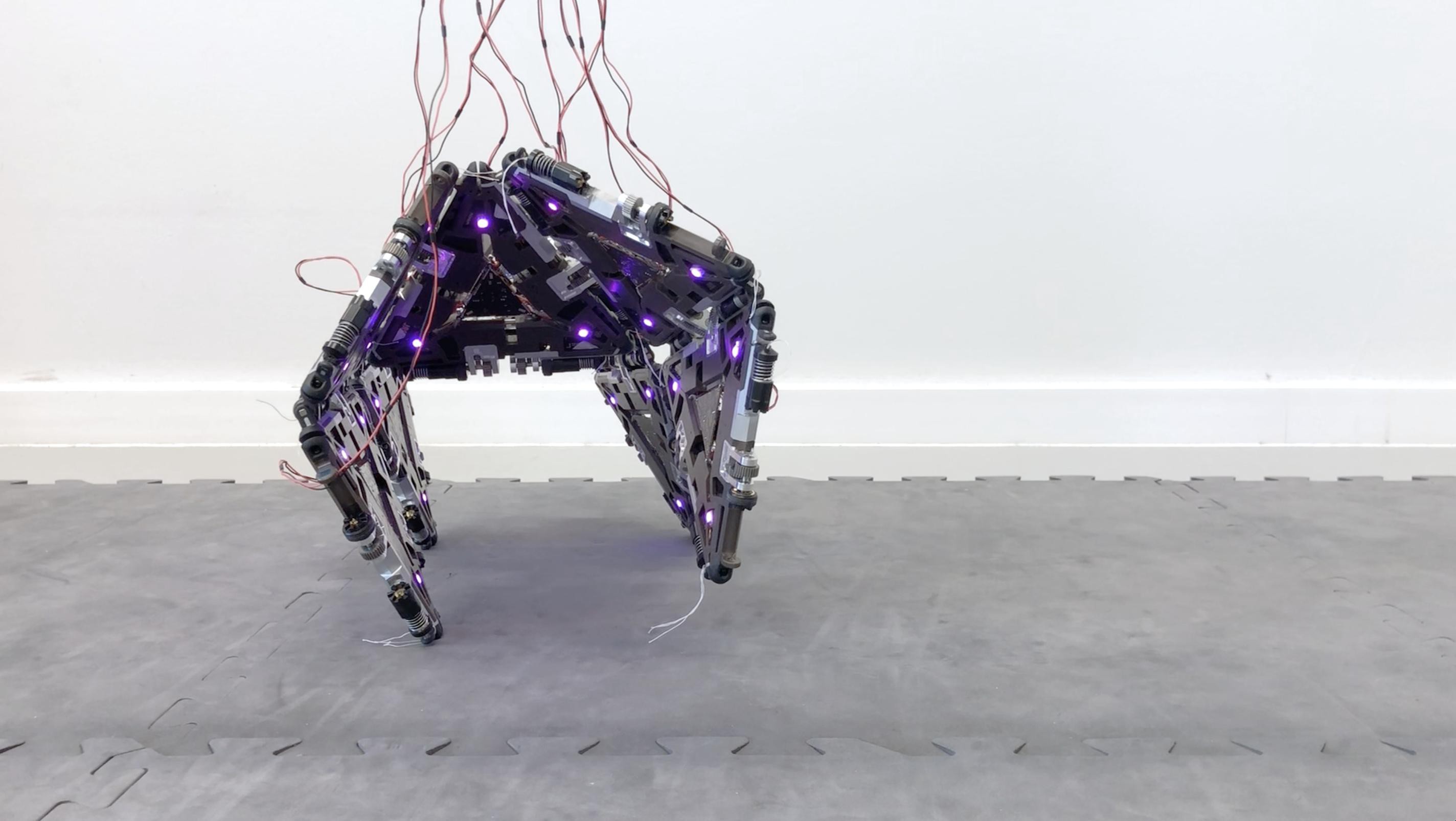

編按:在出現Deepfake之後,網路世界進入了「眼見不為憑」的年代。

本次泛科學和法律白話文合作策畫「Deepfake 專題」,從Deepfake 技術與辨偽技術、到法律如何因應。科技在走,社會和法律該如何跟上、甚至超前部署呢?一起來全方位解析 Deepfake 吧!

網紅小玉涉嫌利用人工智能 AI「Deepfake」(深度造假)技術,把多位公眾人物的臉部圖像移花接木到色情影片的主角身上,重製成「換臉影片」,並成立「台灣網紅挖面」社群,供人付費觀看,以獲取不法利益。被害人數眾多,其中不乏藝人、政治人物、知名網紅等。

而未經當事人同意,製作「換臉」的影片,這樣的行為會觸犯那些法律呢?

換臉影片觸犯《刑法》哪些罪名?

換臉影片屬於新型的數位性犯罪,在台灣還沒有處罰前例,目前大多認為可能會涉犯《刑法》的「散布猥褻罪物品罪」和「妨害名譽罪」。

「散布猥褻物品罪」包括哪些具體行為?

首先,刑法處罰「散布猥褻物品」的行為,依照實務見解是指:「客觀上足以刺激或滿足性慾,內容可與性器官、性行為及性文化的描繪與論述聯結,且引起一般人羞恥或厭惡感而侵害性的道德感情,有礙於社會風化的狀態」。

具體來說,「Deepfake」換臉影片的劇情,如果含有「暴力、性虐待或人獸性交」的情節,或雖然無關「暴力、性虐待或人獸性交」,但有引起一般人羞恥的性器官裸露、性行為的內容,且缺乏適當的安全阻隔措施(例如沒有用包裝隔絕並標示「18 禁」),就會違反《刑法》的散布猥褻物品罪,刑度是 2 年以下有期徒刑、拘役或科或併科 9 萬元以下罰金。

實務上,曾有人不滿女友提分手,憤而把交往時拍攝的女友裸體照片散布在社群網站 Instagram,被法院判拘役 50 天,並以「一天 1000 元」易科罰金。

還有一則案例是前男友在兩人分手後,在網路論壇上傳親密影片供人瀏覽,被害人直到聽朋友說網路上有疑似自己的性愛影片,才知道受害。而觸法的前男友,也被法院判有期徒刑 3 月,緩刑 2 年。

另外,如果換臉影片的內容涉及「未成年人」,加害人除了違反《刑法》的散布猥褻物品罪外,還會同時觸犯保護兒少所特別制定的《兒童及少年性剝削防制條例》——如「拍攝、製造兒童或少年為性交或猥褻行為之電子訊號罪」以及「散布少年為性交及猥褻行為之電子訊號罪」。

而且,基於特別法優先於普通法的原則,加害人將會被用刑責較重的《兒童及少年性剝削防制條例罪》來處罰。

舉例來說,有個案例是被告在拍攝自己跟未成年人的性愛影片後,用影片要脅被害人,又把影片上傳到色情網站。針對拍攝影片的行為,被法院處有期徒刑 1 年 1 個月;恐嚇未成年人的部分,則被處有期徒刑 3 個月,得易科罰金;最後,散布猥褻影片的部分,被處有期徒刑 6 個月,得易科罰金。

不過,並非所有傳送裸露照片的人都會被定罪,還需要達到「散布」的程度,實務就曾有被告先拍攝被害人跟自己性交時的照片,還有被害人的大腿、胸部等私密處,再將照片傳送給某位網友觀賞;法院認為,被告只有把照片傳給「1 名」網友,不算是「散布」,就不能用散布猥褻物品罪處罰。

換臉影片又為何符合「妨害名譽」?

所謂妨害名譽罪,包含「公然侮辱罪」和「誹謗罪」兩種類型。兩者的共同點,都是在保護人民的名譽免於侵害,但差別在於:前者是透過「表達意見」來侵害名譽,後者則是用「陳述事實」的方式來做。

實務上,有法院用「事實能否驗證」的判準來區分「公然侮辱罪」和「誹謗罪」。

換言之,如果行為人的言論,語意脈絡空洞而無意義,無法客觀檢驗所依附的事實,僅讓被害人主觀評價下的感情或名譽意識受損,就屬於「侮辱」;反之,如果語意脈絡具體而有意義,客觀上可以清楚理解、辨識指摘的特定事實是什麼,此時就傷害到被害人客觀外部的名譽,就是「誹謗」要處理的範疇。

舉例來說,曾有被告在他人臉書專頁文章下留言「智障超譯的女表子」等文字,法院認為「婊子」是針對撰文者的「性別」的侮辱性用語,判被告犯刑法的公然侮辱罪,處罰金2千元。

另則案例是:被告在臉書社團爆料公社上,張貼指摘被害人是「史上地表最強小三」等內容的文章,法院認為被告用散布文字的方法,指受害人是介入他人婚姻關係的第三者,足以貶損人格尊嚴與社會評價,所以觸犯刑法的加重誹謗罪,處拘役 45 日,得易科罰金。

那 Deep fake 換臉影片到底觸犯「公然侮辱罪」還是「誹謗罪」呢?

由於影片已直接將被害人的臉置換到 AV 內容當中,雖然沒有明確使用侮辱或謾罵被害人的文字,但影片本身已足以向觀賞者傳達「羞辱、侮蔑」被害人的意味,並讓被害人感受到極大的輕視和痛苦,所以可能會成立刑公然侮辱罪。

而含有性交和裸露鏡頭的換臉影片,一旦在網路流出後,不免有人會相信影片主角有拍攝的事實,將嚴重影響被害人在一般人心中的名譽和社會地位,所以也可能會成立加重誹謗罪。

而觸犯刑法公然侮辱罪,可處拘役或九千元以下罰金;觸犯刑法加重誹謗罪,則將處二年以下有期徒刑、拘役或三萬元以下罰金。

換臉影片還觸犯了《個人資料保護法》!

所謂「個人資料」,依規定包括:任何足以辨識個人的資料,包括姓名、生日、特徵等。由於製作「Deepfake」換臉影片,勢必會擷取被害人的臉部照片,而可以辨識個人的「臉部特徵」,實務肯認這就屬於《個人資料保護法》所要保護的「個人資料」。

而個人資料的蒐集、處理及利用,原則上需要得到當事人本人的同意,僅當政府機關基於法定目的,或私人基於契約關係、或其他重要的公共利益時,才能在不經同意的前提下,合理使用,但無論如何都不能侵害當事人的利益。否則,可能就會違反「非公務機關非法利用個人資料罪」,最高可處 5 年以下有期徒刑,得併科 100 萬元以下罰金。

類似案例像是:被告未經被害人同意,就在臉書社團張貼被害人的姓名、年齡、地址、個人大頭照、生活照、住家外觀照片,同時發表「小心這個人外表會騙人,目前侵占案避不見面」等言論。法院認為,被告把自己跟被害人間的債務糾紛私怨訴諸公眾,將被害人的個人資料揭露在臉書社團專頁,顯然侵害被害人的資訊隱私或自決權,觸犯個人資料保護法罪名,處有期徒刑 3 月,得易科罰金。

此外,為了製作 Deep fake 換臉影片,勢必使用明顯能夠辨識被害人的臉部照片,且非出於任何公益目的;依個資法,加害人就該負起「損害賠償」的責任!

肖像權被侵害,可依《民法》請求賠償

《民法》保障每個人的肖像權,這是一種「個人決定肖像是否公開的權利」,肖像權人可以自己決定是否揭露自己肖像,並決定在何種範圍內、何時、以何種方式、向何人揭露。

因此,如未經同意,就拍攝、重製他人的肖像等,就會侵害肖像權。

過去曾有案例,被告未經他人同意,就把被害人的照片後製,在臉上增加手掌圖案,並刊登在網路,表示「打臉」的意思,即使被告辯稱是為了評論與公益有關的事項,才製作網路圖片,但法院認為被告「並沒有」利用被害人肖像的權利,而以網路方式公開打臉圖片,已嚴重侵害被害人的肖像權。被害人除了可以請求刪除打臉圖片,也可以要求賠償自己的精神上損害。

因此,那些臉部照片遭盜用、被製成換臉影片的被害人,可以依法請求製作者刪除影片,並請求慰撫金──具體來說,法院將依照實際加害情形、所造成的影響、被害人痛苦的程度、雙方的身分地位、經濟情形及其他各種狀況,以確認合適的賠償金額。

換臉也是「性騷擾」,可以申訴啟動調查

什麼是性騷擾行為?《性騷擾防治法》指出:像是那些違反被害人意願,播送跟性或性別有關的影像,而有損害被害人的人格尊嚴,造成被害人感受敵意或冒犯的情境。

而換臉影片將被害人照片後製成 A 片主角,彷彿讓眾人看見赤裸裸的自己,使被害人深感冒犯和不舒服,就是一種性騷擾。

性騷擾事件的被害人可向直轄市或縣(市)主管機關提出申訴,主管機關即應開啟調查程序,並可依法對行為人處以新臺幣一萬元以上十萬元以下罰鍰。

而有鑑近年數位和網路性別暴力案例頻傳,行政院性別平等會更在今年 110 年 2 月 3 日,發布「數位/網路性別暴力之定義、類型及其內涵說明」一文,內容是參酌 CEDAW 一般性建議第 19 號第 6 段意旨,明確定義數位/網路性別暴力,明列數位/網路性別暴力的態樣,其中就包括「未經同意散布與性/性別有關個人私密資料」,並表態有意擬定相關防治政策、訂修法規,有待後續明顯進展。

要求換臉影片下架,有法律機制嗎?

被害人若發現某網路平台上有換臉影片,可以要求業者將影片下架嗎?

關於網路平台業者有無管制用戶言論的責任,曾有判決指出:網路業者並非司法機關,沒有判斷用戶行為是否構成侵害他人權利的權限,且若平台判斷錯誤,將有侵害言論自由的疑慮。為了兼顧用戶的言論自由及保護被害人權利,網路業者只有在「明知或有相當理由足認確實發生侵權行為」時,才有採取防止措施(例如刪文)的義務。

換言之,在侵權事實水落石出之前,依照法院的慣例,網路平台業者可能沒有主動和積極管制用戶言論的權責,被害人除非能證明權利受到侵害,才能要求網路平台業者下架影片,較難及時避免損害繼續擴大。

為了處理這樣的進退兩難,行政院在 107 年 4 月 27 日提出《數位通訊傳播法草案》,明定網路業者對提供使用的資訊,應負擔法律責任──當被害人告知或警察機關通知有侵權的內容,網路業者就應採取適當的處置並保全證據。

業者如果確實在合理期間內移除侵權資訊,並好好保全相關證據,就可以免除後續的賠償問題。因此,本草案如經未來立法院三讀通過,可望附加網路業者更多積極管制換臉影片的措施。

此外,依照《兒童及少年福利與權益保障法》的要求,須設立「iWIN 網路內容防護機構申訴管道」。若民眾發現有害兒少身心健康的網路色情內容時,可以向 iWIN 網路內容防護機構提起申訴,iWIN 機構將依規定進行查證,如查證屬實,即通知業者移除或改善,若屆期未移除或改善,主管機關可以對業者進行裁罰。

水能載舟,亦能覆舟,科技的發展原意是要改善人們的生活,然而一旦遭有心人濫用,所造成的危害,將是遠遠超出我們的想像。

如長期氾濫的虛假訊息、以及層出不窮的網路性暴力威脅,除了有賴立法管制,也不該忽略加強對網路使用者的教育宣導,而將性別平權的概念深植到每個人的心中,才能從根本解決網路/數位的性別暴力現象。

願立法追上科技的腳步前,我們每個人都自動自發地成為 Deep fake 換臉影片的終結者。當看見非法的色情影片,不下載、也不分享,提出檢舉,終結那些血淋淋傷害持續擴大的可能性。