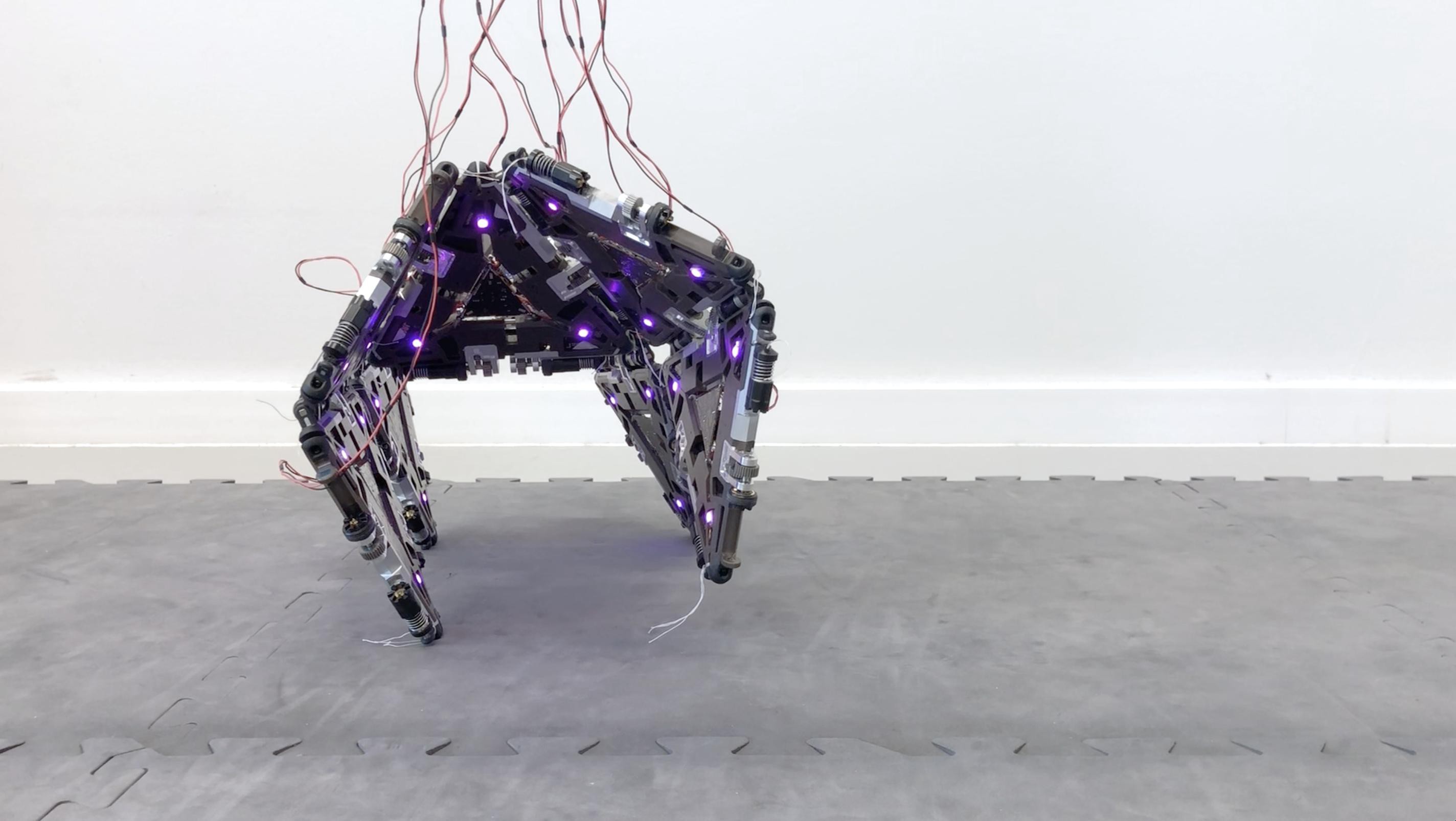

「機器人」的「人」從哪來?

英文單字「robot」,中文翻作「機器人」,這是個連國小生都知道的英文單字,但你知道中文「機器人」裡面的「人」其實可能是多加的嗎?

比較英文、中文單字的意涵後,可以顯現出中西方國家對機器人 (robot) 的不同看法。

首先,讓我們仔細看看在劍橋詞典 (Cambridge Dictionary) 裡面 robot 的英文定義 1:

a machine controlled by a computer that is used to perform jobs automatically

翻成中文的大意是:由電腦控制、被用來執行自動化作業的「機器」。

然而,若現在要臺灣人直覺想出一個機器人 (robot) 的樣子,一般人腦海中浮現的畫面,多或少會包含跟人相關的特徵,像是有五官、人型軀幹、會說話,甚至是會有像人的情感表現等等。

所以中文單字中「人」的成分到底從何而來?或者說,英文中「人」的成分去哪裡了呢?

從一部捷克的舞台劇開始談起

Robot 在英文裡事實上是一個新字,在 1922 年才第一次被使用 2。

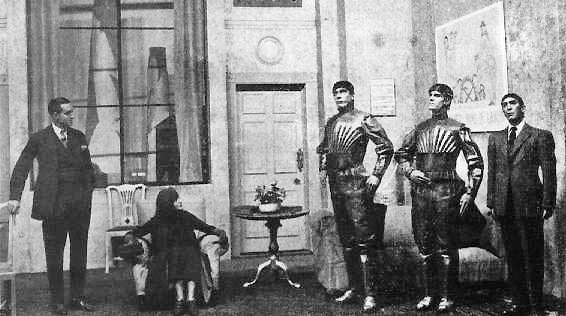

此字源自於捷克作家卡雷爾・恰佩克 (Karel Čapek,1880-1938) 所編的舞台劇作品「羅梭的萬能工人」 (R.U.R. 或作 Rossum’s Universal Robots) 3, 4,恰佩克用這一字指稱他劇中那些「可以替代一般人從事勞力工作、使人能有更多時間精力投入創造性事務的人造工人」。

劇中描述人類如何量產機器人、奴役機器人,最後被機器人反撲,甚至消滅的故事。

此劇對後世影響深遠,奠定了我們對機器人人型外貌、成為人類奴隸的想像,以及機器人最終將發動革命、消滅且取代人類的恐懼。

在原捷克語中,robota 意味著「役使勞力、奴役」,接近英文中的 servitude、 forced labor 或 drudgery5。捷克語的 robota 和英文 robot 相同,定義中並沒有「人」的概念。

只是翻譯不同,真的有差那麼多嗎?

也許這時你會想,翻譯中有些許落差又如何?不管是說「機器人」、「robot」或是「robota」,用詞雖然不同,但意境上大家腦中一樣都是浮現同樣的意義概念吧!

然而事實上可沒那麼簡單。

語言不只反映了文化背景、特定的文化價值以及歷史脈絡,甚至可能形塑我們與世界互動的方式。

目前已有相當多研究指出,使用不同語言的人,對事物的觀點、思考邏輯、甚至人格特質都會呈現系統性差異 6, 7,在心理學與語言學中稱為「語言相對論」 (linguistic relativity) 或稱「薩丕爾—沃夫假說」(Sapir—Whorf hypothesis) 8, 9。

目前已有許多證據支持語言相對論的觀點,例如,Tan 等人 (2008) 透過功能性磁振造影 (functional Magnetic Resonance Imaging,fMRI) 的研究發現,負責詞彙搜尋的腦區——包含左後顳葉顳上回 (superior temporal gyrus,STG) 以及下部頂葉皮質 (inferior parietal lobule) ——在色彩辨認的作業中出現明顯的活動,表示我們即使是在做一件和語言無關、無需語言表達或理解的事,語言區大腦仍參與其中 10。

然而不同母語使用是否直接且獨立地造就不同思維方式,這仍是學術界持續爭論中的議題 9, 11。

先不論語言使用是否是不同思維模式的一個「因」,不管它是直接或間接地框架了個人知覺世界、與外在互動的方式,語言都在人類認知體系中佔有一席之地,並反映了一個族群認知世界的獨特觀點 10。

例如,中文所說的「孝」在西方國家就沒有直接對應的概念跟詞彙,對於母語中不存在的詞彙,不僅僅是難以翻譯,甚至是難以理解與感知。

亞洲人對機器人的接受度比較高!

回到對於「機器人」這個概念的用語差異,robota 和 robot 二字,強調的都是其功能性、工具性,但在一些亞洲國家,如日本、華語國家,同樣的詞彙在翻譯中都 被放入了「人」的面向:

- 日文(人造人間;じんぞうにんげん;artificial human)

- 中文(機器人;machine human)12

此點差異不僅是反映在用字、用詞上,有不少研究者根據問卷與質性研究發現,亞洲國家(包含日本、韓國、華語國家)對於人型機器人的接受度比英美國家高,也偏好機器人有基本社交技能、有同理心,傾向認為機器人是有自主問題解決的能力與彈性。

相對地,歐美國家的受試者傾向於看待機器人僅僅是服從命令的機械構造,著重其功能性而非社交性,並認為家用機器人無異於高科技 的「家電」13-15。

簡言之,亞洲國家的人傾向視機器人為「對象」,而歐美地區的人傾向將其當作「工具」或「物件」。

千萬、千萬別把一切都歸因於語言

當然,此處的重點決非想把中西國家對機器人的不同態度歸因於用語、翻譯上的差異,字詞使用較可能只是思想與文化體系的一個表徵,而非促成文化差異的唯一推手。

況且,我們看待事物的態度是由相當繁多且複雜的因素交互影響產生,從個人成長歷程、媒體接觸,到教育、社會、文化等各層次的影響。也因為如此,文化差異應被視為一動態的現象,會隨世代演進而有所不同 7, 12。

在當今世界地球村的環境中,國與國之間的資訊流動幾乎已無界線,國家間、地區間的文化差異已經沒有過去明顯, 某方面來說,個人層次的影響因素,如個人過去與機器人的互動經歷,可能比文化差異更能解釋我們對機器人的不同接受度與態度 12, 16。

然而從機器人設計、製造的角度來看,我們不可能客製化所有機器人以符合個人需求與期待,文化背景仍是一項值得考慮的系統性因素 17。

而且,當前研究也存在著缺陷與限制

在學術與研究領域,不僅是對機器人的看法可能存在文化差異,其他面向的問題也都可能因受試者的文化背景而有不同發現。

社會科學領域的研究,時常被提出並質疑的一點,便是受試者代表性的問題,多數在大專院校實行的研究計畫均以大學生(也就是有基本經濟能力、受高等教育的人)為研究對象,而發表於頂尖國際期刊的學術論文則是以西方白種人為對象的研究佔多數,就此形成了所謂的「WEIRD populations」 。

即 Western 西方的、Educated 受過教育的、Industrialized 工業化的、Rich 富裕的、Democratic 民主國家的族群18。

頂尖科學期刊通常扮演著推進人類科學知識的引領性角色,若研究發現大多來自特定族群,很容易對該領域有偏誤的理解,尤其是在心理學、社會科學領域等研究人類行為、認知、主觀感受的學科 18。

上述針對機器人看法的跨國研究也顯示出,看似簡單通俗的概念,不同地區的人也可能有不同價值觀。因此,不管是研究者或閱讀者,都須謹慎於各個研究可能的限制、所回答問題的廣度,不應過度類推、誇大研究發現 19。

打開你的視野吧!別讓思維被單一觀點綁架

生而為人,不完全相同即是我們的共通處,不管是個人層次、家庭層次、社區層次, 至文化層次,個體之間的差異是無法避免的常態,也因此評價、思考事物時,須以一個更寬廣、更全面的角度加以探索,否則將被自身所在的視角限制住了。

究竟機器人 (robot) 應被視為對象或是物品,並沒有一定的答案,端看使用者期待什麼,以及使用的場域需要什麼。

機器人在社會中扮演的角色可以是相當多元的,像是陪伴型的社交機器人、功能性的服務機器人,以及用於自閉症的治療、復健機器人 20,相對地, 人們看待不同類型的機器人也可能有各種不同的態度與觀點。

只要是能促進生活便利、達成設計目標、滿足特定需求的,視機器人為互動對象也好、使用的工具也好, 都能促成有效且良好的人機互動 (human—robot interaction)。

參考資料

- 劍橋詞典 (Cambridge Dictionary):Robot

- Merriam Webster:Robot

- Capek, K. (1921/2004) Rossum’s universal robots (R.U.R.). Penguin, London

- 維基百科:羅梭的萬能⼯⼈

- Science Friday : The Origin Of The Word ‘Robot’

- Sapir, E. (1958) Culture, Language and Personality. University of California Press: Berkeley

- Chen, S. X., Benet-Martínez, V., & Ng, J. C. (2014). Does language affect personality perception? A functional approach to testing the Whorfian hypothesis. Journal of personality, 82(2), 130-143.

- Kay, P., & Kempton, W. (1984). What is the Sapir-Whorf hypothesis?. American anthropologist, 86(1), 65-79.

- Hussein, B. A. S. (2012). The sapir-whorf hypothesis today. Theory and Practice in Language Studies, 2(3), 642-646.

- Tan, L. H., Chan, A. H., Kay, P., Khong, P. L., Yip, L. K., & Luke, K. K. (2008). Language affects patterns of brain activation associated with perceptual decision. Proceedings of the National Academy of Sciences, 105(10), 4004-4009.

- Li, P., & Gleitman, L. (2002). Turning the tables: Language and spatial reasoning. Cognition, 83(3), 265-294.

- Lim, V., Rooksby, M. & Cross, E.S. (in press). Social robots on a global stage: Establishing a role for culture during human-robot interaction. International Journal of Social Robotics. pdf doi preprint: https://psyarxiv.com/be2p6

- Nomura, T. T., Syrdal, D. S., & Dautenhahn, K. (2015). Differences on social acceptance of humanoid robots between Japan and the UK. In Procs 4th intsymposium on new frontiers in human-robot interaction. The Society for the Study of Artificial Intelligence and the Simulation of Behaviour (AISB).

- Li, H., Milani, S., Krishnamoorthy, V., Lewis, M., & Sycara, K. (2019, January). Perceptions of Domestic Robots’ Normative Behavior Across Cultures. In Proceedings of the 2019 AAAI/ACM Conference on AI, Ethics, and Society (pp. 345-351).

- Lee, H. R., Sung, J., Šabanović, S., & Han, J. (2012, September). Cultural design of domestic robots: A study of user expectations in Korea and the United States. In 2012 IEEE RO-MAN: The 21st IEEE International Symposium on Robot and Human Interactive Communication (pp. 803-808). IEEE.

- Turja, T., & Oksanen, A. (2019). Robot acceptance at work: A multilevel analysis based on 27 eu countries. International Journal of Social Robotics, 11(4), 679-689.

- Šabanović, S., Bennett, C. C., & Lee, H. R. (2014, March). Towards culturally robust robots: A critical social perspective on robotics and culture. In Proc. HRI Workshop on Culture-Aware Robotics (Vol. 2014).

- Rad, M. S., Martingano, A. J., & Ginges, J. (2018). Toward a psychology of Homo sapiens: Making psychological science more representative of the human population. Proceedings of the National Academy of Sciences, 115(45), 11401-11405.

- Ramsey, R. (2020, April 24). A call for greater modesty in psychology and cognitive neuroscience. preprint: https://psyarxiv.com/hf5sv

- Broadbent, E. (2017). Interactions with robots: The truths we reveal about ourselves. Annual review of psychology, 68, 627-652.