- 文/人機共生你我它

根據社會地位的高低或個人價值的差異,來決定誰能過富裕舒適的生活、誰該活在貧窮與困苦之中,這種社會制度一點道理也沒有。

— 《收入不平等》Richard Wilkinson, Kate Pickett

前一陣子不幸發生食物平台外送員在外送期間發生車禍的意外,再次讓大眾注意到外送員勞動權益的問題。

今天我們不討論僱傭跟承攬之間的界線以及後續該怎麼處理,這篇文章想從評價系統如何影響我們行為的層面來跟大家討論:使用外送平台、Uber 服務、Airbnb 這類共享經濟平台的各方使用者如何被評價?而平台的評價機制會怎麼影響被評價者在不同環節中所做的決定,進而造成某些後果。

意識到這個評價系統對我們每個人的影響之後,就能夠知道如何改變或對抗評價系統,並降低意外發生的可能性。

根據台灣地區外送員在部落格的分享1,每週跑單 5~6 天,在沒有促銷活動的情況下,一個月大概 18K 左右,而外送平台的對外送員的獎勵機制會受訂單的每週接案率、訂單取消率、運送服務範圍、顧客評價、單位時間內達到的運送趟數、尖峰與離峰時間的訂單量而影響2、3、4、5。

在這樣的評價系統底下,背後的目的是為了要求外送員做到——把餐點在最快的時間內、以最好的餐點狀態以及好的服務態度送到客戶手上。這時候身為要賺生活費的外送員,為了達到能讓自己獲利的趟數目標,很合理的行為就是:騎車要「有效率」。

要怎麼有效率?就是多工,騎車的時候需要分配注意力在找最近的路線、密切注意餐點狀況、送達的時間、訂單狀況、如何安排自己的路線以及送單的優先順序,同時又要注意交通狀況。

在這樣緊湊又高壓的情況下,很難避免意外發生。

看出評價系統對我們行為的影響了嗎?

當我們所賺的錢是取決於我們多有效率完成任務,我們就會想辦法讓自己盡可能地快。在外送的情境下可能的後果就是交通意外;在工廠、辦公室裡過度追求單位時間內產量的這個評量指標,帶來影響的就是加班過勞;在學術圈裡過度追求發表量的評量指標,所產生的影響就是不健康的師徒制,以教學之名行壓榨之實。

共享經濟服務帶來的好處是讓閒置資源得以有效率運用,但盈利企業為了確保服務品質所設計的評價機制對不同環節使用者潛藏著什麼風險?

接下來我想透過共享經濟平台 (Uber, Uber Eats, Airbnb, Foodpanda 等)的設計,帶大家來看評價系統對人類行為的影響,接著一起思考我們可以如何改變。

當每次服務開始都被評價:演算法造成哪些影響?

一個負評就有可能丟了工作

客戶評分是所有共享經濟平台上會用來評價服務提供者常用的指標,在 Airbnb 上,房客可以為房東評分、Uber 乘客可以為司機評分、在食物外送平台上,餐廳跟點餐的客戶可以為外送員評分。

評價別人很容易,但是我們在評價別人之前,有沒有想過我們給的分數對眼前這個人會有多大的影響?

在美國的 Uber 與 Lyft(另一家載客服務)司機就曾經因為評價系統而吃虧,太多乘客們對於分數的認定跟平台系統評斷司機優劣的方式不完全相同,乘客給予 4 分很有可能就會讓他們失去後續接單的機會,因為「只」得到 4 分的司機在演算法的排序下很有可能完全接不到單,有司機向媒體分享,如果他分數在 4.6 分以下,那他真的得擔心自己未來要怎麼辦3。

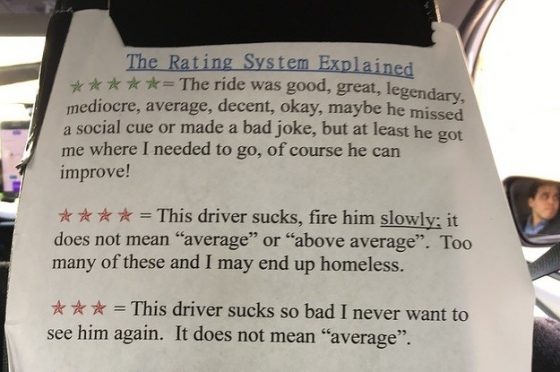

由於司機們覺得乘客在評分的時候,根本沒有意識到他們輕易給的一個分數會對司機的職涯有重大影響,於是司機們索性就在椅背上貼著一張紙,向乘客說明他們給的分數在評價系統代表的意義:

- 五分 = 這趟旅程很棒、還算可以,在路途中司機可能沒有注意到一些社交線索或是說了冷笑話,但至少他載我到我的目的地。

- 四分 = 這個司機很差勁,慢慢的開除他吧。(四分並不表示這趟旅程是普通或是平均程度,當得到太多四分的時候,我的下場就是流落街頭。)

- 三分 = 這個司機差勁到極點,我這輩子都不要再見到他。(三分完全不等於「普通」。)

這個問題也不是在美國才有,前一陣子我訪談台灣 Uber 司機,也有司機提到他必須很努力讓分數維持在 4.9 分以上,否則搶不到單;除此之外,今年也有 Uber Eats 的外送員表示如果他接收到一個負評,就需要靠多接很多訂單才能洗白,評分如果掉到 90 分以下也會被警告2。

當演算法介入評價系統,如果沒有讓所有利益關係人(司機與乘客)都知道背後運作的機制,帶來的不只是司機工作權益的問題,這些心理壓力連帶也會影響司機與乘客之間的關係。像是司機以為乘客帶有惡意在評價自己,對乘客有過高的警戒心等等。

捉摸不定的演算法帶來焦慮

另一方面,讓人捉摸不定的評價系統也會對使用者帶來焦慮。這裡以 Airbnb 的例子來說明。

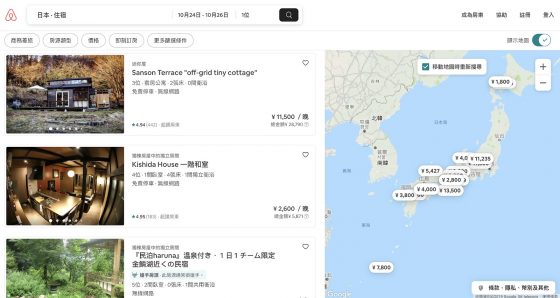

Airbnb 也是實現共享經濟的一個提供住房服務的平台,他們的研究員為了了解自己公司設計的演算法對於屋主的影響,在 2017 年訪談了 15 位使用他們平台提供住房服務的屋主6,發現房東們需要經常煩惱兩件事情,一個是如何吸引顧客,另一個是如何符合 Airbnb 演算法的期待。

屋主們經常擔心自己做了什麼事或沒做什麼事會被平台背後的演算法判定是「不好的」,進而影響自己的獲利。舉例來說,在 Airbnb 上面,旅客可以依序瀏覽符合搜尋條件的住處,但是誰的房子會先被看到是怎麼決定的呢?

由於屋主們不清楚演算法根據什麼來讓自己的房間被放在選單最上面,於是他們就定期更新房屋的照片、儘可能快速的回覆房客提問、或甚至是把房屋內各種設施都寫在標題,嘗試影響演算法排序的結果,想辦法在他們可以調整的範圍內讓自己的房間被房客瀏覽到。

對抗不透明評價系統:守規矩+逆向工程

面對這難懂的評價系統該怎麼辦?這個研究的另一個發現是屋主們會用一些方法來讓自己接受這個難以捉摸的評價系統,像是告訴自己演算法應該會是「公平的」,只要乖乖照著 Airbnb 的指示做,演算法就會讓他們更容易被房客搜尋到。

舉例來說,只要把自己的客戶評價都維持得很好,他們就確信 Airbnb 的演算法會讓自己的房屋被放在搜尋頁面上。

此外,研究者也發現另一招屋主會使用的方式是自己當工程師實測看看,透過逆向工程的方式,和網站上其他房東提供的房子的比較、自己嘗試改變網頁上的資料、根據附近的房價彈性調整自己房屋的價錢,或是去網路上爬各種房東的分享文來看,用盡各種方式來推測系統評價他們的方式。

共享經濟的評價系統可以如何改善?

Airbnb 對自家的服務做了深入的研究,透過這個研究,他們其實也發現了另一個難題:系統演算法到底應該設計得多透明?

對於公司利益來說,保持演算法有一定程度的模糊地帶是為了避免房東鑽漏洞,但是設計得太難捉摸又會使得房東無所適從,因此,他們提出了幾個共享經濟的平台可以改善的這種方案:

- 當房東嘗試在平台上做出會讓平台演算法判斷為「不好」的行為的時候,這時系統可以自動偵測並提醒他,幫助房東判斷哪些行為是對演算法的輸出有影響的,而哪些因素是演算法根本不會納入考量的。像是當房東延遲回覆太多次,背後的演算法就會把這個行為判斷為不好,這時候系統可以提醒房東,回覆速度的快慢會影響他的房間曝光度;但是如果房東經常更動標題,把不同關鍵字放在標題中,系統就可以提醒他做這些事可能大部分只是徒勞無功XD

- 這類型服務平台演算法在評價房東的時候,可以盡量只參考房東可以控制或改變的參數,像是他們的回覆態度、回覆頻率、顧客評價等,而盡量避開一些他們無法自己決定的因素,像是房子所處的地理位置或是擔任房東多久這些先天就決定好也難以做出什麼改變的因素。

補充:這裡的房東評價指的是房客會看到的分數,例如一個房東得 7 分(假使總分 10 分),不是因為納入了他的房子地理位置,而是因為他回覆太慢或態度不夠好這種他自己可以決定的因素,而不是一個他努力也改變不了的因素。

如同我們平常在被評價一樣,不能因為我是「女生」或我是「亞洲人」就認為我是一個比誰好或比誰不好的人,因為性別跟種族不是我們能控制的。 - 該怎麼在平台本身 (Airbnb)、服務提供者(房東)、服務使用者(房客)三個利益關係人之間取得平衡?目前可能的一種解法就是平台透過一些設計來促進房東跟房客之間的關係,像是想辦法透過系統設計來讓房東更同理房客的需求,另一方面讓房客也看見房東的努力,藉由提升雙方關係來達到三贏的局面。

其實不只 Uber、Airbnb,透過社群媒體行銷或是推出創作內容的人,也會面臨類似的焦慮。當 YouTuber 不知道 YouTube 是根據什麼機制來推薦自己生產的內容給觀眾時、藝術作品放在 IG 上不知道會被誰觸及、文章分享在 FB 或 Medium 上卻不了解平台背後演算法是如何影響觀眾觸及創作內容時,這些都會對內容或服務提供者帶來很多不可控制感以及焦慮。

辨識自己周圍的評價系統

一個適當的評價系統可以塑造出「好」的行為,就像 Airbnb 的優良房東機制就能鼓勵房東們帶給房客信任感以及良好的溝通,但是一個不適切的評價系統,就像是自己建立了一個不適當的牢籠來綑綁自己,引導人做出不適切的行為。

這篇文章並不是要傳達我們得完全摒除評價系統,畢竟有這些評價系統我們才有線索知道自己多會玩人生這場遊戲,這篇文章想讓大家意識到的是:

我們每個人所處的社會位置,其實都有不同的評價系統在影響我們的行為。

從小到大的我們的行為都被被各種不同的評價系統所形塑著,大學招生的時候會評量一個學生主科好不好,所以我們就想盡辦法在這些會被評量的層面上花很多時間,然後壓縮自己做其他休閒的時間(想想你是不是也經歷過類似從小開始學鋼琴、舞蹈、畫畫但是升上國高中後因為要「專心讀書」就中斷XD)。

大學的時候如果出席分數佔很多,我們就想辦法點名的時候一定要到;公司績效評鑑的時候要看我們業績多好,拉了多少客戶、提出多少可執行的企劃案,我們就用各種不同的方式達到帳面上可以交代的數字;學校計畫需要成果展示,當初規劃的經費有沒有用完是評量計畫成果的指標,我們就在計畫截止前趕快把錢花完;不勝枚舉。

許多時候衝突與傷害就來自於我們跟合作夥伴在不同的評價系統標準下互動,當兩個站在不同位置的人需要合作或互動的時候,他們各自所處的評價系統就會影響他們決定做什麼事以及決定怎麼做的優先順序。

舉例來說,當某些教授被評價的方式是研究發表量,而某些研究生被評價的方式是就業能力時,兩個不同的評價系統就會造成兩方目標不一致,然後形成衝突,一方覺得做研究比較重要,另一方覺得找工作重要。

在工作場合,設計師部門被評價的方式可能是讓使用者有好的體驗,但假使工程部門被評價的方式是有效率的做完手邊的案子,兩方合作就會因為目標不一致導致溝通受阻。

產業界被評價的方式是銷售量、可執行性,學術界被評價的方式是研究的創新與前瞻性,來自兩個不同評價系統中的人一旦需要對話,就容易因為沒看到各自其實是在追求不同目標而互相看不起。

看清自己處在什麼評價系統之中

談了這麼多並不是要得到一個「人生好難」的結論,而是希望大家在看完之後,去想想現在自己的社會角色(學生、員工、伴侶、晚輩、管理者、領導人等)是受什麼評價系統影響、這個評價系統衡量的價值是跟你在意的價值一致嗎?

一致的話,恭喜你!你能在這個角色上盡情發揮、如魚得水;但如果發現目前的評價系統不適合自己的話,可以想想這個評價系統評量你的方式真能夠衡量到某個價值嗎(創作品質、教學品質、設計品質、產量等等)?不適合的話,要不要考慮換到一個評價系統適合自己的地方?或是能如何改變這個評價系統?

記住,評價系統是人類自己建立的,人類需要仰賴評價系統來確認自己的價值跟位置。這個系統的存廢與內涵也只有我們自己能改變。

延伸了解更多:

參考資料

- Uber Eats桃園-市場分析,到底適不適合全職做呢?(2019/07/01更新) @ 大小人

- 自由時報 (2019, July 24).

易遭惡意洗負評? Uber Eats評分機制引外送員不滿 - O’Donovan, C. (2017, April 11)

Nobody Knows What Five Star Ratings Mean. That’s Bad For Gig Workers. - 【心得】台中UBEREATS外送員心得<更新如何增加接單率攻略>

- Uber機車UberEATS 台北獎勵方案(含最新嘉義雲林宜蘭花蓮) @Uber司機安安(10/14已更新) @ Uber司機安安租賃靠行包車旅遊一條龍服務

- Jhaver, S., Karpfen, Y., & Antin, J. (2018, April). Algorithmic anxiety and coping strategies of Airbnb hosts. In Proceedings of the 2018 CHI Conference on Human Factors in Computing Systems (p. 421). ACM.

- 【心得】台中UBEREATS外送員心得<更新如何增加接單率攻略>

- Lee, M. K., Kusbit, D., Metsky, E., & Dabbish, L. (2015, April). Working with machines: The impact of algorithmic and data-driven management on human workers. In Proceedings of the 33rd Annual ACM Conference on Human Factors in Computing Systems (pp. 1603–1612). ACM.

- Uber Eats桃園-當日達標獎勵與新人推薦獎勵的迷思(2019/07/01更新) @ 大小人

- 數位時代—王郁倫 (2019, October 15)

5萬外送員是雇傭還承攬?Uber Eats、foodpanda現身說:讓我們有下一個七年!

本文轉載自人機共生你我它,原文為〈[談評價系統與行為] 不適切的評價系統如何影響食物平台外送員?以及你、我?〉

-1-497x628.jpg)

-497x628.jpg)