文/呂宜瑾

從探索、深度學習到圍棋奪勝,人工智慧的歷史與發展

「人工智慧」(Artificial Intelligence,簡稱AI),顧名思義是由人類所製造出來的機器(電腦),透過反覆的訓練與學習所展現的智慧。AI內含了「機器學習」、「深度學習」與「自然語言」等概念,且依據電腦能處理與判斷的能力不同,產生不同的分級。

AI發展的歷史,從第一台電腦出現迄今已過半世紀,期間經歷了三波熱潮,前兩次熱潮因受限於當時的技術發展而退燒(曲建仲,2018;盧傑瑞,2018)。

(一)第一波熱潮(1950~1960年):探索與推論的時代

1946 年,全世界第一台電腦Enica誕生,之後的 10 年,在 1956 年達特茅斯研習會(Dartmouth Workshop)中首度出現「人工智慧」 (Artificial Intelligence,簡稱 AI)的專有名詞。

(二) 第二波熱潮(1980~1990年):知識的時代

專家系統:自 1980 年開始,將大量的專家知識輸入電腦中,再由電腦依據使用者的問題來判斷答案,後續應用在疾病的初步診斷。

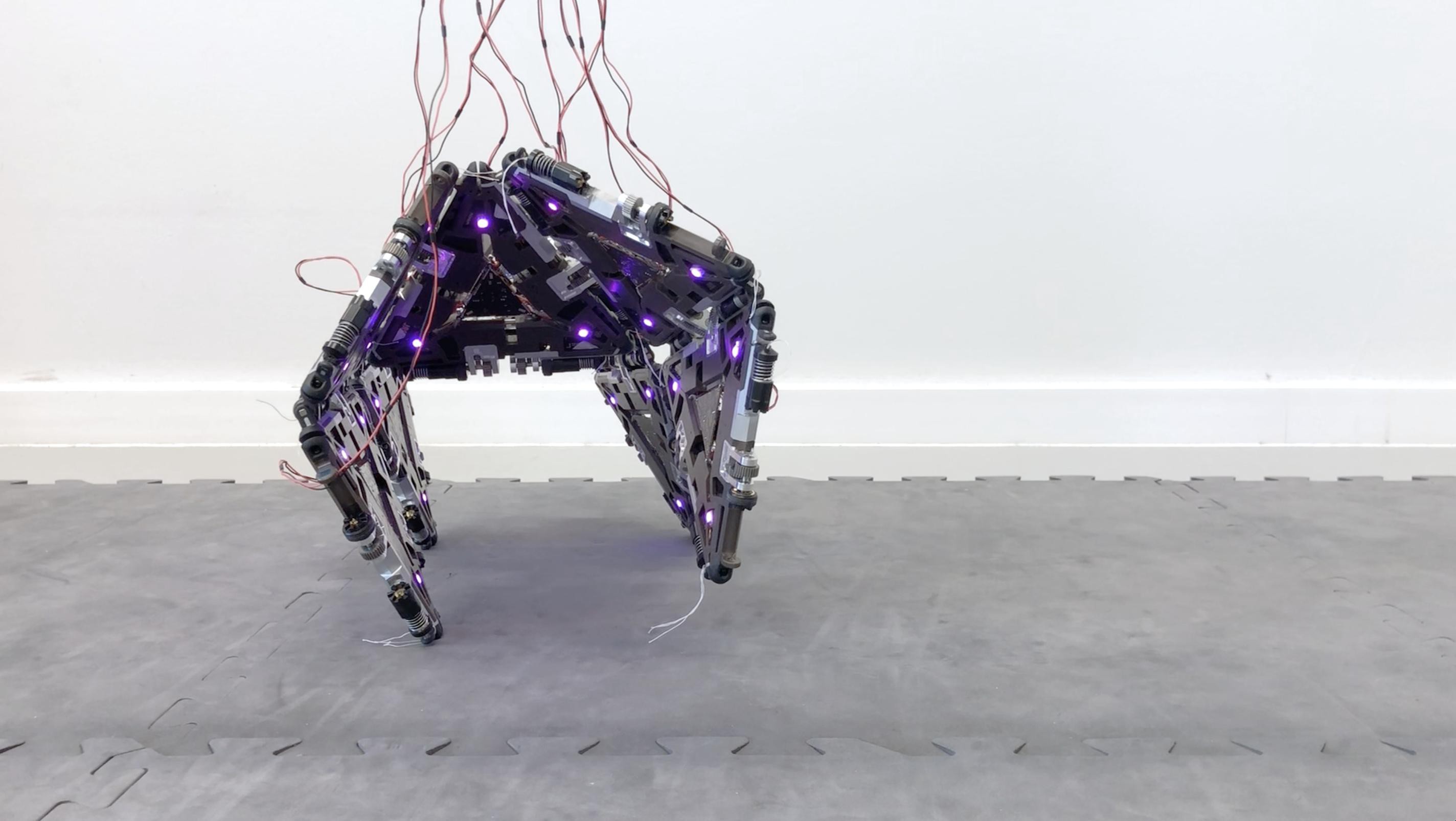

(三) 第三波熱潮(2000年~現在):深度學習的時代

自 2000 年起,半導體技術的進步,提升了電腦運算的能力;半導體的成本下降,讓雲端儲存的使用變得便宜。而透過雲端伺服器蒐集而來的大數據(Big Data),則成為了 AI 發展最重要的資源。

2016年,Google 開發的人工智慧 AlphaGo,打敗南韓棋王李世乭後,讓 AI 的發展再次受到重視。2018 年,美國國際研究暨顧問公司 Gartner「十大技術趨勢」報告中指出,AI技術是近年科技發展的重要目標,並預估 2018 年 AI 相關產業年產值達 1.2 兆美元,相較前一年成長 70%,2022 年相關產值則達 3.9 兆美元(Kasey Panetta, 2017;Gartner, 2018)。

而最新一期 2019「十大技術趨勢」報告中,除了原有 AI 技術外,其餘 AI 衍生或是相關技術也名列其中,可能在未來 5 年內快速成長,對於人類生活、產業發展、科學技術更有機會帶來顛覆性的影響(Gartner, 2019)。

進入「深度學習」時代的 AI 醫療應用

依據美國市調機構 CB Insights 的調研結果,從投資趨勢來看,自 2013 年起,美國 AI 醫療新創投資件數共 576 件,募資金額超過 43 億美元,位居 AI 新創相關產業募資首位,而 AI 醫療募資之案件數,也於 2018 年第二季達新高峰,AI 醫療受矚目的程度,可見一斑(Kyle Wiggers, 2018)。

AI 醫療的應用,進入「深度學習」的時代,除了將大量生理資訊輸入電腦,透過拋轉、整合、計算與紀錄,作為醫護團隊預測參考依據外,目前較主流的應用仍為醫學影像辨識。以台灣為例,國人每年平均看診次數約為 15 次,所累積的處方簽高達 3 億 6 千萬張;每年約有 200 萬人次使用電腦斷層與核磁共振等影像檢查,以肺部電腦斷層掃瞄為例,每進行一次電腦斷層掃瞄便可產生 500 張影像,一位有經驗的醫師進行初步篩選至少就要花 20 分鐘。

醫療技術的進步,讓診斷更為細緻,疾病的分類則變得更為複雜。傳統影像辨識,靠的是醫師肉眼的判斷與經驗,一旦醫療數據增多、辨識時間拉長,長時間的工作帶來的疲乏,加上疾病的高複雜度,使醫師犯錯的機率提高(王若樸-c, ,2019; 基因線上,2018)。

醫療影像辨識的發展,可追溯到 2012 年,由 Google 所建立的 ImageNet,一個開放使用的圖像辨識測試數據庫,參賽者將深度學習應用到ImageNet,使圖樣辨識準確度高達 85%,在當年電腦視覺比賽中奪冠,確認了深度學習在影像辨識的可行性。2016 年,Google 旗下的科研機構,發表了第一篇由機器深度學習進而提早發現糖尿病視網膜病變的論文,透過糖尿病患視網膜的影像辨識,早期偵測病變預防失明,技術研發成果後續將佈署於印度等眼科醫師缺乏的國家。

台灣實施全民健康保險迄今已 24 年,病歷電子化也即將邁入第 10 年,巨量的醫療數據累積,成為台灣發展 AI 醫療的利基。分析醫療數據的組成,除了基本的生理資訊外,絕大部分就是各類的影像資料,包含:X光片、超音波、核磁共振、電腦斷層、病理切片等。影像辨識技術的發展,除了要足夠的影像資料來「訓練」電腦,從數據獲取→分析→建立模組,最後才能回答問題或是預測未來。

過程中要如何讓電腦得到經驗,「理解」資料的特徵,達成「特徵表達學習」靠的就是專家知識的輸入,透過一群醫師針對影像進行標記,建置模組後再用影像試驗,並進行校正,影像標記是建立模組原型最重要的基礎,也會影響影像預測的準確性。目前AI醫療影像辨識的應用,也已逐漸在台灣發展,相關案例如下(王若樸-a,2019):

- 乳房超音波 AI 輔助分類系統:早期發現,腫瘤辨識度達 9 成,但良性、惡性的辨識度約 7 成。

- AI 骨齡輔助判讀系統:準確度可達 9 成 5。

- DeepMets:人工智慧腦瘤自動判讀系統,30 秒就能圈出病灶,還能自動計算腫瘤體積。

當然,開發中的醫療影像辨識技術遠比上述的例子多更多。2017 年科技部為了推動國人醫療影像在地化,建置 AI 醫療影像資料庫,提出「醫療影像專案計畫」。次年(2018)年底,台灣首座「AI 醫療影像」資料庫上線,15 類疾病,共 4.6 萬筆影像,目前已有 1/3 完成疾病辨識,資料庫影像開放供很多團隊一同開發演算法,目前有台大、北榮及北醫等團隊參與(吳元熙,2018)。

AI醫療不止步於影像辨識,還需發展文字語意辨識與分子生物檢測

醫學影像的辨識難度,會與最終影像的辨識準確度有關,除了需處理的影像數量多外,以肺部為例,其影像有很多血管紋,血管橫切面與肺結節十分相像,增加辨識難度。另外,以開發數位病理AI聞名的雲象科技為例,顯微鏡底下的病理切片影像,又是另外一個層次的首先面臨到的困難,就是病理切片影像傳換為數位影像,解析度非常高,超出電腦的運作能力,必須裁切成小區塊來訓練,以建立模組。初步完成鼻咽癌 AI 模組,自動標示癌症的高風險區,準確度達 97%。全新挑戰則是全球幾乎沒有人在做的數位病理 AI-血癌偵測模組,需辨識近 40 種不同種類或成熟度的骨髓細胞(王若樸-b,2019)。

然而,AI 醫療的應用,不僅止於醫療影像辨識,目前正在發展的還包含文字與語意辨識、分子生物檢測等。以文字與語意辨識為例:全球首建肺癌病灶語意描述資料庫,過去的診療經驗,最關鍵的往往是問診的語句,其中夾帶足以判斷疾病的關鍵,卻無法單純從影像或是病歷中察覺。因此,除了既有的影像病灶標記外,北醫附醫的研究團隊更嘗試加入病灶語意描述,希望藉由AI的協助,讓醫師早一步發現肺癌。

以分子生物檢測為例,藉由目前生物技術的發展,病人基因檢測或蛋白質體學檢測等變得相對容易,依據過去疾病的文獻研究,某些疾病的發生或是疾病發展的進程,可能與基因突變(或遺傳)或基因表現異常有關,如果能藉由病理數據、影像與基因變異之間,建立相關性的分析模組,希望進一步能達成降低早期風險或疾病的發生,或是預測病人預後狀況等。

AI 醫療的應用,可以藉由深度學習來增加準確度,而電腦學習的模式,必須由專家知識的輸入(給予框架或答案)來決定模組的原型,目前醫事人力的短缺,是阻礙AI醫療發展的原因之一。另外,AI 於醫療之應用與其他產業的差別在於,醫療往往沒有標準答案,還有太多的例外,以及一些「只能意會、無法言傳」的醫師經驗累積,這些都會影響電腦的訓練結果,以及最終診斷的準確度與一致性。

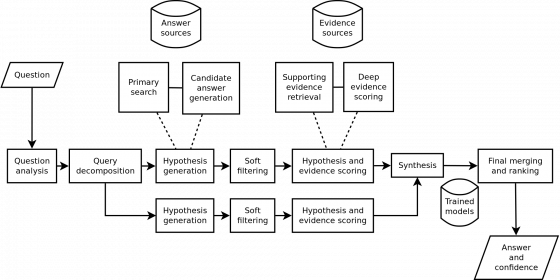

醫療領域最知名的 AI 應用,就不能不提 IBM 的超級電腦-華生(Waston),主要以自然語言訓練,從2011年發展至今,華生的腫瘤系統已在全球超過 230 家醫院使用,而近年華生醫生的發展聲勢卻持續下跌,原因出在:

- 華生雖透過大量文獻資料、診斷紀錄等訓練,但效果仍與醫師診斷有著很大的差距,例如:對於醫療方法的選擇,無法提出具體而合理的解釋,更可能因為無法通盤考量病患條件,而做出不適切之診斷,顯見其電腦學習資料量不足;

- 另因應疾病與醫療的變化,須輸入新資料供系統學習,而新舊資料整合不易且所費不貲,這些臨床應用的瓶頸,終將讓華生輪為第二、第三線的醫療諮詢系統,或是為節省成本而捨棄不用,這些都必須在AI醫療的發展與應用上,引以為鑑(陳苓,2017)。

- 最後一點,卻也是最重要的,便是相關法規及配套措施,包含技術開發與資料管理規範,建議相關部會積極主動研議,並透過跨部會合作,提出具體規範,才能讓台灣的 AI 醫療發展得更為順利(王郁倫,2019)。

參考文獻

- PingWest (2017)。Google最新成果:利用神經網路讓糖尿病患者擺脫失明。科技新報TechNews

- 王若樸-a (2019)。【AI浪潮席捲醫療業】剖析醫療影像AI爆紅主因。。iThome。

- 王若樸-b (2019)。【醫療影像AI新創:雲象科技】鼻咽癌AI偵測模組準確率已達97%,接著要挑戰血癌辨識AI。iThome。

- 王若樸-c (2019)。【醫療影像AI實例:北醫附醫】全球首建肺癌病灶語意描述資料庫,要開發兼具準確度和高精細度的AI系統。iThome。

- 王郁倫 (2019)。台灣發展AI醫療,為何品牌教父施振榮籲衛福部該有「擔當」?。數位時代。

- 曲建仲 (2018)。機器是如何學習與進步?人工智慧的核心技術與未來。科學月刊49(4): p282-291。

- 吳元熙 (2018)。台灣首座醫療影像標註資料庫上線,2秒鐘完成醫師工作。數位時代。

- 基因線上 (2018)。《AI,醫療,大數據》-專訪北醫大醫學科技學院院長李友專教授。基因線上。

- 陳苓 (2017)。IBM華生又挨批,診斷癌症效果差、無法提高醫療品質。MoneyDJ新聞

- 盧傑瑞 (2018)。人工智慧即將衝擊與改變現有醫療方式。CTIMES 319: p55-60。

- Gartner (2018). Gartner Says Global Artificial Intelligence Business Value to Reach $1.2 Trillion in 2018.

- Kasey Panetta (2017). Gartner Top 10 Strategic Technology Trends for 2018.

- Kasey Panetta (2018). Gartner Top 10 Strategic Technology Trends for 2019.

- Kyle Wiggers (2018). CB Insights: AI health care starts have raised $4.3 billion since 2013.

- 本文轉載自《Research Portal(科技政策觀點)》,原文為〈淺析台灣人工智慧醫療之發展〉。