11/9 更新:美國人民已經做出選擇,川普當選第四十五任美國總統,本文標題隨之更改。

編譯 / 鄭國威

在台灣的我們雖然只是隔山觀虎鬥,但這次美國總統大選真的是史無前例大亂鬥,而且不管鬥勝的人是誰,當上總統後,勢必在全球掀起極大的海嘯,台灣也是波及的範圍,應該算是「海景第一排」。因為政治牽動著政策,而科學時常淪為犧牲品或玩物。如今結果已經揭曉,川普當選。我們再一起看看《科學》期刊給下一任美國總統的六堂課,如果你還沒看過上篇,請先看完再接著看這篇!

接下來三堂課,分別是「痴」、「智」、「直」。

第四堂課:昂貴的「痴」心

「大腦是個好東西,每個人都該有一個。」

我們愛說這略帶調侃意味的句子,來回應生活中那些難以溝通、理解的人事物,其實我們自己的大腦也都面臨著「淡出」與「漸弱」的風險,誰也說不準哪一天我們會否也成為電影《我想念我自己》的故事主角。

隨著電腦演算力大規模提升,光遺傳學(Optogenetics)等多種新工具加速發展,研究人員對大腦理解越來越深。大腦裡 860 億個神經元彼此之間有數以兆計的連結,控制我們如何理解、記憶、運動、跟睡眠,而我們的經驗、生活型態、受過的傷害和疾病,都在不斷重新雕塑神經元網絡。過去曾以為神經元數量在出生後就不會變了,但現在我們知道某些腦區的神經元會持續生長。現在,研究者已經能夠調控神經元並觀察他們運作的即時樣貌。

要是我們的大腦生病,很難避免鉅額的開支,個人與政府的負荷都很重。《科學》期刊指出到 2025 年,可能多達 7 百萬美國人都受阿茲海默症之擾,導致記憶力下降、性格改變、理智不再,受苦而終。在 2016 年,為了醫治與照料阿茲海默症與其他較罕見的失智症患者,總花費就達到 2360 億美元,其中政府的健康方案就負擔其中的三分之二。老年人這端尚且如此,幼童這端的大腦問題又是另一番挑戰,從 2002 年到 2012 年,自閉症的患病率增加了 123% ,每 68 名美國兒童中,就有 1 位有自閉症,而因此,這些家庭每年估計得花 60,000 美元來應對。

腦的問題不僅於此,例如,學校裡學生的學習障礙已經是一個大問題、無家可歸者、吸毒者、監獄的囚犯罹患精神疾病越來越普遍,運動員的腦震盪不容輕忽,從戰場上歸來的美國軍人同時面對生理上的腦創傷和心理上的創傷後遺症,這些問題都有賴更有效的診斷跟治療,帶來更大的改善。

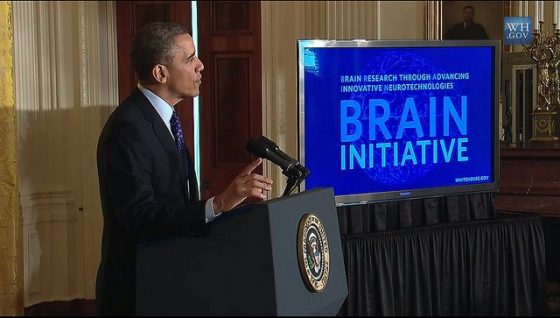

下一任美國總統需要擬定計畫,提升照顧老年人腦部疾病的支出,並決定腦研究預算的優先分配。2014 年以來,美國聯邦機構花在歐巴馬政府提出的「先進創新神經科技腦研究計畫」(Brain Research through Advancing Innovative Neurotechnologies Initiative,簡稱 BRAIN Initiative)上投入了 7.5 億美元,下一任政府要決定接下來是要繼續還是改弦易轍,另一方面倡議團體也在積極運作,希望政府投入更多研究經費來解決從腦癌到阿茲海默症等各種腦的大哉問。

2016 年投入在阿茲海默症上的資金增長了大約 3.5 億美元,明年美國國會預期將支持同規模的增長,而同時,許多執法機構正在找更多資金,來支持監獄與刑事司法程序相關的精神健康計畫,這代表下一任美國總統要能在反擴增預算的氛圍下,平衡這些相互競爭資源的計畫,尤其是在諸於醫療保險計劃強制支出日益增加,可用資金受限的前提下。這動輒得咎的處境,有請下一任美國總統川普好好思量。

第五堂課:淘汰工人的人工「智」慧

「那一天,人類終於回想起了,曾經一度被他們所支配的恐怖,還有被囚禁於鳥籠中的那份屈辱。」

這是《進擊的巨人》中的經典名句,也很適合用來替人工智慧時代揭幕。

日益強大的處理器,搭配上能夠從海量數據與現實世界中尋找模式的複雜演算法,讓人工智慧的許諾從科幻一步步落實在我們的生活,例如你的電話現在聽得懂你在說什麼,你的車子可以自己上路(或許還能幫你判斷對方車子板金厚度)。而今年三月,Google 的 AlphaGo 擊敗韓國圍棋棋王,跌破許多 AI 專家的護目鏡。現在 AI 更能準確識別圖像、協助作出投資決策、控制交通流量與能源系統,或者讓廣告主投放更精準的廣告等。

儘管專家表示,要做出能比肩人類的人工智慧還要好幾十年,但一些特定用途的 AI 應用已經對社會產生影響,例如無人自動駕駛車、醫療指導機器人等等,可以提高勞動效率、創造利潤豐厚的新市場,減少交通事故傷亡與看病時的誤診。

有令人引頸期盼的一面,也有麻煩的一面。更多的公司將採用 AI 取代員工,越低階的工作越可能被淘汰,經濟階級上的不平等可能因此加劇。另外,我們將決策權交給機器,也會帶來複雜的倫理、法律跟監管問題。無人自駕車出車禍,誰負責?軟體搞砸了投資組合,找誰賠?傳感器在錯誤的時間切換紅綠燈,誰的錯? 更別提戰場上的自主殺傷性武器了,槍砲自己開火了之後,誰扛?

下一任美國總統將做出許多關於人工智慧的決定,舉例來說,眾多企業都迫不及待想讓每條路上都跑著自駕車,每片天空都飛著無人機,因此希望美國聯邦監管機構可以趕快把規定講清楚說明白。另外,美國政府該投資多少錢在研究人工智慧上呢?目前每年投資約十億美金,夠不夠?政府也必須密切關注人工智慧對經濟、勞動、和國家安全的影響,不然一旦出大包,波及的可能是全地球。

第六堂課:對風險的「直」覺反應才危險

專家預測風險,靠得是數據,而普通人則多半靠直覺,但兩者都可以「騙」很大。

奧瑞岡大學的風險心理學研究者保羅斯洛維克(Paul Slovic)認為兩種形式都有利,亦有弊。靠直覺的問題很顯著,例如我們會高估駭人事物出現的機率,並且低估我們已經熟悉的風險事故,例如 911 恐怖攻擊之後,恐怖份子又奪走了數百名美國人的生命,很恐怖對吧?但在同一段時間,死於汽車事故的人超過 50 萬,死於心臟病的約有 8 百萬,這些更大規模的致死原因我們倒是習以為常。

好吧,或許恐怖攻擊跟汽車肇事與心臟病無法相提並論,但你會發現,我們對於其他人道危機,如數十萬人正在經歷的飢餓、貧窮、與喪生,其實也蠻無感的。斯洛維克認為我們對這類大災難數據的反應太輕微。另外,像是氣候變遷導致的經濟問題、公共衛生衝擊,這種緩慢發展且影響的地區很廣的威脅,我們也總是低估。因此,下一任美國總統起碼要明白別靠著直覺的評估來辨識風險的程度。

另一方面,專家的風險評估有時就像披上數學外衣的謊言,因為下判斷的那刻,專家也得決定哪些數字才是要緊的,以及要用什麼方式來表達風險的程度。

舉例來說,如果有毒化學物質外洩,專家可能僅以預期死亡人數來描述風險,而這數字通常看起來很小,但換個方式,若改用罹患某種罕見癌症的機率可能會提升多少來描述風險,這數字看起來就會很大,而造成的公眾認知也會截然不同。專家自己也可能有各自的偏頗跟意圖推動的目的,從而影響了我們對風險的認知。

對一位總統來說,若對風險有錯誤的認知,將造成反應過度或反應不夠,有可能因此搞了一些只是讓人們感覺良好,但其實要花大錢又沒效率的政策,更別提可能造成禍害。

總統與公眾溝通風險的方式,就是在散播恐慌與維持社會冷靜之間做選擇。

若能預先、實事求是地做好風險溝通,而非承諾做到百分百保障,更能幫助人們做好準備,以面對無法避免的災難。總會有人要求過度的政策來應對威脅,唯有做好風險溝通,才能減少這種要求。

要做到這點,公眾得要信任這位總統,而我們都知道公眾信任難以掌握,「得之我幸,不得我命」。《科學》期刊建議準總統學學風險心理學,免得撞上民意之牆。畢竟各種已知的風險議題(恐攻、國際紛爭、國內犯罪暴力、流感與傳染病、自然災害)就已經夠累了,虎視眈眈的新科技議題(DNA 編輯、無人自駕車)又即將撲來,未來美國總統的重要任務就是正確地評估風險、與公眾溝通、提出有感的政策贏得選民、產業、以及從地方到聯邦的議員支持。

沒有完美的政治人物,這次的美國總統當選人川普顯然也離完美很遠,但像美國這等大國,其決策仍將會影響台灣以及全世界,就讓我們密切關注,期待新美國總統川普會怎麼做吧!

- 《科學》也用簡單的影片來總結這六堂課,直接點擊觀看!

原始報導:David Malakoff & Jeffrey Mervis, Science lessons for the next president, Science, 2016.10.20.