停工即停薪:如何證明你的時間值多少?車禍背後的認知 x 情緒 x 金錢 x 法律大混戰

本文與 PAMO車禍線上律師 合作,泛科學企劃執行

走在台灣的街頭,你是否發現馬路變得越來越「急躁」?滿街穿梭的外送員、分秒必爭的多元計程車,為了拚單量與獎金,每個人都在跟時間賽跑 。與此同時,拜經濟發展所賜,路上的豪車也變多了 。

這場關於速度與金錢的博弈,讓車禍不再只是一場意外,更是一場複雜的經濟算計。PAMO 車禍線上律師施尚宏律師在接受《思想實驗室 video podcast》訪談時指出,我們正處於一個交通生態的轉折點,當「把車當生財工具」的職業駕駛,撞上了「將車視為珍貴資產」的豪車車主,傳統的理賠邏輯往往會失靈 。

在「停工即停薪」(有跑才有錢,沒跑就沒收入)的零工經濟時代,如果運氣不好遇上車禍,我們該如何證明自己的時間價值?又該如何在保險無法覆蓋的灰色地帶中全身而退?

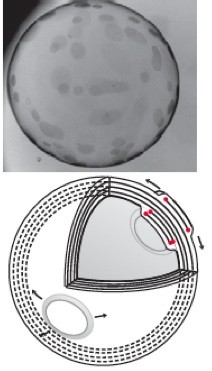

如果運氣不好遇上車禍,我們該如何證明自己的時間價值?/ 圖片來源: Nano Banana

薪資證明的難題:零工經濟者的「隱形損失」 過去處理車禍理賠,邏輯相對單純:拿出公司的薪資單或扣繳憑單,計算這幾個月的平均薪資,就能算出因傷停工的「薪資損失」。

但在零工經濟時代,這套邏輯卡關了!施尚宏律師指出,許多外送員、自由接案者或是工地打工者,他們的收入往往是領現金,或者分散在多個不同的 App 平台中 。更麻煩的是,零工經濟的特性是「高度變動」,上個月可能拚了 7 萬,這個月休息可能只有 0 元,導致「平均收入」難以定義 。

這時候,律師的角色就不只是法條的背誦者,更像是一名「翻譯」。

施律師解釋「PAMO車禍線上律師的工作是把外送員口中零散的『跑單損失』,轉譯成法官或保險公司聽得懂的法律語言。」 這包括將不同平台(如 Uber、台灣大車隊)的流水帳整合,或是找出過往的接單紀錄來證明當事人的「勞動能力」。即使當下沒有收入(例如學生開學期間),只要能證明過往的接單能力與紀錄,在談判桌上就有籌碼要求合理的「勞動力減損賠償 」。

PAMO車禍線上律師的工作是把外送員口中零散的『跑單損失』,轉譯成法官或保險公司聽得懂的法律語言 / 圖片來源: Nano Banana 300 萬張罰單背後的僥倖:你的直覺,正在害死你 根據警政署統計,台灣交通違規的第一名常年是「違規停車」,一年可以開出約 300 萬張罰單 。這龐大的數字背後,藏著兩個台灣駕駛人最容易誤判的「直覺陷阱」。

陷阱 A:我在紅線違停,人還在車上,沒撞到也要負責? 許多人認為:「我人就在車上,車子也沒動,甚至是熄火狀態。結果一台機車為了閃避我,自己操作不當摔倒了,這關我什麼事?」

施律師警告,這是一個致命的陷阱。「人在車上」或「車子沒動」在法律上並不是免死金牌 。法律看重的是「因果關係」。只要你的違停行為阻礙了視線或壓縮了車道,導致後方車輛必須閃避而發生事故,你就可能必須背負民事賠償責任,甚至揹上「過失傷害」的刑責 。

數據會說話: 台灣每年約有 700 件車禍是直接因違規停車導致的 。這 300 萬張罰單背後的僥倖心態,其巨大的代價可能是人命。

陷阱 B:變換車道沒擦撞,對方自己嚇到摔車也算我的? 另一個常年霸榜的肇事原因是「變換車道不當」 。如果你切換車道時,後方騎士因為嚇到而摔車,但你感覺車身「沒震動、沒碰撞」,能不能直接開走?

答案是:絕對不行。

施律師強調,車禍不以「碰撞」為前提 。只要你的駕駛行為與對方的事故有因果關係,你若直接離開現場,在法律上就構成了「肇事逃逸」。這是一條公訴罪,後果遠比你想像的嚴重。正確的做法永遠是:停下來報警,釐清責任,並保留行車記錄器自保 。

正確的做法永遠是:停下來報警,釐清責任,並保留行車記錄器自保 。/ 圖片來源: Nano Banana

保險不夠賠?豪車時代的「超額算計」 另一個現代駕駛的惡夢,是撞到豪車。這不僅是因為修車費貴,更因為衍生出的「代步費用」驚人。

施律師舉例,過去撞到車,只要把車修好就沒事。但現在如果撞到一台 BMW 320,車主可能會主張修車的 8 天期間,他需要租一台同等級的 BMW 320 來代步 。以一天租金 4000 元計算,光是代步費就多了 3 萬多塊 。這時候,一般人會發現「全險」竟然不夠用。為什麼?

因為保險公司承擔的是「合理的賠償責任」,他們有內部的數據庫,只願意賠償一般行情的修車費或代步費 。但對方車主可能不這麼想,為了拿到這筆額外的錢,對方可能會採取「以刑逼民」的策略:提告過失傷害,利用刑事訴訟的壓力(背上前科的恐懼),迫使你自掏腰包補足保險公司不願賠償的差額 。

這就是為什麼在全險之外,駕駛人仍需要懂得談判策略,或考慮尋求律師協助,在保險公司與對方的漫天喊價之間,找到一個停損點 。

談判桌的最佳姿態:「溫柔而堅定」最有效? 除了有單據的財損,車禍中最難談判的往往是「精神慰撫金」。施律師直言,這在法律上沒有公式,甚至有點像「開獎」,高度依賴法官的自由心證 。

雖然保險公司內部有一套簡單的算法(例如醫療費用的 2 到 5 倍),但到了法院,法官會考量雙方的社會地位、傷勢嚴重程度 。在缺乏標準公式的情況下,正確的「態度」能幫您起到加分效果。

施律師建議,在談判桌上最好的姿態是「溫柔而堅定」。有些人會試圖「扮窮」或「裝兇」,這通常會有反效果。特別是面對看過無數案件的保險理賠員,裝兇只會讓對方心裡想著:「進了法院我保證你一毛都拿不到,準備看你笑話」。

相反地,如果你能客氣地溝通,但手中握有完整的接單紀錄、醫療單據,清楚知道自己的底線與權益,這種「堅定」反而能讓談判對手買單,甚至在證明不足的情況下(如外送員的開學期間收入),更願意採信你的主張 。

車禍不只是一場意外,它是認知、情緒、金錢與法律邏輯的總和 。 在這個交通環境日益複雜的時代,無論你是為了生計奔波的職業駕駛,還是天天上路的通勤族,光靠保險或許已經不夠。大部分的車禍其實都是小案子,可能只是賠償 2000 元的輕微擦撞,或是責任不明的糾紛。為了這點錢,要花幾萬塊請律師打官司絕對「不划算」。但當事人往往會因為資訊落差,恐懼於「會不會被告肇逃?」、「會不會留案底?」、「賠償多少才合理?」而整夜睡不著覺 。

PAMO看準了這個「焦慮商機」, 推出了一種顛覆傳統的解決方案——「年費 1200 元的訂閱制法律服務 」。

這就像是「法律界的 Netflix」或「汽車強制險」的概念。PAMO 的核心邏輯不是「代打」,而是「賦能」。不同於傳統律師收費高昂,PAMO 提倡的是「大腦武裝」,當車禍發生時,線上律師團提供策略,教你怎麼做筆錄、怎麼蒐證、怎麼判斷對方開價合不合理等。

施律師表示,他們的目標是讓客戶在面對不確定的風險時,背後有個軍師,能安心地睡個好覺 。平時保留好收入證明、發生事故時懂得不亂說話、與各方談判時掌握對應策略 。

平時保留好收入證明、發生事故時懂得不亂說話、與各方談判時掌握對應策略 。 / 圖片來源: Nano Banana 從違停的陷阱到訂閱制的解方,我們正處於交通與法律的轉型期。未來,挑戰將更加嚴峻。

當 AI 與自駕車(Level 4/5)真正上路,一旦發生事故,責任主體將從「駕駛人」轉向「車廠」或「演算法系統」 。屆時,誰該負責?怎麼舉證?

但在那天來臨之前,面對馬路上的豪車、零工騎士與法律陷阱,你選擇相信運氣,還是相信策略? 先「武裝好自己的大腦」,或許才是現代駕駛人最明智的保險。

PAMO車禍線上律師官網: https://pse.is/8juv6k

-200x200.jpg)