本文由 Fox Movies 委託,泛科學企劃執行

- 文/火星軍情局

《魔鬼終結者》第一集問世至今已經 35 年,即使阿諾 T-800 的肌肉不復以往,革命之母莎拉康納也升等為革命祖母,卻還要在即將上映的《魔鬼終結者:黑暗宿命》裡繼續為人類的生存戰鬥,看來在魔鬼終結者宇宙裡的人工智慧「天網」是不會這麼容易被打敗的,續集還有得演下去了。

回到現實,魔鬼終結者的世界會成為我們的未來嗎?一起來看看電影裡有哪些威脅是人類真正該擔心的吧!

可能威脅一:覺醒的AI會試圖消滅人類?「天網」可能出現嗎?

在《魔鬼終結者》裡,「天網」是美軍研發的超級電腦,可控制美軍的自動化武器系統,並透過人工智慧來制敵機先。想不到它啟動不久就自行發展出自我意識,領悟到人類才是它的真正威脅,而發動核戰消滅人類。在人工智慧開始蓬勃發展的現在,我們該開始擔心哪一天這世界會被像天網的人工智慧給毀滅嗎?

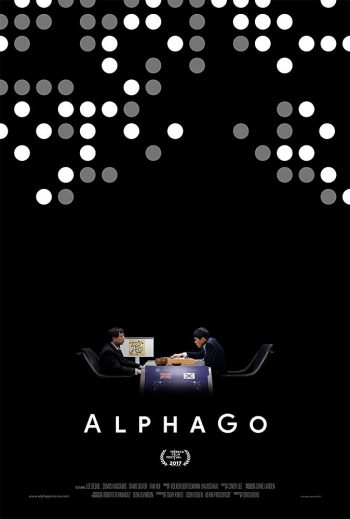

目前的人工智慧是只能處理單一的問題「弱人工智慧」,說穿了就是讓電腦從大量數據中歸納出統計上的規律,與「人工意識」沒有關係。像是 2016 年非常火熱的 Alpha Go 就屬於此類:它雖然能夠擊敗世界第一的圍棋高手,但離開了棋盤它就什麼也不是。這類的弱人工智慧還包括我們生活中時常可以看見的某些資訊應用,包括 Youtube 網站上的推薦影片、Google Map 的路線規劃。但可想而見,這些只能提供特定服務的程式,與我們期待會與人們互動討論的「智慧」還差得很遠。

雖然現在有的機器在與人互動時能展現出個性和意識,但那並不是真的意識,像是會和使用者抬槓的蘋果 iOS 系統智慧助理 Siri,雖然它會在你問出某些問題時給出「有個性」的解答,但這仍然是基於工程師的設定。目前能展現出個性與意識的人機互動,基本上都是透過設定讓它表現得「讓人覺得」它有意識。

Siri有些回答真的很有個性啊!

「天網」這種領悟到自身存在、要保護自我、會分析未來、甚至推翻創造者交付的任務,這都是有處理通用問題的「強人工智慧」(Strong AI)才具備的能力,今天的人工智慧技術還差得遠。而且即使有強人工智慧的運算能力的電腦也未必能自行產生「意識」。1

人工智慧學者們多認為機器終將獲得意識,但什麼時候來?每個人的看法不一。未來大師 Ray Kurzweil 曾預測這一天會在2029年來臨2,有人說這預測太過樂觀,還有其他大師級的人物說這是八字沒一撇的事。有AI教父之稱的Yoshua Bengio在最近BBC的專訪中說:「或許人工意識違反了目前未知的基本理論,根本無法達到。」3

傷腦筋,到底該聽誰的?若你很好學、試著自己到Google Scholar去找「artificial consciousness」的相關資料,就可以看出這個領域還停在基礎數學的定義和哲學道德的探討,並沒有人真的在動手做人工意識,很難相信在可預見的未來「天網」會成真。

威脅程度:輕微。

可能威脅二:人工智慧當殺手,殺手機器人即將誕生?

SpaceX和 Tesla的創辦人伊隆·馬斯克 (Elon Musk) 曾說:「人工智慧武器比核武更具革命性,更可怕。」還記得 2 年前他曾經與一百多位的 AI 專家簽署一封公開信,籲請聯合國禁止使用人工智慧的殺手機器人嗎?4那時候這封公開信得到全世界的共鳴,所以可怕的殺手機器人應該會被禁,未來世界很安全吧。

在世人眼中黑科技代表的SpaceX創辦人馬斯克也主張人工智慧不應武器化,可見其威脅程度了。

事實上聯合國沒在理睬,而且各國也各自悄悄地發展,把人工智慧加在陸、海、空、太空、和網路上的武力上,然後用「自動化防禦系統」之類的詞來沖淡AI的色彩。先不管天網那樣的科幻情節,現在馬上就會碰到的問題是:機器憑什麼決定誰該死?如何確定機器在瞬息萬變的戰場上不會出錯?但也有人認為由人工智慧操作武器反而更安全、精準,甚至可以承受對方先開火後再展開第二擊,而且就算機器會出錯,也比20來歲緊張的新兵好吧。5

你覺得人工智慧武器化是不道德的嗎?那麼請你心裡想一個你心目中的「敵國」,請問那個國家可不可能正在發展人工智慧武器?如果是,那你能忍受未來自己的國家因為道德上的堅持而在戰場上被吊打嗎?正因每個國家都這麼想,所以人工智慧武器化變成一個無法阻擋的潮流。

波士頓動力機器人的設計很接近人形,並且有相當不錯的適應地形能力。

這些武器的外型會像魔鬼終結者那樣的人形機器人嗎?是有可能的。人形機器人的優點就是能立刻融入人類的環境:上下樓梯、操作武器與工具、開車,大家熟知的波士頓動力機器人 (Boston Dynamics) 就是因此致力於人形機器人的發展,而俄國的機器人 Fedor 更曾光明正大地在媒體前開槍打靶。對了,兩個月前俄國還送了一台 Fedor 上了國際太空站喔,只有我覺得這是科幻恐怖片的前奏嗎?

智慧型的武器也未必要人型,甚至不一定要有形體,最可怕的人工智慧武器可能根本不需一槍一彈就可操控其他國家的政治、輿論和經濟,或許我們正在目睹這種人工智慧武器的演化過程。

威脅程度:高

可能威脅三:機器會毀滅世界、奴役人類?

既然剛才說短期內不會有電腦覺醒後立志殺滅人類,那就不會有機器毀滅世界或奴役人類這樣的事了吧──不見得,那要看我們怎麼定義「毀滅世界」。

如果毀滅是像「審判日」那樣的末世情景,那不至於;但如果我們放任人工智慧的發展,那人類有可能過著奴隸的生活。倒不是說是被機器奴役,而是人藉著人工智慧的優勢來奴役其他人。

套一句知名深度學習研究者、於2018年得過圖靈獎的科學家 Yoshua Bengio 的話:「人工智慧主宰人類並不是問題,人如何誤用人工智慧才是問題。人工智慧會怎麼導致社會不均?會怎麼用來控制人民?會怎麼武器化?」3

如果只有少數人能擁有昂貴的電腦運算,也就只有少數人能接觸快速且全面的資訊。當人工智慧的能力越來越大,這些少數人與其他人的差距就有了天壤之別;他們就好像有了全知全能的神力,讓他們累積更多資源來取得更大的能力。

舉個例子,如果有人工智慧版的高頻交易,不但可以預測股市走勢、甚至能有炒短線的能力,就算預測的時間差只有提早 0.1秒,他的主人仍可以在短時間內藉大量買賣而獲取暴利。其他還靠人腦的無辜股民們根本無法跟上他的速度,只能當韭菜被收割,老百姓的血汗積蓄就間接到了他們的口袋中,這在意義上就是奴役了。

你現在有沒有被機器統治的心理準備?

威脅程度:高

究竟人類的未來與人工智慧會是怎樣的關係?人工智慧是否會徹底改變、甚至摧毀人類的文明呢?我們只能耐心等繼續看下去了。

在此之前,《魔鬼終結者:黑暗宿命》即將於 11 月 7 日上映,可以先看看《魔鬼終結者系列》正宗第三集,體會一下人類與 AI 相愛相殺 (?)的動作片吧!

Reference

- Subhash Chandra Pandey. Can artificially intelligent agents really be conscious? |. Sādhanā. 2018;43.

- Goldman I by A. Ray Kurzweil Says We’re Going to Live Forever. The New York Times. 25 Jan 2013.

- Lee SS Dave. Terminator sends shudder across AI labs. BBC News. 25 Oct 2019.

- Gibbs S. Elon Musk leads 116 experts calling for outright ban of killer robots. The Guardian. 20 Aug 2017.

- Etzioni A, Etzioni O. Pros and cons of autonomous weapons systems. Military Review, May-June. 2017.

本文由 Fox Movie 委託,泛科學企劃執行